Künstliche Intelligenz

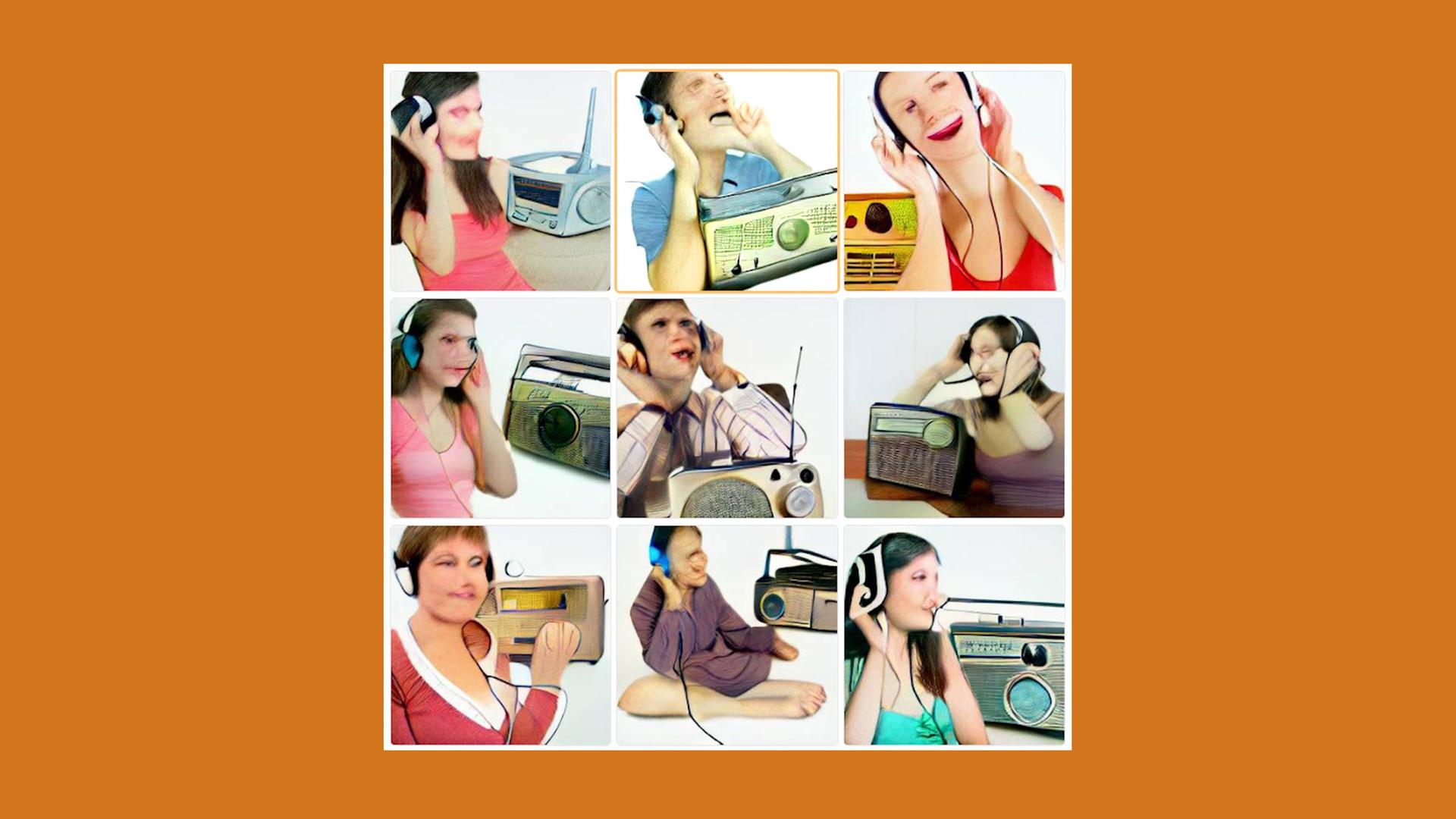

"Listening to the radio" à la Dall-E mini: Die Bilder sind meist noch unscharf, Gesichter verzerrt, Perspektiven verschoben. © Deutschlandradio / DALL·E

Lassen sich Bildgeneratoren vor Missbrauch schützen?

06:35 Minuten

Die KI Craiyon kann Wörter und Sätze in Bilder umwandeln aus frei wählbarem Text. Bisher sind die Computerkreationen meist unterhaltsam. Aber sind die Bildgeneratoren vor Missbrauch geschützt?

Craiyon heißt die KI, die die meisten dieser Bilder generiert, die gerade durchs Netz gehen. Sie kann Wörter und Sätze in Bilder umwandeln. Die Bilder sind meist unscharf, Gesichter verzerrt, Perspektiven verschoben. Irgendwas stimmt nicht mit diesen Bildern, das ist offensichtlich. Die Gefahr, dass jemand sie für echt halten könnte, ist minimal.

Craiyon hieß anfangs Dall-E mini. Das große Dall-E ist nicht frei verfügbar und wird von dem Unternehmen OpenAI entwickelt. Die zweite Version, Dall-E 2, kann äußerst realistisch aussehende Bilder erzeugen.

Hinter Dall-E 2 steckt ein KI-Modell, das mit 250 Millionen Bildern und dazu passenden Bildbeschreibungen trainiert wurde. Es abstrahiert unter anderem Farbe, Form und Aussehen von Objekten und deren Position zueinander. Damit schafft es die KI, echt aussehende, fotorealistische Bilder zu kreieren.

Generatoren bislang nicht frei verfügbar

Nahezu gleichzeitig mit Dall-E 2 sind zwei andere Bildgeneratoren bekannt geworden: Imagen und Parti, beide von Teams bei Google entwickelt. Sie liefern ähnlich überzeugende Ergebnisse und auch sie sind bisher nicht frei verfügbar.

Wer bei OpenAI Zugang beantragt, muss Nutzungsbedingungen zustimmen, die schon den Versuch, beispielsweise nicht jugendfreie Bilder zu generieren, ausschließen. Bisher funktioniert dieser Schutz. Hinzu kommen technische Schutzmaßnahmen, etwa das Ausfiltern bestimmter Wörter aus den Anfragen an die KI.

„Auch eine Adaption der Trainingsdaten, damit zum Beispiel solche Modelle erst gar keine – oder sehr reduziert – brutale oder auch sexistische oder pornografisches Szenen oder so zu Gesicht bekommen und die somit lernen können“, sagt Christian Ledig, Professor für erklärbares maschinelles Lernen in Bamberg.

Eine KI, die nie Gewaltdarstellungen gesehen hat, kann auch keine Gewaltdarstellungen generieren. Außerdem können weitere Filter die generierten Bilder analysieren und problematische Inhalte verwerfen.

Aber es werden sich wohl immer Wege finden, solche technischen Schutzmaßnahmen zu umgehen. Und selbst wenn die Filter noch so gut funktionieren würden, sie würden immer nur das System des jeweiligen Anbieters vor Missbrauch schützen.

Schutzmechanismen schwer sicherzustellen

Aber Christian Ledig rechnet damit, dass es schon bald frei zugängliche Systeme ohne Schutzmechanismen geben wird. „Man kann davon ausgehen, dass in sehr naher Zukunft auch diese sehr starken Modelle ‚ge-open-sourced‘ werden und ein Stück weit Menschen oder Gruppierungen in der Lage sein werden, solche Modelle außerhalb von Google, OpenAI oder solchen großen Firmen zu bauen.“

Auch Martin Steinebach rechnet nicht damit, dass die Technik nur Google- und OpenAI-Kundinnen und -Kunden vorbehalten bleibt. Die Auswirkungen zeichnen sich schon ab. Während beim zugangsbeschränkten Dalle-E 2 keine Gesichter von Einzelpersonen generiert werden können sollen, akzeptiert Craiyon eine Eingabe wie „Angela Merkel hält eine Waffe“ problemlos.

Echtheit schwer zu ermitteln

Martin Steinebach beschäftigt sich am Fraunhofer Institut für Sichere Informationstechnologie unter anderem mit Forensik, also der Frage, ob und wie sich feststellen lässt, ob ein Foto echt ist oder aus einem KI-Modell stammt: „Hat das natürliches Rauschen, hat das natürliche Eigenschaften, sieht das so aus, als ob das nicht mit einer Kamera aufgenommen worden wäre oder hat das Eigenschaften, die eher aus nem Renderer, aus nem Ray-tracer stammen und so.“

Der Idee, dass etwa Social-Media-Plattformen eine Software anschaffen könnten, die eine solche forensische Analyse automatisch vornimmt, um dann computergenerierte Bilder entsprechend zu markieren, erteilt er eine Absage. Zu selten sei das Ergebnis eindeutig. Eine verlässliche Echtzeitanalyse scheint kaum möglich.

„Die Forensik ist üblicherweise eher eine Post-Mortem-Geschichte, bei dem ich dann einen Vorfall mir anschaue, mir in aller Ruhe Dinge betrachte, mit mehreren Experten über irgendwas schaue, dann ein Gutachten verfasse und erkläre, was da wahrscheinlich vorgefallen ist“, sagt er.

Missbrauch vorprogrammiert

Technisch wird sich dem Missbrauch also kein Riegel vorschieben lassen. Während die KIs kreativ werden, vielleicht Künstlerinnen und Künstler inspirieren oder in Zukunft ganze künstliche Welten erschaffen, werden sie mit Sicherheit auch genutzt werden, um Lügen, Fake News und Hass zu verbreiten.

„Das heißt, man wird sich damit auseinandersetzen müssen, wie geht man als Individuum oder als Gesellschaft damit um, wenn diese Technologie ein Stück weit frei verfügbar ist, ohne großartige Begrenzungen in der Benutzung?“, sagt Christian Ledig.

„Und da finde ich, um den Bogen zu Dall-E mini zu schließen, das eben sehr interessant, dass man jetzt momentan ein bisschen die Dynamiken und auch die Risiken sieht und auch ein bisschen geschult wird, wie man mit solchen neuen Technologien umgeht, solange sie noch nicht ganz so mächtig sind, wie sie in ein, zwei Jahren sein werden.“