Steht uns Kriminalität ins Gesicht geschrieben?

08:36 Minuten

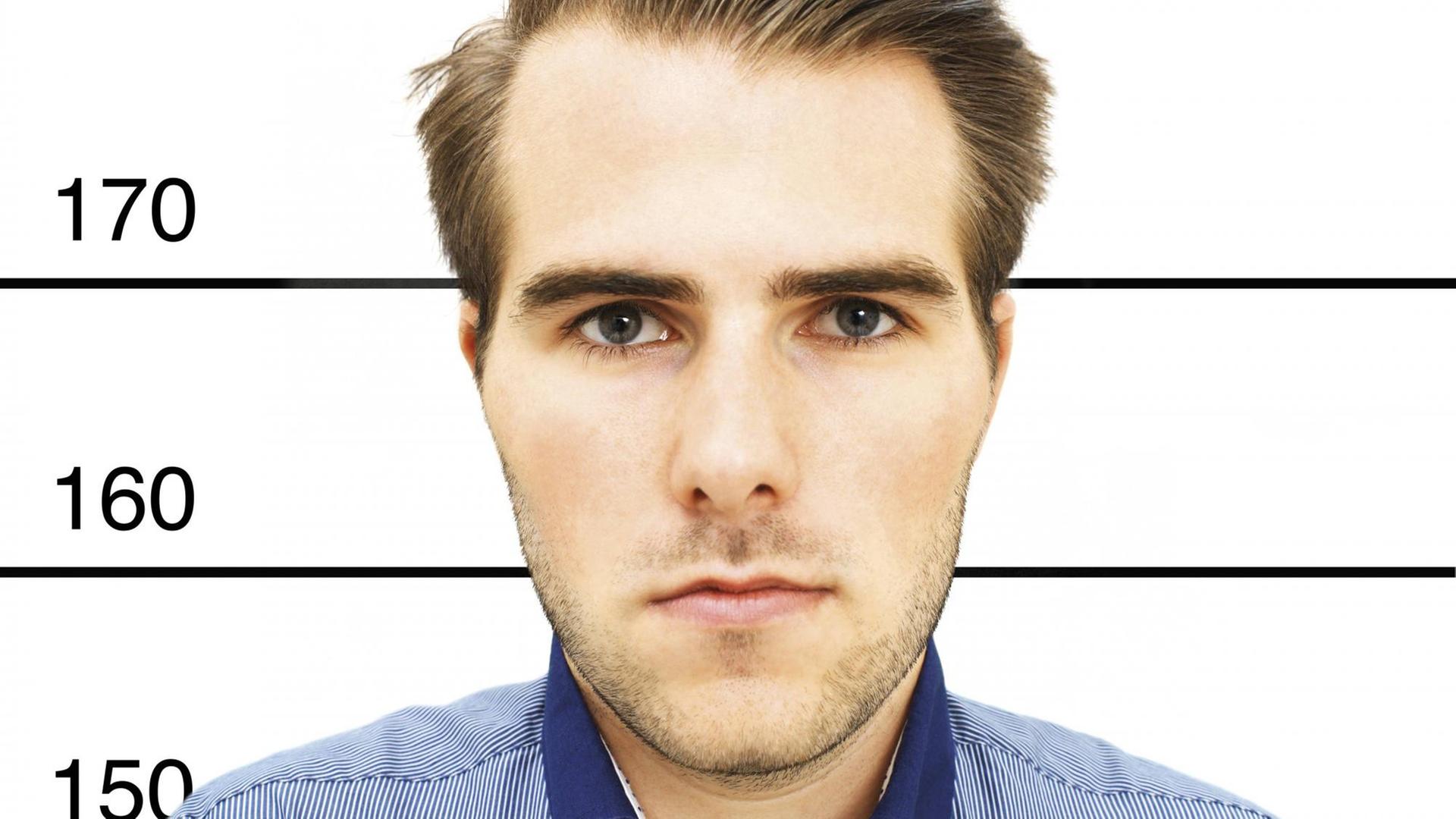

Künstliche Intelligenz ist in der Lage, allein anhand von Gesichtsfotos zu erkennen, ob jemand kriminell wird - mit einer Trefferquote von 80 Prozent. Das behaupteten US-Forscher kürzlich. Doch dagegen spricht viel.

Im Kern dieser Geschichte stecken zwei Missverständnisse. Der erste ist leicht zu erklären. Am 5. Mai hat die Harrisburg University eine Pressemitteilung herausgegeben. Drei ihrer Forscher hätten einem System zum maschinellen Lernen beigebracht, allein anhand von Gesichtsfotos zu erkennen, ob jemand kriminell wird. Trefferquote: 80 Prozent.

Die Arbeit solle in einer Buchserie beim Wissenschaftsverlag Springer erscheinen. In einem offenen Brief empörten sich Forscher darüber und forderten von Springer, die Veröffentlichung zu stoppen. Doch Springer teilte mit, man habe die Studie sowieso nicht veröffentlichen wollen. Das dürfte unter anderem daran liegen, dass diese Studie auf dem Schreibtisch von Hamid Arabina gelandet war.

"Ich bin froh, dass ich einbezogen wurde, denn die Studie hat eine entscheidende Schwäche", sagt Hamid Arabnia.

Der Informatiker von der University of Georgia ist auch Herausgeber der Springer-Buchserie. Die Studien dort müssen einen zweistufigen Prozess durchlaufen. Im ersten Schritt entscheiden Gutachter nur über den technischen Teil. Der sei in der Arbeit aus Harrisburg tadellos gewesen, sagt Arabnia.

System nutzt rein statistische Methode

Also wurden die Forscher gebeten, ihr System genauer zu beschreiben. Gut möglich – und das wäre das erste Missverständnis – dass sie deshalb gedacht haben, ihre Studie sei schon akzeptiert. So genau kann man das nicht beurteilen, denn auf Presseanfragen haben sie nicht reagiert.

Jedenfalls schickten sie ihre finale Arbeit ein, wieder bekamen Gutachter sie vorgelegt. Doch diesmal waren sie sich uneinig, Hamid Arabina musste entscheiden – und lehnte ab. "Die Anwendung der Technik war nicht gut. Das liegt daran, dass es um Daten von Polizeibehörden ging. Und diese Daten haben an sich schon eine Schieflage."

Dazu muss man kurz verstehen, wie maschinelles Lernen in diesem Zusammenhang funktioniert. Man gibt einem Computerprogramm Trainingsdaten. Das können zum Beispiel Fotos von Gesichtern sein. Diese Daten sind "gelabelt", also in Kategorien unterteilt. Zum Beispiel: Diese Person ist kriminell, diese ist es nicht.

Das System lernt dann alleine, Fotos in die passende Kategorie zu sortieren. Das ist eine rein statistische Methode. Das heißt: Das System erkennt irgendwelche Eigenschaften im Bild als Hinweis für Kriminalität an, weil einfach viele kriminelle Personen in den Trainingsdaten diese Eigenschaft hatten. Das hat das System der Forscher mit den vorhandenen Daten anscheinend gut hinbekommen. So viel zum technischen Teil.

Datengrundlage ist voreingenommen

Das Problem, das Arabina hier anspricht, ist aber: Die Daten zur Kriminalität können subjektiv sein. "Nur mal als Beispiel: Ich komme aus dem Mittleren Osten und sehe auch so aus. Darum werden mir am Flughafen öfter Fragen gestellt. Das hat etwas mit Terrorismus zu tun. Das macht mir nichts aus. Aber das ist eben Profiling. Und das passiert auf verschiedenen Ebenen bei der Strafverfolgung. Darum ist die Datengrundlage voreingenommen."

Denn es kann eben etwa in den USA sein, dass Menschen mit schwarzer Hautfarbe öfter kontrolliert werden und dadurch in Statistiken zur Kriminalität überrepräsentiert sind – und nicht etwa, weil sie von sich aus krimineller wären. Ein System, das mit Daten der Polizei gelernt hat, könnte dadurch Schwarze als krimineller einstufen als Weiße und somit in den verzerrten Datensätzen sogar gute Trefferquoten erzielen.

Das ist auch das Problem, das die Verfasser des Briefs hervorheben. Aber es gibt ein weiteres Problem, das nicht so einfach zu fassen ist: Es ist falsch, am Aussehen festzumachen, ob jemand kriminell ist. Doch mancher traut den Maschinen die hellseherische Fähigkeit zu, genau das zu tun.

Das ist das zweite Missverständnis in dieser Geschichte: Es scheint, als würden selbst Experten die Erfolge des maschinellen Lernens falsch verstehen und sich davon blenden lassen. Denn bei der Erkennung von Bildern oder von Sprache, sind die Systeme nahezu perfekt.

Aufgaben mit geringer Fehlerquote

"Aber das sollte uns nicht wundern, denn das sind Aufgaben, in denen man kleine Fehlerquoten erreichen kann", sagt David Watson. "Wir Menschen können auch mit geringen Fehlerquoten erkennen, ob auf einem Bild ein Haus oder eine Katze ist. Aber jetzt beginnen wir das maschinelle Lernen in Anwendungen zu drücken, in denen solche geringen Fehlerquoten eben nicht möglich sind."

Watson forscht am Oxford Internet Institute daran, welche Erkenntnisse man Computerprogrammen abgewinnen kann. Tatsächlich versucht man, Computer alles Mögliche in Bildern oder Videos erkennen zu lassen: Lügen, Autismus, Homosexualität – all diese Versuche gab es.

Dass das ethisch nicht vertretbar ist, liegt auf der Hand. Aber welche Aufgaben sollten wir Systemen zum maschinellen Lernen überlassen? Watson sagt, dass das nur Aufgaben sind, die eine geringe Fehlerquote erlauben.

Sie haben eines gemeinsam: "Die Information, die ich suche, steckt wirklich in den Daten drin. Wenn ich mir also Bilder anschaue, dann muss die Information in dem Bild stecken."

Darum funktioniert die automatische Hautkrebserkennung: Die Information über den Tumor steckt im Bild. Der Tumor hat die Haut verändert. Darum funktioniert Gesichtserkennung: Zwei Fotos einer Person sehen ähnlich aus, weil sie zu dieser Person gehören. Natürlich stimmt beides nur, wenn man gute Trainingsdaten hat.

Information muss im Bild stecken

Aber ein Mensch sieht eben nicht so aus wie er aussieht, weil er kriminell ist. Man kann keine Kriminalitätserkennung mit Gesichtsfotos hinbekommen – egal, was für Daten man hat. Die Information ist nicht im Bild.

Das mussten schon andere Forscher feststellen. 2016 erschien eine Studie, die ähnliches versprach wie die aus Harrisburg. Thilo Hagendorff, der an der Universität Tübingen am Exzellenzcluster Machine Learning und dem Forum Privatheit forscht, erinnert sich noch: Das System hatte damals mit Verbrecherfotos und zufälligen Bildern aus dem Internet gelernt.

Was aber der Machine Learning Algorithmus eigentlich gelernt hat ist, Menschen zu unterscheiden, die lächeln und die nicht lächeln. Oder Menschen, die einen Kragen haben und die keinen Kragen haben. Wie schaut man denn bei der Polizei? Man lächelt nicht, und man hat jetzt auch nicht seine beste Kleidung an.

Aber wie stellt man sich im Internet dar? Naja, von seiner guten Seite. Man lächelt, man hat vielleicht einen Anzug an. Und diese Dinge, die sind gelernt worden, nicht kriminell oder nicht kriminell.

Seine Antwort auf die Frage, welche Aufgaben für Systeme zum maschinellen Lernen geeignet sind, lautet: "Aufgaben, die Menschen typischerweise innerhalb von einer Sekunde auch tun könnten."

Und wenn die Maschine sich irrt?

Sie sind geeignet für Aufgaben, die klar definierte Inputs haben: Gegabelte Trainingsdaten und klar definierte Outputs. Sie sind geeignet für Fragen, wo man ein klares Ziel hat, also etwa die Frage: Wie bekomme ich die meisten Punkte in dem Videospiel?" Sobald es aber um komplexe Aufgaben geht, Strategien oder darum, den Kontext zu verstehen, sollte man derzeit die Finger von maschinellem Lernen lassen.

Für Hamid Arabina, der damals die Studie auf dem Tisch hatte, ist noch ein Faktor entscheidend: "Was passiert, wenn das System sich irrt? Wie beeinflusst das das Leben der Menschen? Wenn der Einfluss schwerwiegend ist, dann würde ich sagen, sollte man solche Systeme nicht veröffentlichen oder einsetzen."

Das System zur vermeintlichen Kriminalitätserkennung würde sich oft irren. Wie groß der Einfluss jedes einzelnen Irrtums auf das Leben des so bewerteten Menschen wäre, ist in unserer Zeit, in der viele den Maschinen hellseherische Fähigkeiten zusprechen, einfach zu vorherzusagen: Er wäre zerstörerisch.