Woran Journalismus-Roboter scheitern

06:02 Minuten

Es gibt zwar einige Projekte, die mit viel Aufwand automatische Sport-, Wetter- oder Börsenberichte erzeugen. Aber in der Breite sind Algorithmen im Journalismus noch nicht angekommen. Was steht dem im Weg?

Manchmal versagt einfach die Technik. Während Donald Trumps State of the Union Rede diese Woche sollte man eigentlich in der App FactStream sehen können, ob Trumps Behauptungen stimmen. Einen Live-Faktencheck wollte die App anbieten. Aber das Interesse daran war wohl zu groß - die App crashte.

Hinter der App steckt ein Team von der Duke University in North Carolina – und eine Gruppe von Faktencheckern. Mark Stencel, der das Projekt leitet, will aber in Zukunft auf menschliche Faktenchecker verzichten können.

"Unser Fernziel sind automatisierte Echtzeit-Faktenchecks, sodass, wenn der Präsident eine Fernsehansprache hält, wir auf eine Sammlung von bestehenden Faktenchecks zurückgreifen können und sofort sagen können, dieses Statement haben wir schon einmal überprüft und es ist wahr, falsch oder irgendwas dazwischen."

Hinter der App steckt ein Team von der Duke University in North Carolina – und eine Gruppe von Faktencheckern. Mark Stencel, der das Projekt leitet, will aber in Zukunft auf menschliche Faktenchecker verzichten können.

"Unser Fernziel sind automatisierte Echtzeit-Faktenchecks, sodass, wenn der Präsident eine Fernsehansprache hält, wir auf eine Sammlung von bestehenden Faktenchecks zurückgreifen können und sofort sagen können, dieses Statement haben wir schon einmal überprüft und es ist wahr, falsch oder irgendwas dazwischen."

Eine App zum Fakten-Check

Doch die nicht funktionierende App diese Woche war nicht der einzige Rückschlag für Stencel in letzter Zeit. Ende 2017 begann sein Team, E-Mail-Alerts an Faktenchecker zu schicken. Die E-Mails werden von einem Algorithmus generiert, der jeden Tag mehr als 1000 Tweets von Politikern und Parteien und das Fernsehprogramm von CNN auswertet. Daraus filtert er 25 Behauptungen, die er für faktencheck-würdig hält.

"Das kam hervorragend an. Es gab eine Menge Faktenchecks bei PolitiFact, Factcheck.org und bei der 'Washington Post', die auf eine Behauptung zurückgingen, die diese algorithmische Prozess identifiziert hatte."

Doch nach einigen Wochen ließ das Interesse nach. Die Faktenchecker sagen Mark Stencel, dass die E-Mails zu viele uninteressante Behauptungen enthalten. Der Algorithmus wirft viele Claims aus, die für Faktenchecker unbrauchbar sind, etwa, wenn gar nicht klar ist, wer etwas gesagt hat, weil das aus dem Transkript des CNN-Programms nicht hervorgeht.

"Das kam hervorragend an. Es gab eine Menge Faktenchecks bei PolitiFact, Factcheck.org und bei der 'Washington Post', die auf eine Behauptung zurückgingen, die diese algorithmische Prozess identifiziert hatte."

Doch nach einigen Wochen ließ das Interesse nach. Die Faktenchecker sagen Mark Stencel, dass die E-Mails zu viele uninteressante Behauptungen enthalten. Der Algorithmus wirft viele Claims aus, die für Faktenchecker unbrauchbar sind, etwa, wenn gar nicht klar ist, wer etwas gesagt hat, weil das aus dem Transkript des CNN-Programms nicht hervorgeht.

Automatische E-Mail werden eher nicht gelesen

In einem Folgeprojekt reduzierte Mark Stencels Team dieses Rauschen, indem es auf menschliche Expertise setze. Eine Redakteurin filterte die interessantesten Behauptungen heraus, schrieb noch einen freundlichen, kurzen, einführenden Satz, bevor die E-Mail an Faktenchecker rausging. Die Aufmerksamkeit der Faktenchecker für die E-Mail-Alerts stieg.

"Automatische E-Mails erscheinen den Lesern wohl zu robotisch. Wenn der Roboter als Absender zu sehr durchscheint, dann schweifen unsere Augen wohl eher über den Text hinweg."

Ähnliche Erfahrungen hat auch Laurence Dierickx gemacht. Sie hat für ihre Doktorarbeit untersucht, wie eine Zeitung in Brüssel Daten von Luftschadstoff-Messstationen auswertet. Laurence Dierickx ist Programmiererin und Journalistin und hat extra Tools für die Redaktion entwickelt, die die Daten einsammeln und auswerten, in Tweets, Grafiken und Karten.

"Automatische E-Mails erscheinen den Lesern wohl zu robotisch. Wenn der Roboter als Absender zu sehr durchscheint, dann schweifen unsere Augen wohl eher über den Text hinweg."

Ähnliche Erfahrungen hat auch Laurence Dierickx gemacht. Sie hat für ihre Doktorarbeit untersucht, wie eine Zeitung in Brüssel Daten von Luftschadstoff-Messstationen auswertet. Laurence Dierickx ist Programmiererin und Journalistin und hat extra Tools für die Redaktion entwickelt, die die Daten einsammeln und auswerten, in Tweets, Grafiken und Karten.

Angst vor Konkurrenz durch den Roboter

Nur zwei Journalisten nutzten die Daten. Vier andere, die ebenfalls Zugriff hatten, nicht. Als sie die Journalisten fragte, warum sie die Daten nicht nutzten, kam die Forscherin zu einem ähnlichen Ergebnis wie Mark Stencel:

"Das Bild des Journalisten-Roboters in ihrem Kopf erzeugte in ihnen das Gefühl einer Konkurrenzsituation. Der wird mich ersetzen, sagte einer der Journalisten. Die haben sich nicht wirklich wohl damit gefühlt."

Hinzu komme eine gewisse Technikfeindlichkeit vieler Journalisten. Erst als das Projekt nach einem Jahr zu Ende ging, hätten die Journalisten erkannt, dass das automatisierte System ihnen als Quelle dienen könnte, sie unterstützen könnte, anstatt sie zu ersetzen. Das ist jedenfalls der Ansatz, den Laurence Dierickx für zukunftsfähiger hält.

"Das Bild des Journalisten-Roboters in ihrem Kopf erzeugte in ihnen das Gefühl einer Konkurrenzsituation. Der wird mich ersetzen, sagte einer der Journalisten. Die haben sich nicht wirklich wohl damit gefühlt."

Hinzu komme eine gewisse Technikfeindlichkeit vieler Journalisten. Erst als das Projekt nach einem Jahr zu Ende ging, hätten die Journalisten erkannt, dass das automatisierte System ihnen als Quelle dienen könnte, sie unterstützen könnte, anstatt sie zu ersetzen. Das ist jedenfalls der Ansatz, den Laurence Dierickx für zukunftsfähiger hält.

Algorithmen als Hilfe bei der Recherche

Insbesondere außerhalb von großen Nachrichtenagenturen, also in kleineren Newsrooms, die weder das Geld hätten, um Künstliche-Journalismus-Intelligenzen programmieren zu lassen, noch die dafür notwendigen riesigen Datenmengen. Mark Stencel will hingegen weiter an vollautomatisierten Live-Faktenchecks arbeiten.

"Wir wollen etwas bauen, das im Fernsehen oder in Streams eingeblendet wird. Wir denken viel darüber nach, wie wir es hinbekommen, dass das nicht einer der durchscrollenden Ticker am Bildschirmrand wird, den man nicht liest, weil das ja nur robotisch ist und nicht von Menschen geschrieben."

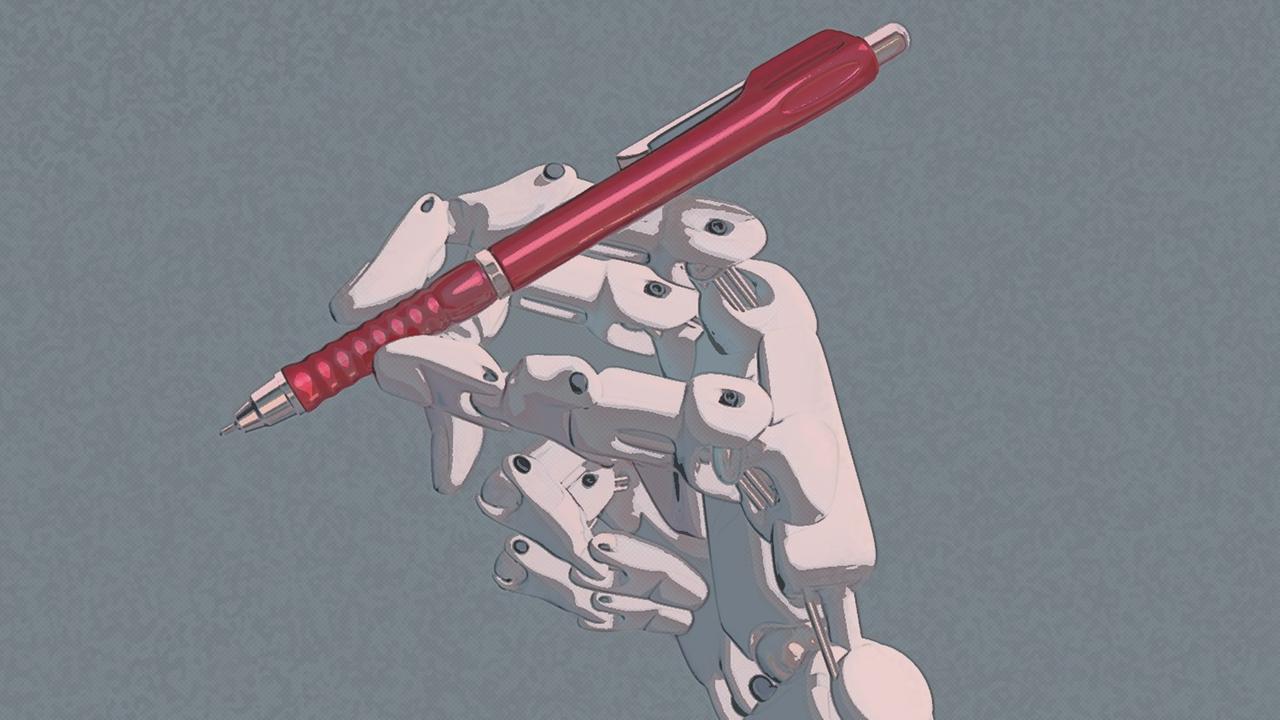

Die Projekte zeigen, dass Algorithmen Journalisten unterstützen können. Die Journalisten werden aber noch gebraucht, zumindest so lange, wie die Handschrift der Roboter in Texten noch erkennbar ist.

"Wir wollen etwas bauen, das im Fernsehen oder in Streams eingeblendet wird. Wir denken viel darüber nach, wie wir es hinbekommen, dass das nicht einer der durchscrollenden Ticker am Bildschirmrand wird, den man nicht liest, weil das ja nur robotisch ist und nicht von Menschen geschrieben."

Die Projekte zeigen, dass Algorithmen Journalisten unterstützen können. Die Journalisten werden aber noch gebraucht, zumindest so lange, wie die Handschrift der Roboter in Texten noch erkennbar ist.