Automaten des Todes?

Unkontrollierbare Maschinen oder Roboter, die plötzlich auf Menschen losgehen sind beliebte Elemente in Science-Fiction-Filmen. Es gibt sie zwar noch nicht wirklich, aber technisch möglich sind solche "automatisierten tödlichen Waffensysteme". Menschenrechtsorganisationen fordern ein generelles Verbot dieser Waffenkategorie.

"RX2714 Stopp! ---- RX2714 Stopp!! ---- (Rumpeln, Schreie) ---- Er: Jetzt zeigen Sie mal, was Sie können. ---- Sie: Haben Sie Angst vor einem Roboter? ---- (Roboter stoppt) ---- Die eingebaute Kontrolle ermöglicht uns, die elektronisch gesteuerten Grundreflexe zu korrigieren."

Roboter, die durchdrehen - ein beliebtes Motiv für Science-Fiction, etwa die deutsche Serie Raumpatrouille Orion von 1966. Inzwischen scheinen wir der Fiktion ein gutes Stück näher gekommen zu sein. Bedrohliche Roboter werden Realität - und mit ihnen die Angst, dass die Maschinen immensen Schaden anrichten könnten. Fast 50 Jahre nach Rolf Honolds Idee zu Raumpatrouille Orion erzählt der Autor Daniel Suarez in seinen Büchern von Tod bringenden Maschinen - weit in die Zukunft muss Suarez sich und seine Leser dafür nicht versetzen.

"Technisch sind sie absolut machbar. Autonome, tödliche Roboter können schnell zusammengebaut werden. Es gibt sogar schon zwei, von denen ich weiß. Die wurden ausgerechnet von Samsung hergestellt und an der entmilitarisierten Zone zwischen Nord- und Südkorea eingesetzt. Die können ein menschliches Ziel erkennen und darauf feuern und sie töten. Aber im Moment sind sie nicht so eingestellt, sondern ein Mensch muss die Entscheidung bestätigen. Aber das ist nicht durch die Technik vorgegeben."

Technik soll Waffen blockieren - noch

Kill Decision, Tötungsentscheidung, heißt einer von Suarez' Bestsellern. Noch aber entscheiden Menschen, andere Menschen zu töten, ob sie nun selbst zur Waffe greifen oder nur ein kleiner, aber im wahrsten Wortsinn entscheidender Teil einer Tötungsmaschinerie sind. Noch hat kein Algorithmus unabhängig bestimmt, dass eine Waffe ausgelöst oder eine Bombe abgeworfen wird. Das Gegenteil ist der Fall. Digitaltechnik wird in Waffen integriert, um sie zu blockieren. Nur autorisierte Nutzer sollen so genannte Smart Guns auslösen können. Je nach Produkt soll ein Fingerabdrucksensor, ein Handflächenscanner oder ein elektronischer Fingerring dafür sorgen, dass nur der Besitzer einer Waffe sie benutzen kann. Die deutsche Firma Armatix koppelt ihre Digitalpistole mit einem Funkarmband. Die Funktionsweise zeigt ein Video im Internet:

"Das IP1 System Personalized basiert auf einer elektronischen Steuerung, die den Zugriff und die Nutzung der Waffe mithilfe einer Funkarmbanduhr kontrolliert. Die IP1 Personalized Waffe ist nur dann schussfähig, wenn sie sich im Funkbereich dieser Uhr befindet. Sobald die Waffe den Funkkontakt zur Uhr verliert, zum Beispiel, wenn sie dem Schützen aus der Hand geschlagen wird oder bei Verlust, Diebstahl et cetera, deaktiviert sie sich automatisch."

Solche Technik soll dazu führen, dass Unfälle oder Amokläufe verhindert werden. Auf kriegerische Auseinandersetzungen wird sie wohl weniger Auswirkungen haben. Doch auch im Krieg führt Technik dazu, dass Tötungsentscheidungen von Menschen besser abgewogen werden, sagt die ehemalige US-Kampfjetpilotin Missy Cummings:

"Wohl einer der größten Sprünge nach vorn der vergangenen 20 Jahre ist, dass im Drohnenkrieg jetzt Juristen an der Tötungsentscheidung beteiligt sind. Als ich Pilotin war, war es allein meine Entscheidung eine Bombe abzuwerfen oder nicht, auf Grundlage der Regeln, die mir vor dem Flug genannt wurden. Heute schaut ein Drohnenpilot auf einen Bildschirm und spricht mit wohl fünf bis zehn anderen Leuten, die auf den gleichen Bildschirm gucken, von denen einer ein Jurist ist. Es ist eine Entscheidung eines Komitees, eine Waffe auszulösen. Das ist meiner Meinung nach eine viel bessere Form der Kriegsführung, weil da jemand beteiligt ist, der das Kriegsvölkerrecht viel besser kennt als ich. Und weil der Pilot sich nicht in Gefahr begibt, empfindet er auch deutlich weniger körperlichen Stress."

Kriegsführung wird stärker von Technik bestimmt

Dennoch ist der Drohnenkrieg umstritten, auch weil die Piloten so weit vom Geschehen entfernt sind. Vielleicht passen die Regeln, auf deren Grundlage die Juristen über Bombenabwürfe entscheiden gar nicht mehr zur heutigen Kriegsführung. Die wird immer stärker von Technik bestimmt. Waffensysteme werden immer präziser wird und können schon heute viele Dinge besser als der Mensch.

"Vor 20 Jahren gehörte ich zu den ersten weiblichen Piloten von Kampfjets. Als ich in einer F18 Hornet saß, wurde mir klar, wie viel Automation zu diesem Zeitpunkt schon in den Systemen steckte. Als ich zum Beispiel sah, wie gut Flugzeuge auf Flugzeugträgern landeten und wie sich Raketen zu der Zeit entwickelten, war mir klar, dass innerhalb von 20 Jahren die Kriegstechnik die menschlichen Fähigkeiten in den Schatten stellen würde. Und dann tauchten die Drohnen auf."

Missy Cummings merkte, dass sie als Pilotin bald nicht mehr gebraucht werden würde. Automatische Systeme würden ihren Job übernehmen und besser ausführen als sie es jemals könnte. Sie wechselte in die Wissenschaft und erforscht inzwischen an der Duke Universität in North Carolina, wie Mensch und Maschine am besten zusammen arbeiten können.

"In meiner Forschungsgruppe glauben wir an eine stärkere Zusammenarbeit zwischen automatisierten Systemen und Menschen als Kontrolleure oder ja: Trainer der Systeme. Aber selbst dann sind Menschen schnell gelangweilt, wenn nichts passiert. Die automatischen Systeme müssen also berücksichtigen, was der Mensch macht, sodass sie ihn nicht bitten einzugreifen, wenn er das gar nicht innerhalb der erforderlichen Zeit machen kann."

Ein schwieriges Problem, denn Technik wird immer selbstständiger, der Mensch immer überflüssiger. Die US-Firma Tracking Point beispielsweise wirbt damit, Technik aus Kampfjets in Gewehre einzubauen. Sie berücksichtigen Werte wie Windgeschwindigkeit, Temperatur, Luftfeuchtigkeit und Erdrotation um einen Schuss perfekt zu setzten. In Videos zeigt das Unternehmen, wie damit Tiere aus mehr als einem Kilometer Entfernung erlegt werden können. Der Schütze, so scheint es, wird nur noch gebraucht, um das Ziel auszuwählen und den Abzug zu ziehen. (Atmo Ende) Das müssten die Algorithmen doch auch noch hinbekommen. Können sie auch, sagt Wolfgang Richter, Oberst a.D.

Autonome Roboter scheinen nur noch einen Schritt entfernt

"Es gibt natürlich automatisierte Waffen schon heute. Wenn Sie an die Abwehr von Raketenangriffen auf Schiffe denken, dann ist die Abwehr dieser Raketen weitgehend automatisiert. Obwohl natürlich der Mensch immer noch einen Zugriff hat. Er überwacht das Ganze und kann eingreifen. Aber die Zeit, die verfügbar ist, ist so knapp, dass es hier sicherlich sinnvoll ist, automatisierte Prozesse in Gang zu setzen. Wie man ja überhaupt sagen kann, dass der große Vorteil von Automatisierung darin liegt, dass die Überlebensfähigkeit verbessert wird. Dass der Mensch aber auch in der Lage ist, komplexe Aufgaben in kurzer Zeit unter Bedrohung, unter Feuer und in einem Massenanfall von Informationen und Zielen erledigen zu lassen durch automatisierte Systeme. Bei denen er allerdings operativ die Kontrolle behält."

Autonome Waffen, bewaffnete Roboter, die sich gegen Menschen richten, scheinen nur noch einen winzigen Schritt entfernt zu sein. Daniel Suarez:

"Ich glaube, die gibt es längst. Ich glaube absolut, dass es die längst gibt. Sind wir uns dessen bewusst? Nein. Aber wenn es sie noch nicht gibt, wäre es auf jeden Fall möglich. Deshalb sage ich: es gibt sie schon. Es ist einfach sehr wahrscheinlich. Ferngesteuerte Schussanlagen gibt es ja schon eine ganze Weile. Technisch gibt es kein Hindernis, dass sie automatisiert werden. Das wird passieren. Es geht darum, wie wir darauf reagieren."

Kinoversion der nostalgischen Science-Fiction-Serie "Raumpatrouille Orion - Rücksturz ins Kino"© picture alliance / dpa

"Was heute noch wie ein Märchen klingt, kann morgen Wirklichkeit sein. Hier ist ein Märchen von übermorgen."

Der Vorspann von Raumpatrouille Orion klingt verheißungsvoll. Doch in der Zukunft, die die TV-Serie aus den Sechzigern zeichnet, scheinen Roboter manchen ein wenig zu viel Macht zu haben. Was heute diskutiert wird, wurde dort auch schon besprochen.

"Ein Mensch kann versagen, ein Roboter niemals. ---- Ach, Sie sagen das so als sei das bei einem Roboter Charaktersache. ---- Nein, im Gegenteil: beim Menschen. Die Handlungen eines Menschen hängen von seinem Charakter ab. Die Handlungen eines Roboters nur von seinem Gehirn. Und das haben wir ja Gott sei Dank unter Kontrolle. ---- Jetzt tun sie nur nicht so, als ob ein Elektronengehirn nicht auch gelegentlich versagen könnte. ---- Ja, natürlich ist das möglich, aber: Wenn ich zwischen zwei Möglichkeiten die Wahl habe - dem Versagen eines Elektronengehirns oder dem Versagen eines menschlichen Charakters, dann möchte ich doch der zweiten Möglichkeit den Vorzug geben. ---- Ich wünsche von Herzen, dass Ihr Glaube an die Unfehlbarkeit der Maschinen einmal gründlich enttäuscht wird. ---- Wünschen Sie sich das lieber nicht, General. Unsere Weltraumherrschaft, unsere ganze Sicherheit überhaupt hängt ja größtenteils von Robotern ab. ---- Das weiß ich, ich bin schließlich auch nicht von gestern. Nur möchte ich nicht behaupten, dass ich mich sonderlich wohl dabei fühle."

"Ich will überhaupt nicht infrage stellen - das ist ein wichtiges Argument, dass ein Soldat im Kampfstress unter Lebensgefahr selbstverständlich Fehler macht. Das gab es zu allen Zeiten. Das ist der Psychologie des Menschen geschuldet."

Wolfgang Richter, forscht nach einer Karriere bei der Bundeswehr jetzt bei der Stiftung Wissenschaft und Politik zu Fragen der Sicherheitspolitik.

"Eine Maschine kennt natürlich weder Angst noch Hass noch Verzweiflung. Aber eine Maschine kennt natürlich auch nicht das, was wir als Empathie bezeichnen oder die richtige Erkenntnis zu welchem Zeitpunkt es sich nicht mehr um einen Kämpfer, sondern um ein Kind handelt, das möglicherweise einen Knüppel in der Hand hält, was ein Sensor als Waffe auffasst. Ich übertreibe vielleicht ein bisschen, aber ich will damit nur sagen, das menschliche Einfühlungsvermögen ist gelegentlich dem humanitären Völkerrecht mehr entsprechend als die Maschine."

Rechtliche Voraussetzungen müssen beachtet werden

Ein Kriegsgebiet ist kein rechtsfreier Raum. Es gilt das Völkerrecht und eine ganze Reihe von Regeln, die beschreiben, was legal ist und was nicht. Was ein legitimes Ziel ist und was nicht.

"Die wesentlichen Grundsätze sind eben die Unterscheidung zwischen Kombattanten, die auch rechtmäßige Ziele im Krieg sind, und zwischen Zivilisten, die es eben nicht sind. Ganz egal, wie sie in ihrer Konfiguration aussehen mögen aus der Sicht eines Sensors. Und dass man die Verhältnismäßigkeit des Waffeneinsatzes gewährleistet. Diese Dinge bedürfen immer einer menschlichen Bewertung."

sagt Wolfgang Richter. Es gibt jedoch auch Ingenieure die glauben, dass Algorithmen diese Bewertung vornehmen könnten. Dass die Regeln des Humanitären Völkerrechts in Programmcode übersetzt werden könnten und dass Roboter so der menschlichen Ethik folgen, aber ohne durch menschliche Schwächen wie Angst und Hass in ihrem Handeln beeinflusst zu sein. Heute ist das nicht möglich, aber vielleicht in Zukunft? Der Philosophie-Professor John Kaag:

"Das Völkerrecht basiert größtenteils auf der Lehre vom Gerechten Krieg. Und die war nie als Entscheidungsverfahren gedacht. Es handelt sich vielmehr um Richtlinien, die wir für jeden Einzelfall durchdenken müssen. Allgemeine Richtlinien sind schwierig mit einer diskreten, speziellen Situation überein zu bringen. Und das passiert eben durch menschliches Urteilsvermögen. Das werden Roboter in der nahen Zukunft nicht können."

Selbst in der Serie Raumpatrouille Orion können Roboter keine komplexen Regeln befolgen. Sie folgen sehr einfachen Gesetzen. Den vom Autor Isaac Asimov schon in den 1940er Jahren postulierten Robotergesetzen.

"Die Roboter der Alpha-CO-Serie sind Arbeits- und Kampfmaschinen, in deren Gehirnen Anweisungen programmiert und die drei Robotergesetze verankert sind. Es ist für uns alle von größter Wichtigkeit, diese Gesetze zu kennen. Wie Sie wissen lautet das erste: Ein Roboter darf nie ein menschliches Leben vernichten. ---- Wie mich das freut (lacht)."

Werden Asimovs Gesetze Realität?

Das zweite und dritte Gesetz sind diesem Grundsatz untergeordnet.

"Zweitens: Ein Roboter muss den ihm von einem Menschen gegebenen Befehlen gehorchen – es sei denn, ein solcher Befehl würde mit Regel eins kollidieren. Drittens: Ein Roboter muss seine Existenz beschützen, solange dieser Schutz nicht mit Regel eins oder zwei kollidiert."

Asimovs Robotergesetze bilden nicht nur die Grundlage für zahlreiche seiner eigenen Science-Fiction-Geschichten, sondern wurden und werden immer wieder thematisiert. Zu den ältesten Hollywoodfilmen, in denen sie eine Rolle spielen, gehört "Alarm im Weltall" von Regisseur Fred Wilcox aus dem Jahr 1956.

"Kapitän, darf ich Sie bitten, mir mal Ihre schreckerregende Atomwaffe zu borgen? Danke sehr. Robbie, bitte richte dieses Ding auf die Altea futex draußen auf der Terrasse. Feuer! (Schuss) Verstehst du, wie die Waffe funktioniert? ---- Ja, Morbius. Eine einfache Strahlenwaffe. ---- Jetzt dreh dich mal hier herum und richte die Waffe auf den Kommandanten. Genau zwischen die Augen zielen. Feuer! (Zischen und Rattern) Sie sehen, er ist hilflos. Er ist festgefahren in einem tief eingewurzelten Dilemma zwischen meinem direkten Befehl und seiner eingebauten Hemmung gegen die Verletzung von Lebewesen. Befehl zurück! Wenn ich dieses Spiel noch länger mit ihm treiben würde, würden sämtliche Stromkreise in ihm durchschmoren."

Von Science-Fiction-Filmen hält Sicherheitsforscher Wolfgang Richter nicht viel. Zumindest von Filmen, in denen Robotersoldaten Feinde töten und Städte erobern. Er kann sich aber durchaus Fälle vorstellen, in denen Algorithmen bei Angriffen auf zivile Ziele sinnvoll sein können. Nämlich, weil sie die Zeitspanne zwischen der Aufklärung, also dem Ausmachen eines Ziels und dem Angriff verkürzen können.

"Wenn beispielsweise eine Brücke angegriffen wird und die Zeit bis zur Waffenwirkung wird zu lang, dann kann sich in dieser Zeit zum Beispiel ein Auto oder ein Zug über die Brücke bewegen und dann wird etwas passieren, was nicht intendiert ist. Also hat die sogenannte Verkürzung des Aufklärungs-Wirkungs-Verbunds auch einen Vorteil in jeder Hinsicht. Die ganze Operation bleibt eben unter scharfer Kontrolle und man kann den Kriterien der Unterscheidung und der Verhältnismäßigkeit besser Genüge leisten."

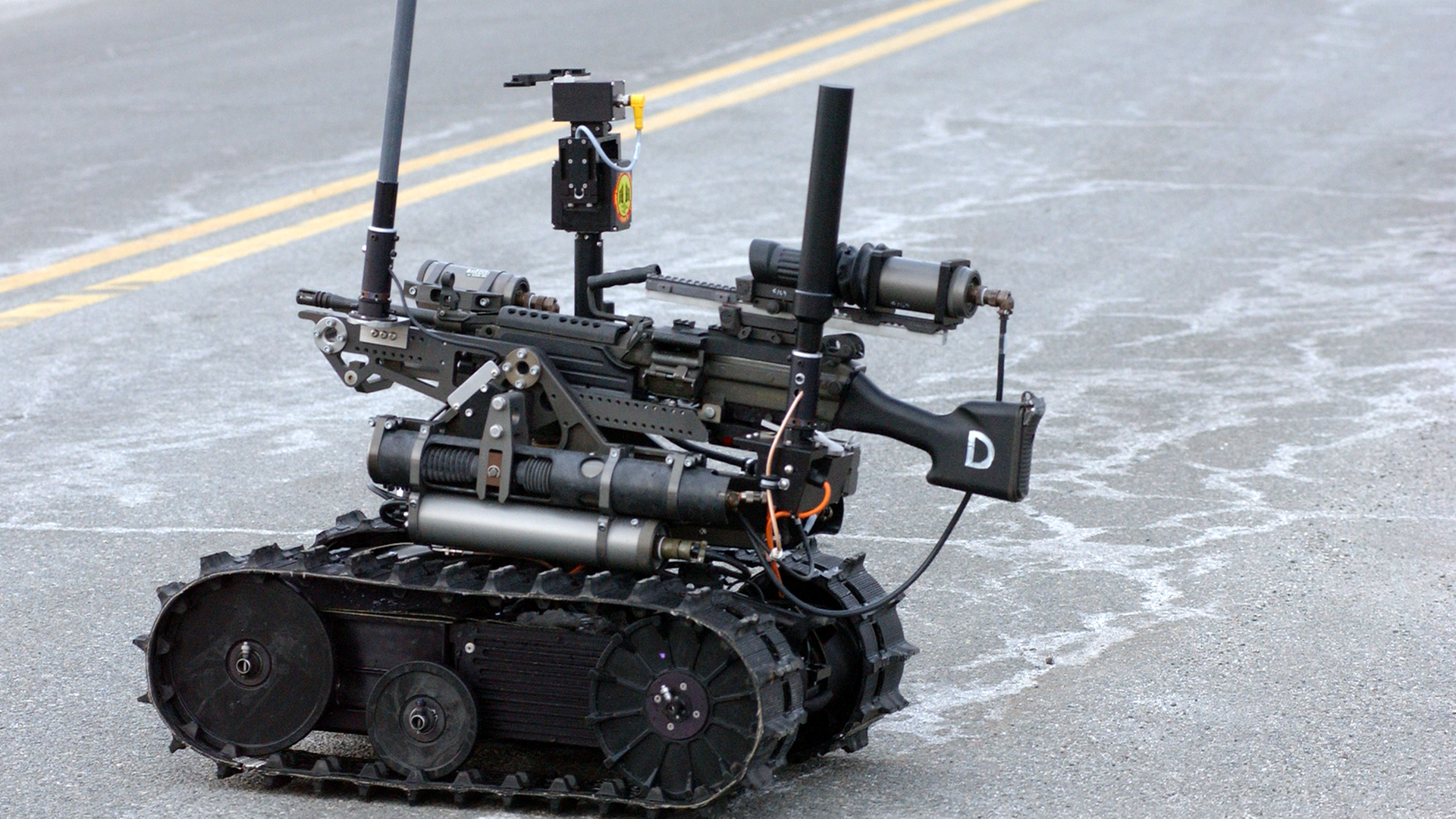

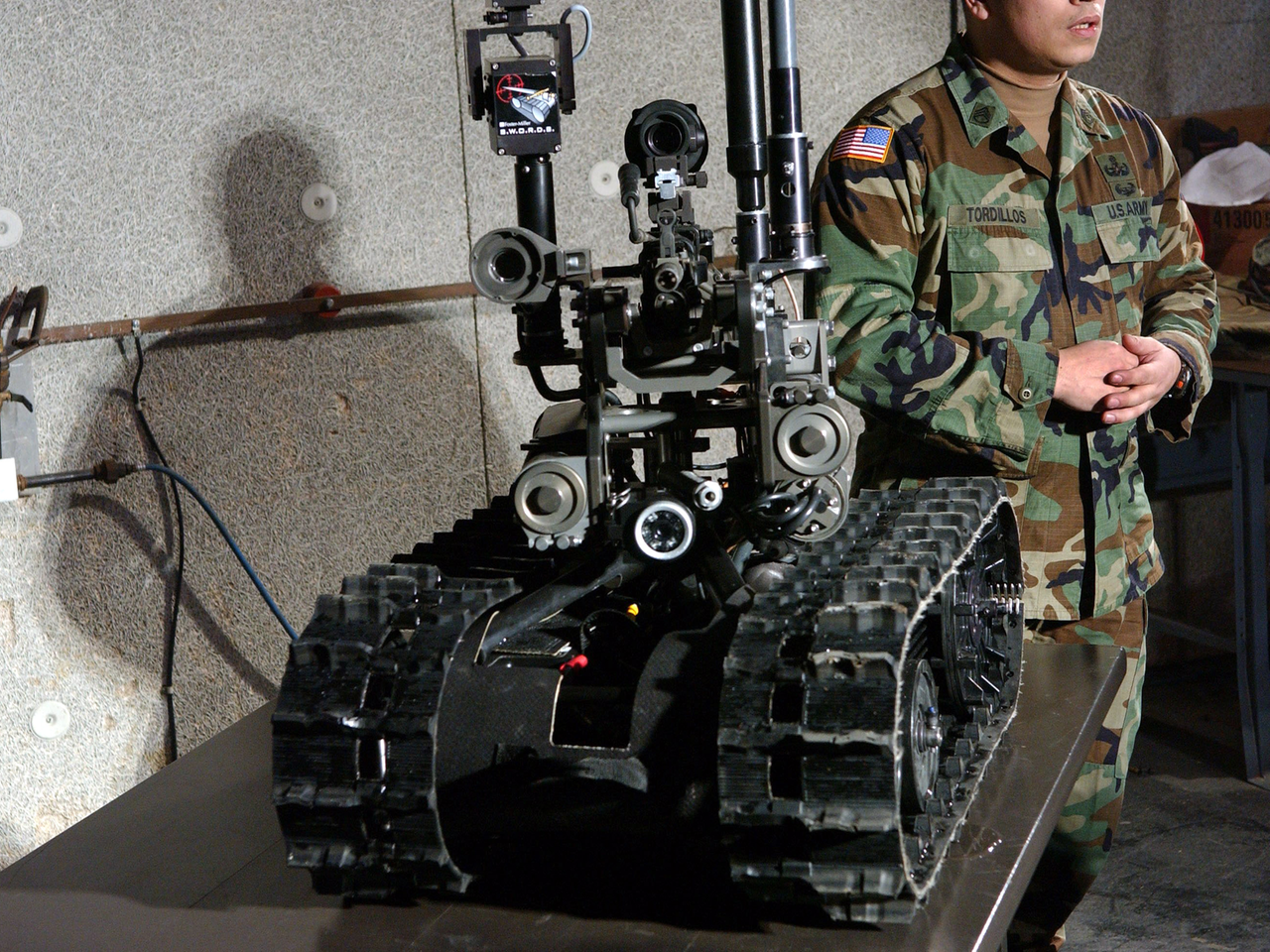

Kampfroboter der US-Armee: Der Talon Sword© picture alliance / dpa

Wenn Maschinen jedoch Menschen angreifen, wenn Algorithmen über Leben und Tod entscheiden, dann ist für viele, auch für Wolfgang Richter, eine rote Linie überschritten. Ethisch, aber auch technisch hält er es für nicht machbar, dass Maschinen in besiedeltem Gebiet auf Menschen schießen.

"Es ist wohl unbestritten, auch unter Experten, dass Rechnerkapazitäten nie die Kapazität des menschlichen Gehirns erreichen werden. Jedenfalls nicht in der für uns überschaubaren Zeit. Das bedeutet auch, dass sie immer mit Einschränkungen versehen ist und das beutetet auch, dass man solche Systeme zwar als Gehilfen des Menschen, als Gehilfen des Kampfteams einsetzen kann, für ganz bestimmte und begrenzte Rollen, aber letztlich nie selbstständig kämpfen lassen kann."

"Siehst du eine Chance, Cliff? ---- Ich bin kein Hellseher, Marius, kommt drauf an, wie viel Zeit wir haben. ---- Wozu denn Zeit? ---- Zum Nachdenken. ---- Glaubst du denn vielleicht, wir werden mit den wild gewordenen Maschinen durch Nachdenken fertig? ---- Ja, wenn überhaupt, dann nur durch Nachdenken."

In der Science Fiction sind Roboter verhältnismäßig dumm

Auch in der Science Fiction sind die Roboter verhältnismäßig dumm. Sie folgen Befehlen. Wenn Sie sich verhalten, als seien Sie Amok gelaufen, dann ist das auf ihre Beschränktheit zurückzuführen. Oder darauf, dass die drei simplen Regeln, mit denen sie ausgestattet sind, der Komplexität der Realität nicht gerecht werden. Mit unvorhersehbaren oder widersprüchlichen Situationen können sie nicht umgehen.

"Eigentlich sollten wir befehlen und die Roboter gehorchen, aber es ist genau umgekehrt. ---- In ihrem Speicher muss sich alles umgedreht haben. ---- Wie kann das passiert sein? ---- Dafür gibt's nur eine Erklärung: Die Roboter mussten zwei sich widersprechende Befehle befolgen. ---- Das muss während der Schießerei passiert sein. Sie mussten das erste und zweite Robotergesetz gleichzeitig durchführen. ---- Ja. Nach dem ersten Gesetz sollen sie menschliches Leben schützen. Das hätten sie aber nur tun können, indem sie anderes menschliches Leben verletzen, was ihnen nach dem zweiten Gesetz verboten ist. ---- Da können wir nur eines tun, wir müssen sie umprogrammieren. Können Sie das, Tamara? ---- Habt ihr denn keinen Spezialisten hier?"

"Viel hängt davon ab, wer die Kampfroboter programmiert. Und wer die Programmierung laufend überprüft, um sicher zu gehen, dass sie nicht geändert wurde. Das ist ein Schwachpunkt. Es ist so viel Macht an dem Punkt konzentriert, wo jemand Programmcode auf diese Dinger lädt. Wie viele Leute würden das sein? Diese Leute würden übermäßige Macht über die Richtung haben, die eine Gesellschaft nimmt. Das ist ein Problem."

Daniel Suarez. Er hält autonome Waffen, die sich gegen Menschen richten, nicht nur aus ethischen und technischen Gründen für bedenklich. Er glaubt, dass sie unsere Gesellschaft zurück ins Mittelalter versetzen könnten.

"Sie würden wieder zu einer Machtkonzentration führen. Wenn wir in der Geschichte zurückgehen: Im Mittelalter war Macht zentralisiert, weil es ein Gewaltmonopol gab. Wer berittene Krieger und eine Burg hatte, konnte ein Volk überwältigen. Als das Schießpulver entwickelt wurde und Armeen größer wurden, änderten sich die Dinge. Die Menschen mussten kooperieren um sich zu verteidigen. Meine Befürchtung ist, dass autonome Kampfroboter wieder Einzelpersonen ermöglichen werden, ganze Kriege zu führen und anderen Menschen ihren Willen aufzuzwingen."

Nicht mehr ein Volk würde Krieg führen, sondern nur noch Herrscher mit ihren Robotern. Die sollen laut den Entwicklern Leid verringern, Soldatenleben schützen und nur töten, wenn es notwendig erscheint. Doch Daniel Suarez führt ausgerechnet die verlustreichen Weltkriege als Argument gegen Kampfroboter an. Er nennt die mehr als viermonatige Schlacht an der Somme im ersten Weltkrieg.

"An der Somme haben Millionen von Menschen gekämpft. Millionen Menschen ziehen nicht einfach so in den Krieg. Sie mussten zustimmen, dass sie diesen Weltkrieg wollen. Das war eine furchtbare Idee - und deshalb war das vorher auch noch nie vorgekommen. Aber der Punkt ist: Alle diese Menschen wollten diesen Krieg. Wie könnte so etwas mit robotischen Waffen aussehen?"

Roboterarmee ist noch Zukunftsmusik

Zwar ändern sich die gesellschaftlichen und demokratischen Strukturen nicht unmittelbar durch die Entwicklung von Kampfrobotern, aber eine dumme Roboterarmee, so Suarez' Befürchtung, könnte eben auch Diktatoren oder Terroristen blind gehorchen. Eine Programmroutine zur Befehlsverweigerung oder zum Desertieren werden sie nicht enthalten. Aus heutiger Sicht, gehören Vorstellungen von ganzen Roboterarmeen allerdings noch ins Reich der Science Fiction. Die Kampfroboter, über die Militärs und Ingenieure heute nachdenken, werden noch lange nicht ohne Soldaten aus Fleisch und Blut unterwegs sein. Sie werden als Teil von Streitkräften betrachtet, die immer noch zum größten Teil aus Menschen bestehen werden. Diese sollen sie unterstützen. Und nicht eigenmächtig oder einer entfernten Macht hörig in die Schlacht ziehen. Und doch: Das Gedankenexperiment ist interessant.

"In Amerika ist das Ideal der Bürgersoldat. Der Mensch, der Teil der Gesellschaft ist, der in den Krieg geht, weil es eine Notwendigkeit ist, eine schreckliche Bürde. Er verteidigt die Gesellschaft und kehrt dann in die Gesellschaft zurück. Roboter kehren nicht in die Gesellschaft zurück, sie waren nie Teil der Gesellschaft."

Die Gesellschaft entfremdet sich von dem Krieg, den sie führt. Und dadurch könnten autonome Kampfsysteme es nicht nur Despoten, sondern auch Demokratien einfacher machen, sich an Kriegen zu beteiligen. Wenn weniger eigene Menschenleben auf dem Spiel stehen, dann ist mit geringerem innenpolitischen Widerstand gegen militärische Gewalt zu rechnen. Eine Entfremdung zwischen den Kriegen, die eine Machtelite führt, und dem Volk, das vermeintlich verteidigt wird, ist schon heute zu beobachten: Wo die großen Schlachten des zweiten Weltkrieges geschlagen wurden, wussten wir noch. Wo sich heutige Schlachtfelder befinden, können wir nur raten. Der amerikanische Philosoph John Kaag:

"Wenn man die US-Bürger fragt, wo die meisten Drohneneinsätze ausgeführt wurden, würde die große Mehrheit falsch antworten. Weil sie von dieser Technik entfremdet sind. Und ihnen gefällt das, weil es ihre Truppen schont."

Das ist der Nachteil daran, dass Soldaten aus der Gesellschaft kommen: Die Gesellschaft muss die Verluste verkraften. Nicht alle kommen lebendig und unversehrt zurück. Und nicht alle sind länger bereit, das zu akzeptieren als Preis für die Verteidigung der Gesellschaft und ihrer Werte.

"Es gibt eine große, große Mehrheit von Leuten in den USA, die nie wieder sehen wollen, wie Leichensäcke nach Hause gebracht werden. Das ist ein Antrieb für die Drohnentechnik, mit dem sich noch nicht richtig auseinandergesetzt wurde. Es gibt einen Drang, auf autonome Waffen zu setzen, weil sie unsere Soldaten schützen. Das ist unzweifelhaft eine gute Sache. Nur, dass wir dann bestimmten Prinzipien des Gerechten Krieges oder dem Kriegsvölkerrecht nicht entsprechen."

Politiker müssen abwägen

Politiker in den USA, sagt Kaag, müssen deshalb abwägen - zwischen dem Wunsch der Gesellschaft, Soldatenleben zu schützen und den Erfordernissen des Völkerrechts. Auch mit Technik wird nicht beides gleichzeitig möglich sein.

"Cliff, wenn ihr den Umbau der Gehirne wirklich schafft, was gebt ihr ihnen dann für Befehle? ---- Dass sie dich zeitlebens daran hindern, so dumme Fragen zu stellen! ---- Fertig? ---- Fertig! ---- Sie kommen!"

Was Roboter für Befehle bekommen sollen, darüber wird kontrovers diskutiert. Menschenrechtsgruppen haben sich zur Kampagne zum Stopp von Killerrobotern zusammengeschlossen. Zahlreiche Wissenschaftler engagieren sich im weniger reißerisch betitelten Internationalen Komitee zur Kontrolle von Roboter-Waffen. Die Diskussion hat inzwischen höchste diplomatische Kreise erreicht. Auf Ebene der Vereinten Nationen gibt es mehrere Initiativen, die auf eine Ächtung oder ein Verbot von Waffen hinauslaufen könnten, die ohne einen Menschen zu konsultieren Tötungsentscheidungen fällen.

"Es gibt im Humanitären Völkerrecht keine Regel, die eindeutig sagt, dass Roboter eine solche Entscheidung nicht fällen dürfen. Es würde also den Einsatz solcher Roboter nicht verbieten. Viele Menschen sagen, dass es ungesetzlich sein sollte, einfach weil Roboter eine solche Entscheidung nicht fällen sollten."

Christof Heyns, UN-Sonderberichterstatter für außergerichtliche und willkürliche Tötungen. Er vermisst offenbar so etwas wie Asimovs Robotergesetze.

"Erstens: Ein Roboter darf kein menschliches Wesen verletzen oder durch Untätigkeit gestatten, dass einem menschlichen Wesen Schaden zugefügt wird."

Die Grundlagen des Völkerrechts sind - je nach Blickwinkel - Jahrzehnte oder Jahrhunderte älter als die drei Robotergesetze.

"Man hört es schon im Namen: Menschenrechte und Humanitäres Völkerrecht. Man geht davon aus, dass man mit Menschen zu tun hat, die Entscheidungen fällen. Als diese Rechtssysteme entwickelt wurden, war gar nicht daran zu denken, dass Menschen möglicherweise Entscheidungen darüber, wer leben und wer sterben wird, nicht mehr selbst fällen."

Grünes Licht für autonome Waffensysteme

Heyns hat den Vereinten Nationen in New York 2013 einen Bericht vorgelegt, der Pro- und Contra-Argumente auflistet. Am Ende plädiert er weder dafür, autonomen Waffensystemen grünes Licht zu geben, noch für ein Verbot. Er hält ein Moratorium für sinnvoll.

"Ein Moratorium, das besagt, dass Roboter nicht selbst tödliche Entscheidungen fällen und Staaten die Möglichkeit dazu nicht wahrnehmen, bis sich ein hochrangiges Gremium detailliert mit diesem Thema auseinandergesetzt hat."

An anderer Stelle in den Vereinten Nationen, nicht im Bereich Menschenrechte, in dem Christof Heyns aktiv ist, sondern im Bereich der Genfer Konventionen, steht das Thema ebenfalls auf der Agenda. Mitte Mai 2014 haben Experten in Genf über autonome Waffensysteme beraten, die erste große internationale Konferenz zu diesem Thema. Geladen war auch der Ex-Bundeswehr-General und Sicherheitsforscher Wolfgang Richter. Für ihn gibt es außer Verbot und Nicht-Verbot noch andere Optionen:

"Es muss nicht unbedingt ein Verbot bestimmter Waffensysteme sein, sondern es müsste klargestellt werden, das wäre jedenfalls auch eine Lösung, dass es eine internationale Erklärung gibt, die deutlich macht, dass die Kriterien der Unterscheidung und der Verhältnismäßigkeit und der Verantwortung der Kommandeure auch im Zeitalter der Robotik gelten und dass man als internationale Staatengemeinschaft dies unterstreicht."

Eine Klarstellung, dass die bewährten Regeln weiterhin gelten, ob nun Menschen oder Maschinen Entscheidungen fällen. Ein sechstes Protokoll zur UN-Waffenkonvention, das unter anderem nach Landminen und blind machenden Laserwaffen nun auch tödliche autonome Waffensysteme verbietet, würde nach Meinung mancher Experten die existierenden Regeln verwässern. Wenn jede neue Technik gesondert verboten wird, könnte das im Umkehrschluss bedeuten, dass alles andere legal wäre. Vielleicht müssen vielmehr das Humanitäre Völkerrecht und andere Übereinkünfte neu gefasst werden. So könnte grundsätzlich klargestellt werden: Auch wenn Soldaten immer abhängiger von Technik werden, ihre Entscheidungen immer stärker von Sensoren und Algorithmen beeinflusst werden, so müssen sie es letztlich bleiben, die Entscheidungen über andere Menschenleben fällen. Verantwortlich sind immer Menschen. Technische Systeme, Computer und Roboter, ob bewaffnet oder nicht, ob intelligent oder inselbegabt, bleiben Werkzeuge und Gehilfen.