Maschinen streben nicht die Weltherrschaft an

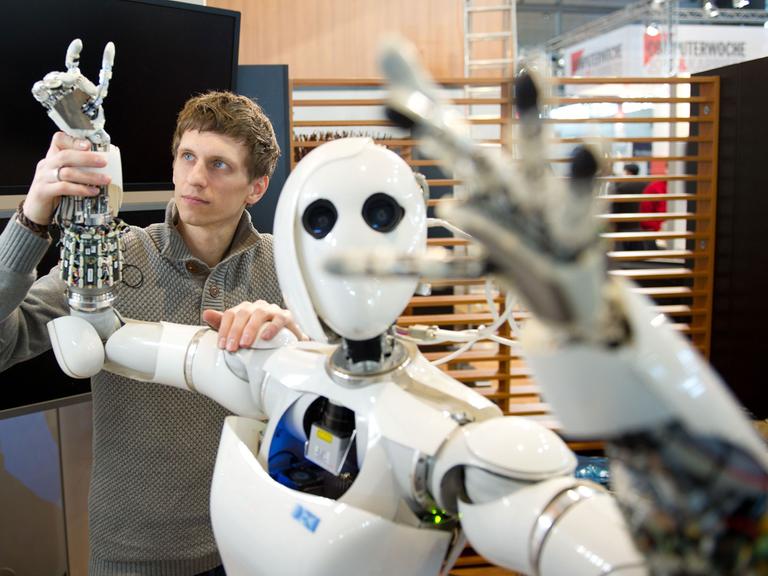

Ein Computer hat sich erstmalig als Mensch ausgeben können. Die Frage, ob Maschinen jemals die Herrschaft über den Menschen anstreben könnte, sei keine absurde Idee, meint Paul Lukowicz. Paul Lukowicz, der Leiter Deutsches Forschungszentrum für Künstliche Intelligenz, glaubt dass wir immer mehr Maschinen bauen werden, die dem Menschen ähneln.

Joachim Scholl: Eugene Goostman ist 13 Jahre alt, stammt aus der Ukraine und ist definitiv ein Mensch. Zumindest waren mehrere Experten der britischen Royal Society davon überzeugt, die sich mit Eugene Goostman unterhielten, ohne ihn zu sehen allerdings, im Zuge eines sogenannten Turing-Tests, den der britische Mathematiker Alan Turing vor mehr als einem halben Jahrhundert ersonnen hat und bei dem es darum geht, künstliche Intelligenz von menschlicher zu unterscheiden. Bis jetzt hat keine Maschine diesen Test bestanden - bis jetzt.

Am Telefon ist jetzt Professor Paul Lukowicz, Wissenschaftlicher Direktor beim Deutschen Forschungszentrum für künstliche Intelligenz in Kaiserslautern. Guten Morgen, Herr Lukowicz.

Paul Lukowicz: Guten Morgen!

Scholl: Forscher weltweit diskutieren nun dieses Ergebnis. Die einen sprechen vom Durchbruch und Meilenstein bei der Entwicklung künstlicher Intelligenz, andere sagen, halb so wild, kritisieren veränderte Parameter des Tests. Was sagen Sie, Herr Lukowicz, Sensation oder künstliche Aufregung?

Lukowicz: Ich denke, dass das, was die Kollegen da erreicht haben, durchaus eine bemerkenswerte technische oder wissenschaftliche Leistung ist. Von einem Durchbruch in der künstlichen Intelligenz würde ich nicht sprechen. Ich persönlich halte das für wie gesagt eine tolle technische Leistung, aber etwas, was jetzt keine sehr große Signifikanz hat.

Turing-Test in erster Linie ein philosophisches Statement

Scholl: Wie bedeutsam ist dieser Turing-Test? Ein britischer Wissenschaftler hat jetzt kommentiert, keiner wäre kontroverser und ikonischer als dieser Turing-Test. Wozu ist dieses Verfahren überhaupt notwendig?

Lukowicz: Für mich ist der Turing-Test in erster Linie ein philosophisches Statement in Bezug darauf, was man anstreben sollte, in Computern zu realisieren, als ein strenges Verfahren, um die Leistungsfähigkeit von Computern zu bewerten. Der Herr Turing selber hat ganz strikte Kriterien dafür beschrieben, was ein Computer prinzipiell kann und was er prinzipiell nicht kann. Von daher musste er keinen Test erfinden, um zu bewerten, was der Computer kann. Der Test sagt einfach aus, dass wir uns gar keine Gedanken machen sollten, ob der Computer intern so denkt wie der Mensch und so gebaut ist wie der Mensch und so tickt wie der Mensch, sondern wir sollten einfach gucken, was er kann. Und wenn das, was der Computer kann, von anderen Menschen nicht von dem unterschieden werden kann, was vielleicht ein Mensch machen würde, ein intelligentes Wesen, dann sollten wir akzeptieren, dass der Computer recht nah an unsere Intelligenz herankommt.

Scholl: Es heißt in diesem Zusammenhang, dass es schon Programme gäbe, die weitaus mehr drauf hätten als jetzt das Programm des Eugene Goostman.

"Menschen sind leicht zu täuschen"

Lukowicz: Wenn Sie sich angucken, was teilweise Computerprogramme heute können, Gesichter erkennen, Sprache erkennen in komplexen Umfeldern, Autos können selbständig im Straßenverkehr fahren, ich denke, dass vieles davon durchaus anspruchsvoller ist als, sage ich mal, der Versuch, eine Gruppe von Probanden in einem Zwei-Minuten-Gespräch zu täuschen. Menschen sind eben leicht zu täuschen. Wie gesagt, ich möchte damit die Leistung gar nicht herunterspielen. Was da alles an Sprachverständnis und Strategien dazugehört, ist beeindruckend. Aber im Prinzip ist es nichts, wo ich sagen würde, ich hätte nicht gedacht, dass der Computer das kann. Wir werden in nächster Zeit mit Sicherheit Programme erleben, die nicht nur 30 Prozent, sondern 70, 80, 90 Prozent der Menschen täuschen können.

Scholl: Warum aber, Herr Lukowicz, ist diese Nagelprobe doch noch so interessant, oder zumindest wird in der Öffentlichkeit dann so breit aufgenommen? Kann eine Maschine denken, reagieren wie ein Mensch? Man könnte ja umgekehrt sagen, um Gottes Willen, bloß nicht, Maschinen sollen gar nicht agieren wie Menschen, so irrational auch, Maschinen sollen doch erst mal gehorchen.

Lukowicz: Für mich ist der Punkt, dass der Turing-Test eigentlich gar nichts darüber aussagt, ob die Maschine denken, handeln und fühlen kann wie ein Mensch. Der Turing-Test sagt etwas darüber aus, inwieweit Menschen so weit getäuscht werden können, dass sie den Unterschied nicht erkennen. Das sind doch zwei sehr unterschiedliche Fragestellungen.

Computer löst bloß Aufgaben

Scholl: Aber erst mal muss es der Computer ja so hinbekommen!

Lukowicz: Das ist richtig und dazu gehört - und ich glaube, das ist das, warum der Turing-Test auch in der wissenschaftlichen Community nach wie vor eine interessante Aufgabenstellung ist -, denn auch zu dieser Täuschung gehört auf technischer Ebene ganz schön viel, ganz schön Anspruchsvolles. Für mich sagt es aber einfach nichts darüber aus, inwieweit der Computer in irgendwelchen Formen menschlich ist. Es ist eine Aufgabe wie viele andere Aufgaben, die der Computer auch löst.

Scholl: Ein Computer besteht erstmals den Turing-Test - Deutschlandradio Kultur im Gespräch mit dem Experten für künstliche Intelligenz Professor Paul Lukowicz. - Als die Meldung vom bestandenen Turing-Test die Runde machte, Herr Lukowicz, dauerte es keinen Tag bis zu den ersten Warnungen auch vor einem solchen erfolgreichen Programm. Cyber-Kriminelle würden sich das flugs zunutze machen. Sehen Sie auch diese Gefahr?

Lukowicz: Ich denke, an dieser Stelle sicherlich nicht. Es ist so, dass natürlich diese Vorstellung, dass ich als Mensch etwas, was ich sehe, nicht unterscheiden kann, ob es von einem Menschen oder von einem Computer kommt, hat einen sehr hohen emotionalen Wert zunächst mal. Ich glaube, der praktische Wert davon ist nicht sonderlich groß.

Scholl: Na ja, aber Stichwort emotionaler Wert, Herr Lukowicz. Wir finden es ja alle toll, dass unser Navigationsgerät im Auto nicht mehr klingt wie Darth Vader, sondern eine angenehme emotionale Stimme hat, oder Sprachprogramme auch angenehme menschliche Stimmen haben. Kann es nicht passieren, dass uns demnächst ein Programm weiß machen möchte, wir hätten in der Lotterie gewonnen und müssten jetzt aber erst mal 20 Euro überweisen?

Vision von der Maschinenwelt

Lukowicz: Das ist richtig, wobei die Frage ist, wenn man tatsächlich einen solchen Betrag aufzieht, ob es nicht einfacher ist, einen Menschen hinzusetzen. Ich hätte davor keine großen Bedenken. Vor allem denke ich mir mal, dass bis wir so weit sind, dass das Programm das wirklich kann, noch eine ganze Weile vergeht. Die Frage ist natürlich oder die Gefahren, die ich da sehe, sind die: Die Computer gewöhnen sich immer mehr daran, dass Computermenschen Dinge machen können, die die Menschen auch können, und die überlassen den Computern immer mehr: die Steuerung von Autos, die Steuerung von Flugzeugen und so weiter. Und man wiegt sich da so ein bisschen in Sicherheit, dass der Computer wahrscheinlich das alles kann, was wir auch können, und dann stellt sich immer heraus, dass es eben Ausnahmesituationen gibt, in denen es doch nicht funktioniert. Dann sind wir manchmal als Menschen nicht vorbereitet zu übernehmen und für mich sind da eher die Gefahren.

Scholl: Dieses Feld, das Sie gerade ansprechen, Herr Lukowicz, das ist ja untrennbar verknüpft mit der menschlichen Vorstellungskraft, die sich in zahllosen Büchern und Filmen niedergeschlagen hat. Die Vision von der Maschinenwelt, vom Blade Runner bis zum Terminator bis zum Minority Report, und das zentrale Motiv - und Sie haben es gerade angesprochen - ist die Kontrolle, die die Maschinen dann einfach haben, auf die wir uns verlassen, und dann übernehmen sie uns. Lacht da ein Fachmann wie Sie darüber, oder sieht der da schon einen ernsten Kern drin?

Lukowicz: Ich glaube schon, dass da ein ernster Kern ist. Der ist aber nicht so sehr dadurch gegeben, dass wir da eine Maschine haben, die jetzt irgendwie als böses, intelligentes Individuum denkt und Gefühl hat, die Macht übernehmen zu müssen. Die Gefahr liegt in der Komplexität. Indem wir Maschinen erfinden und bauen, die in sehr, sehr schwierigen Alltagssituationen Dinge steuern, die bisher Menschen gesteuert haben, indem ganz, ganz viele solcher Maschinen miteinander um den Menschen interagieren, verlieren wir langsam die Fähigkeit vorherzusehen, was das System wann tut, und dann übernimmt das System quasi die Welt oder führt zu Dingen, die wir gar nicht vorhergesehen haben. Wie gesagt, das ist nicht die böse Maschine, die die Weltherrschaft anstrebt, weil sie wie ein Mensch nach Herrschaft strebt, sondern es ist einfach ein System, das so kompliziert geworden ist, dass keiner mehr versteht, wie es funktioniert, und es dadurch eben nicht unbedingt das tut, was es tun sollte.

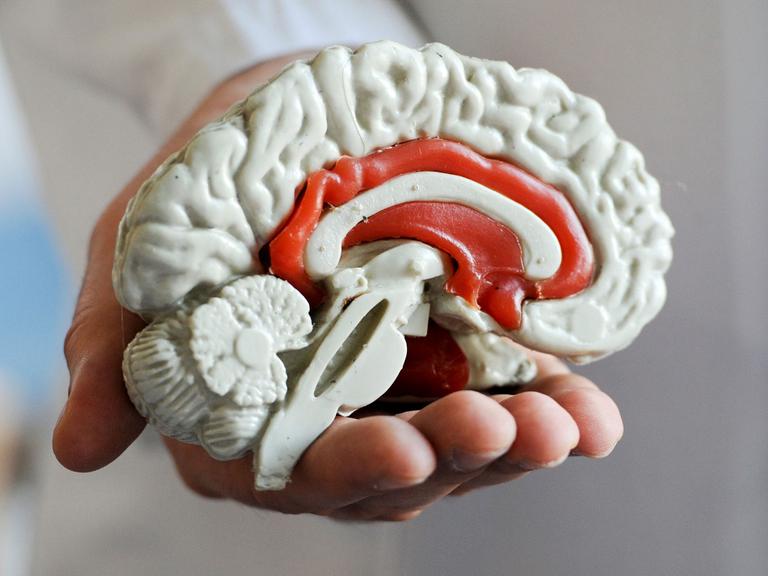

Was genau ist Intelligenz?

Scholl: Ich kann mich an einen furchtbar machtvollen Satz in einem der Terminator-Filme erinnern. Da heißt es, der Computer Skynet hat ab einem bestimmten Zeitpunkt eigenes Bewusstsein entwickelt. Und dieses Wort Bewusstsein, das ist ja, glaube ich, ganz entscheidend auch bei den Forschungen der künstlichen Intelligenz. Herr Professor Lukowicz, werden wir dahin kommen, dass Maschinen eigenes Bewusstsein haben?

Lukowicz: Um die Frage zu beantworten, müsste man erst mal die Frage beantworten, was ist denn Bewusstsein. Das ist der Grund, warum ich persönlich bei dem, was ich tue, mit dem Begriff künstliche Intelligenz gar nicht so zufrieden bin. Denn wenn ich künstliche Intelligenz bauen möchte, dann tue ich so, als ob ich wüsste, was eigentlich Intelligenz ist, und ich denke, diese Frage haben wir noch gar nicht ausreichend beantwortet. Da liegt auch so ein bisschen die Signifikanz des Turing-Testes. Ich glaube, wir werden mehr und mehr Maschinen bauen können, die in ihrem Verhalten von dem menschlichen Verhalten kaum zu unterscheiden sind.

Scholl: Eugene Goostman, das Computerprogramm, das erstmals als Mensch durchgeht - wir haben die Ansicht von Paul Lukowicz gehört, Wissenschaftlicher Direktor beim Deutschen Forschungszentrum für künstliche Intelligenz in Kaiserslautern. Herzlichen Dank für das Gespräch.

Lukowicz: Danke schön!

Äußerungen unserer Gesprächspartner geben deren eigene Auffassungen wieder. Deutschlandradio Kultur macht sich Äußerungen seiner Gesprächspartner in Interviews und Diskussionen nicht zu eigen.