Tiere zu verstehen, mit Tieren zu sprechen – das ist ein Traum vieler Menschen.

Mein Interesse an Tierkommunikation kommt daher: Ich nahm an, Delfine haben eine Sprache, die wir entschlüsseln würden. Und dann würden wir gegen Ende meiner Karriere mit Delfinen sprechen können.

Tecumseh Fitch, Kognitionsbiologe

Bislang ist das ein unerfüllter Traum geblieben. Zumal es ein paar grundlegende Hindernisse zu überwinden gilt. Auch philosophische.

Wittgenstein ist bekannt für den Ausspruch: „Wenn ein Löwe sprechen könnte, wir könnten ihn nicht verstehen.

Karen Bakker, Bioakustikerin

Das hält Forschungsteams allerdings nicht davon ab, es trotzdem zu versuchen. Denn der technische Fortschritt eröffnet ihnen neue Möglichkeiten.

Es wird kleiner, leichter, billiger und damit natürlich auch für uns besser einsetzbar. Und auch die Auswertetechnik hat sich natürlich verbessert. Also was man jetzt mittlerweile machen kann, um Schall zu analysieren, hat sich natürlich auch noch mal verbessert und damit können wir dann gezieltere Fragen an die Tiere auch stellen.

Mirjam Knörnschild, Biologin

Viele Daten zu sammeln, reicht nicht aus

Menschen sind heute in der Lage, sehr einfach sehr viele Tierlaute aufzunehmen – Wissenschaftlerinnen und Wissenschaftler machen das selbst – und lassen sich außerdem in Citizen-Science-Projekten von Laien helfen. „Es genügt nicht, einen Haufen Daten zu sammeln“, erklärt Tecumseh Fitch.

Wie wäre das wohl, wenn Aliens uns Menschen mit Mikrofonen beobachteten? Dann könnten diese außerirdischen Bioakustiker doch dem Irrtum aufsitzen, dass wir mithilfe unserer Fürze kommunizieren. Dass Flatulenz Sprache ist. Das sind schließlich auch Geräusche. Und vielleicht würde eine künstliche Intelligenz, eine KI, darin Muster finden, wenn sie lange genug sucht.

Geräusche allein sind also zu wenig. „Sobald man wirklich verstehen will, worüber sich Tiere unterhalten, braucht man diesen sozialen Kontext natürlich in den Inputdaten, mit der dann die KI irgendwas anfangen kann“, sagt Mirjam Knörnschild.

Manche Teams treiben einen enormen Aufwand, um diese Informationen zusammenzutragen und in Rechnersysteme einzuspeisen. Wird es also irgendwann eine Art Google Übersetzer für Tiere geben? "Das ist natürlich sehr ambitioniert, aber theoretisch könnte das möglich sein“, meint Elodie Briefer.

Der Zilpzalp ist ein häufiger Vogel in deutschen Städten. Auch in Chemnitz. „Ein unglaublich präsenter Vogel. Laut zu hören und supereinfach zu erkennen“, erklärt Stefan Kahl. Eigentlich. Dennoch hat Stefan Kahl das Gezilpe und Gezalpe viele Jahre lang einfach überhört.

"Ein unglaublich präsenter Vogel", sagt Stefan Kahl über den Zilpzalp.© picture alliance / HMB Media / Heiko Becker

Doch dann hat der Informatiker von der Technischen Universität Chemnitz begonnen, an der Entwicklung

der Smartphone-App BirdNET mitzuarbeiten.

„Mir ist es immer passiert, dass wenn ich die Kinder zur Tagesmutter gebracht habe, dass der Zilpzalp gesungen hat, als wir zur Tür raus sind, und das hat sich so eingeprägt. Vorher ist mir das nie aufgefallen. Der hat die Jahre davor garantiert auch schon gesungen. Aber ich habe es einfach nicht gemerkt, weil ich nicht wusste, wie er klingt. Und jetzt weiß man das und jetzt achtet man auf einmal mehr drauf und wurde sensibilisiert durch die Arbeit mit der App“, erzählt er.

Akustische Muster maschinell erkennen

Stefan Kahl hatte sich den Ruf des Zilpzalps eingeprägt. Die Melodie. Das akustische Muster. Solche Muster zu erkennen, ist alles andere als trivial. Und Stefan Kahl wollte eine Maschine diese Muster erkennen lassen. Am schnellsten funktionierte das über einen Umweg.

„Wenn man sich mit Audio beschäftigt, denkt man erst mal nicht an irgendwas mit Bildern oder dass man das irgendwie darstellen kann auf dem Display. Uns ist aber relativ schnell klar geworden, dass die Techniken, die es für die Bildverarbeitung gibt, sehr viel weiter fortgeschritten sind als die Dinge, die es für die Audioverarbeitung gibt“, erklärt er.

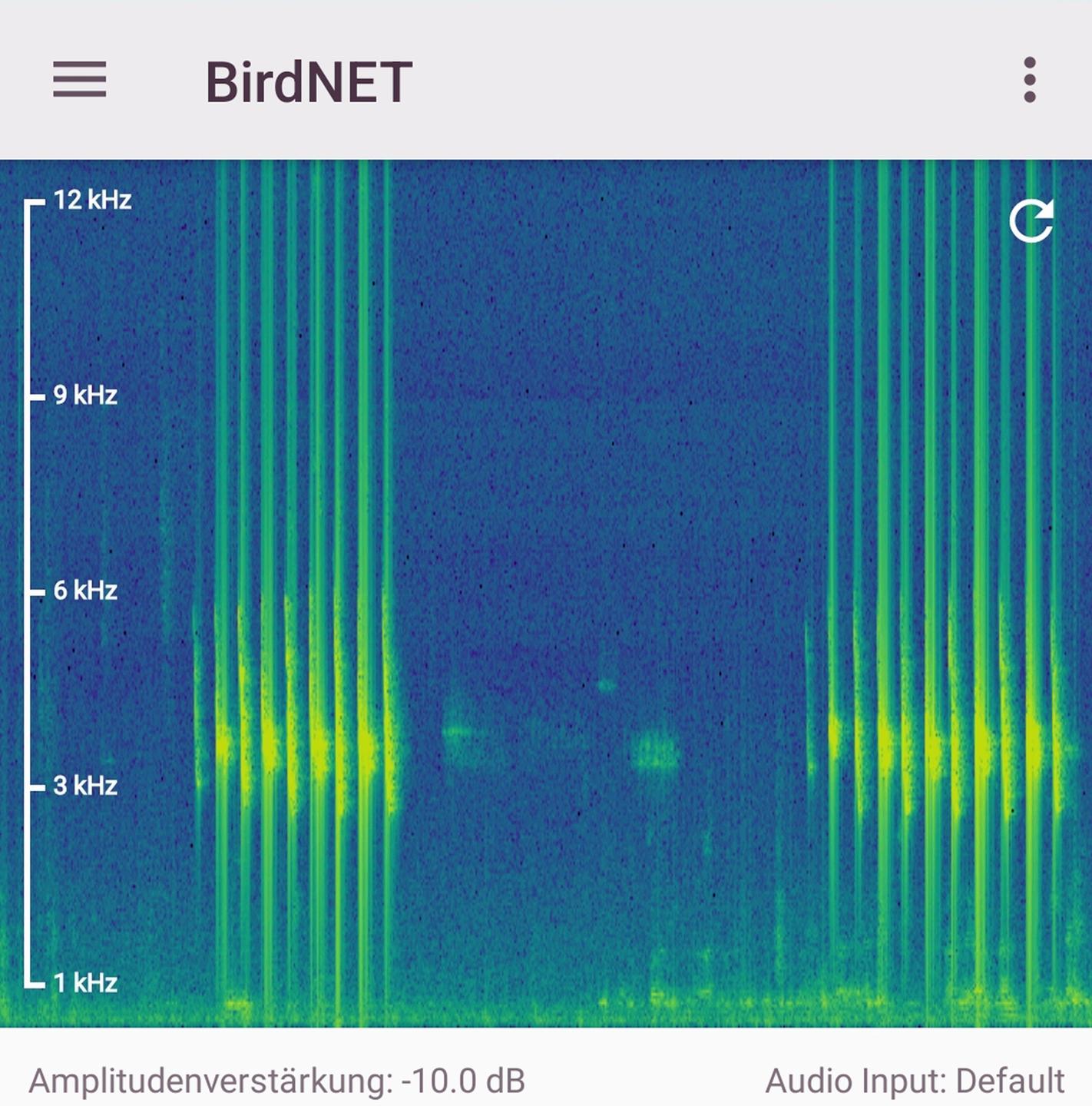

Wer die Smartphone-App BirdNET aufruft und den Zilpzalp aufnimmt, bekommt ein ganz einfaches Bild zu sehen: Auf einer blauen Fläche heben sich grüne und gelbe Punkte und Linien ab. Wo sie zu sehen und wie hell sie sind, hängt von ihrer Frequenz, also der Tonhöhe ab, und von ihrer Lautstärke. Am unteren Bildschirmrand bei den tiefen Tönen ist in der Stadt das ferne Dröhnen des Verkehrs als Streifen zu sehen. Die hohen Töne der Vogelstimmen erscheinen weiter oben als Gekrackel auf dem Display. „Spektrogramm“ heißt so ein Bild im Fachjargon.

Als Mensch, der ein visuelles Wesen ist, ist auch viel einfacher, visuelle Muster zu erkennen als Muster im Audio. Es war ein logischer Schritt, zu sagen: Wir nehmen Spektrogramme. Dann haben wir auch einmal Bilder draus gemacht. Wir können die Verfahren aus der Bildverarbeitung nehmen, die sehr viel besser funktionieren. Die Spektrogramme, die sind seit Jahrzehnten ein gängiges Mittel in der Ornithologie schon gewesen, um Vogelstimmen darzustellen.

Stefan Kahl, Informatiker

Beim Gesang des Zilpzalps sind das gelbe Krakel etwas unterhalb der Bildschirmmitte. Wer genau hinschaut, kann die höheren und die tieferen Rufe unterscheiden.

„Die Stimme des Vogels ist codiert“

„Man sieht auch als Laie relativ gut, wo der Vogel gerade singt, das Geräusch, das man aufgenommen hat, und man hat diesen Benefit eben noch, dass man schon eine Ahnung davon hat: Das habe ich doch schon mal gesehen. Dieses Muster, das kommt mir bekannt vor“, erklärt Stefan Kahl.

Spektrogramm aus der BirdNET-App: So sieht es aus, wenn ein Zilpzalp singt.© BirdNET-App / Screenshot

Der Algorithmus hinter der App macht im Prinzip dasselbe. „Die Stimme des Vogels ist codiert in diesen Spektrogrammen. Da guckt dann der Algorithmus nach Mustern, die er schon mal gesehen hat, und versucht dann, den Vogel zu bestimmen“, sagt der Informatiker.

Die App soll Menschen helfen, Vögel anhand ihres Gesangs zu bestimmen, und das ist wirklich praktisch. Denn gerade die scheuen gefiederten Tiere lassen sich oft nur aufspüren, wenn man ihren Stimmen folgt. Sie bringt den Userinnen und Usern die Vogelwelt näher. Damit auch sie Zilpzalpe am Ruf zu erkennen lernen.

Doch die App liefert auch den beteiligten Biologen interessante Erkenntnisse. Sie erfahren, welche Vögel zu welcher Zeit wo auf der Welt zu finden waren. Denn das Team aus Forschern der TU Chemnitz und des Ornithologie-Labors an der Cornell University in Ithaka, New York, bekommt viele Daten.

„Man kann das zeigen, dass die Daten, die wir über die App bekommen, gut genug sind, um Dinge nachzubilden, die man sonst mit wahnsinnig viel Aufwand manuell erheben müsste“, sagt Stefan Kahl. „Es sind ja wirklich Massendaten. Wir haben über 100 Millionen Beobachtungen, die mit der App gemacht wurden. Unser Ziel ist es jetzt auf kontinentaler Ebene mit diesen Massendaten Dinge abzubilden, die man vielleicht gar nicht manuell erheben kann.“

Vogeldialekte werden erkannt

Stefan Kahl und das Team der BirdNET-App versuchen also, herauszufinden, wer spricht. Gar nicht so sehr, was der Inhalt der Botschaft ist. Denn das ist deutlich schwieriger.

„Wir haben zum Beispiel den Kranich da drin und Zugrouten abgebildet. Wir haben Dialekte der Goldammer mit drin und wir haben Dialekte von einer amerikanischen Sperlingsart mit drin“, erzählt er. „Das sind genau die Dinge, die man jetzt in einem Maßstab machen kann, der vorher nicht denkbar ist, weil einfach die Massendaten fehlen. Wir haben jetzt Massendaten. Klar sind die vielleicht ein bisschen unsauberer als professionell erhobene Daten. Aber über die Masse, denke ich, machen wir das wieder wett.“

Wenn sie nicht zu sehr durcheinanderrufen, kann Stefan Kahls KI schon viele Vogelarten gut erkennen. Wenn es aber um den Inhalt dieser Rufe geht, ist sie noch komplett überfordert. Nicht nur technisch.

„Bei ganz wenigen Vogelarten oder Tierarten ist das halbwegs bekannt, warum sie vokalisieren. Bei den allermeisten anderen ist es vollkommen unklar und völlig im Dunkeln, warum sie wann, wie singen und wie rufen. Wenn man da dahinterkommen möchte, muss man noch mal ein bisschen das Rad des Machine Learnings weiterspinnen“, sagt Stefan Kahl. „Da kommen andere Komponenten dazu, die ich visuell eigentlich einfach machen kann. Also die Rufe gerade bei Vögeln, die haben ja eine soziale Komponente. Wie kriege ich denn diese soziale Komponente in diese Verfahren mit rein?“

Schweine „verstehen“ ist einfacher

Wenn Schweine quieken – in was für einer Stimmung sind diese Tiere? Wie fühlen sie sich? Ist zu erkennen, welche Emotionen durch ihren Körper gehen?

„Schreie von Schweinen habe ähnliche Eigenschaften wie menschliche Schreie. Darum sind wir einigermaßen gut darin, die Gefühle dieser Schreie zu bestimmen“, sagt Elodie Briefer. Sie erforscht an der Universität Kopenhagen in Dänemark, wie Tiere über Laute kommunizieren.“

Wie ist die Stimmung im Stall? Elodie Briefer und ihr Team haben beobachtet, welche Laute die Schweine in welchen Situationen machen.© picture alliance / CHROMORANGE / Udo Herrmann

Intuitiv würden wir die hohen Schreie korrekterweise mit negativeren Gefühlen verbinden. Aber bei den tieffrequenten Grunzlauten ist es weniger offensichtlich, welche positiv sind und welche negativ.“

Trotzdem hat sie einem Computer beigebracht, wie er die Stimmung im Schweinestall erkennen kann.

„Das Konzept der Emotionen ist umstritten – in der Forschung zu Menschen genau wie bei Tieren. Ich definiere Emotionen als eine kurzfristige Reaktion auf bestimmte Ereignisse, die zu Veränderungen in unserem Körper führen. Die können körperlich sein, geistig oder die Wahrnehmung betreffen, oder auch das Verhalten. Zumindest wir Menschen erkennen einige dieser Veränderungen. Alle Wirbeltiere sind in der Lage, solche Emotionen zu erleben“, erklärt sie.

Aber wie lassen sich Gefühle messen?

Dazu benutze ich, was wir als die zwei Dimensionen der Gefühle bezeichnen. Statt einzelne Gefühle zu benennen, statt zu sagen, ein ist Tier ‚glücklich‘ oder ‚traurig‘, sage ich einfacher: Das Tier ist in einem positiven oder einem negativen Zustand – wir fragen also einerseits nach der Valenz der Emotion. Und andererseits nach ihrer Intensität. Das nennen wir die Erregung.

Elodie Briefer, Biologin

Elodie Briefer und ihr Team haben beobachtet, welche Laute die Schweine in welchen Situationen machen. Hungrige Ferkel, Ferkel, die unter ihre Mutter geraten, Ferkel bei der Kastration – alles negative Situationen. Wenn ein Ferkel dagegen einem Geschwistertier wiederbegegnete oder wenn ein Jungtier zu seiner Gruppe zurückkehrte, dann wertete die Biologin das als positive Situation.

Technische Hilfe für Schweinezüchter

“Für diese Laute haben wir Parameter wie Dauer, Frequenz oder Lautstärke untersucht. Die Spektrogramme der Laute haben wir in ein neuronales Netzwerk eingespeist und es anhand der Bilder lernen lassen, zwischen positiven und negativen Lauten zu unterscheiden“, erklärt sie. „Der Computer war schließlich in der Lage, in 92 Prozent der Fälle die richtige Valenz zu bestimmen. In 82 Prozent der Fälle konnte er sogar korrekt deuten, in welcher der 19 verschiedenen Situationen das Tier den Laut abgegeben hat, den wir aufgenommen haben.“

Die Technik soll Schweinezüchtern helfen, das Wohlbefinden ihrer Tiere im Auge zu behalten. Nicht einmal in kleinen Betrieben können die Bäuerinnen und Bauern ständig die Situation aller Schweine erfassen. In großen Betrieben könne ein System, das ständig die positiven und negativen Laute der Schweine registriert, eine große Hilfe sein, wenn der Bauer etwas im Stall verändert.

“Mehr negative Rufe bedeutet: Da geht etwas schief. Steigt hingegen die Zahl der positiven Rufe, funktioniert die Verbesserung. Eine gute tägliche Überwachung also.“ Das Schweineprojekt ist nur ein Projekt. Eigentlich untersucht Elodie Briefer, wie Tiere und Menschen verschiedene Arten von Gefühlen ausdrücken, und ob sie sich untereinander verstehen.

Erkennen Tiere die Gefühle von Menschen?

„Ich habe mir Przewalski-Pferde und domestizierte Pferde, Ziegen, Schafe, Rinder, Wildschweine und andere Arten angeschaut. Sie drücken die Intensität ihrer Gefühle oft auf dieselbe Weise aus. Zum Beispiel, wenn ich gestresst werde, spreche ich schneller, mit höherer Stimme oder lauter, mein Mund wird trocken“, erklärt die Biologin.

Und weiter: „Das alles hängt mit der Stressverarbeitung im Körper zusammen und ist sehr vorhersagbar in all unseren Arten. Aber bei den Faktoren, die damit zusammenhängen, ob die Laute etwas Positives oder Negatives ausdrücken, sehen wir sehr wenige Übereinstimmungen. Eine Ausnahme: Kürzere Rufe sind in positiven Situationen verbreitet unter den Arten.“

Elodie Briefer spielte all diesen Tieren auch Laute von Menschen vor. Ein bisschen untersuchten diese Experimente, ob die Tiere die Gefühle von Menschen erkennen: “Wir spielten ihnen Laute vor und betrachteten ihre Reaktionen. Wenn man so will, ist das eine Art Gespräch. Wir stellen ihnen Fragen und sie reagieren.“

Nicht immer gab es eine Antwort. „Die Domestizierung von Tieren hat Einfluss darauf gehabt, wie sie Gefühle ausdrücken. Daran könnte es liegen, dass Hausschweine, aber nicht Wildschweine in der Lage sind zu unterscheiden zwischen positiven und negativen menschlichen Lauten“, sagt die Biologin.

Feldforschung mit Fledermäusen

Wenn Mirjam Knörnschild Fledermäuse beobachtet, ist sie in ihrem Element. „Das ist eigentlich das Beste an meinem Beruf, die Feldarbeit tatsächlich.“ In Costa Rica hat sie die Große Sackflügelfledermaus gefunden. Die hat ein paar entscheidende Vorteile für Forschende. Normalerweise schlafen Fledermäuse tagsüber ja. Diese Fledermausart nicht.

„Die ist nämlich fast den ganzen Tag über wach und sozial auch aktiv, die ist sehr lichttolerant. Das heißt, sie hängt an der Außenseite von so großen Brettwurzelbäumen oder von Häusern oder Brücken, und die hängen auch nicht so aufeinander geklumpt wie andere Fledermausarten, sondern die halten so ein bis zwei Körperlängen Abstand zueinander“, erzählt sie.

Und weiter: „Wenn Tiere mal so einen Baum oder so ein Haus oder so für sich sozusagen für gut befunden haben, dann sind sie quartiertreu. Das heißt, sie bleiben dann ihr ganzes Leben in dieser Kolonie. Solche Kolonien können auch über viele Generationen von Fledermäusen Bestand haben.“

Sehr praktisch, wenn die Biologin jedes Jahr wieder dieselben Tiere beobachten will. Dazu markiert Mirjam Knörnschild Fledermäuse mit farbigen Ringen an den Flügeln, bestimmt ihre DNA und die Verwandtschaftsverhältnisse. Sie kann ihnen sogar kleine Mikrofone aufkleben und sie während des Flugs belauschen.

Große Sackflügelfledermäuse kommunizieren mit relativ tiefen Tönen.© imago images / Morales / Morales via www.imago-images.de

Die Sackflügelfledermäuse kommunizieren mit relativ tiefen Tönen – für Fledermäuse, das heißt: statt im Ultraschall im hörbaren Spektrum. Denn um Fledermausrufe für uns Menschen hörbar zu machen, muss man sie normalerweise verlangsamen.

"Dann machen die ihr Fledermausding"

Wenn Mirjam Knörnschild zur Beobachtung aufbricht, stimmen die Tiere einen zarten Morgenchor an.

Wir stehen morgens auf im Dunkeln, laufen zu den uns bekannten Kolonien, setzen uns dort hin und warten. Also wir haben die Tiere dann habituiert an unsere Gegenwart, das geht relativ gut bei dieser Art. Das heißt, die lassen einen dann bis zu zwei, drei Meter auch wirklich an sich ran. Dann machen die so ihr Fledermausding und ignorieren uns im besten Fall komplett. Wir sitzen einfach da mit unseren Computern und unseren Videokameras und unseren Notizbüchern und machen Beobachtungen.

Mirjam Knörnschild, Biologin

Auch Mirjam Knörnschild und ihr Team arbeiten mit Bildern, mit den Spektrogrammen. Der Computer zeichnet die Laute der Tiere auf. „Dann ordne ich zu: Welches Tier hat was gesagt, in welchem Verhaltenskontext war das“, erklärt sie.

Und – worüber unterhalten sich die Fledermäuse? „Ich denke darüber, worüber sich die meisten Tiere unterhalten. Sex, Real Estate, solche Sachen, also es geht natürlich tatsächlich viel um Besitz. Territorialität spielt bei vielen Fledermausarten eine große Rolle, egal ob das während der Nahrungssuche ist, dass Ressourcen verteidigt werden“, sagt die Biologin.

„Im Fall der Großen Sackflügelfledermaus ist es so, dass einzelne Männchen wirklich ein bis zwei Quadratmeter Fläche an so einem Baum für sich beanspruchen. Da versuchen sie dann, möglichst viele Weibchen davon zu überzeugen, dass sie doch bitte bei ihnen wohnen sollen und nicht bei dem Konkurrenten nebenan. Mütter und Jungtiere tauschen sich natürlich viel miteinander aus. Da gibt es wirklich ganz, ganz viele unterschiedliche Szenarien.“

Am Naturkundemuseum in Berlin speist Mirjam Knörnschild die Töne und die Beobachtungsdaten in einen Computer ein.

Bessere zeitliche Auflösung im Gehör als Menschen

„Mit neueren Methoden, die zum Beispiel aus der menschlichen Sprach- und auch Sprechererkennung kommen, die in unseren Smartphones verbaut werden, kann man natürlich jetzt auch tierische Lautäußerungen analysieren und da auf Entwicklungen zurückgreifen, die ursprünglich für Menschen gemacht wurden“, erklärt sie. „Wir haben zum Beispiel die Klangfarbe von Fledermausmüttern verglichen, wenn die mit ihren Jungtieren sprechen, versus wenn sie mit adulten Artgenossen sprechen. Und siehe da, die Klangfarbe ändert sich. Genauso, wie wenn wir mit Babys reden würden. Und das konnte man früher einfach nicht, weil man diese Auswertungsmethode nicht hatte.“

Ohne Vermittlung von Algorithmen geht es nicht. „Fledermäuse, die kommunizieren ja häufig im Ultraschallbereich, und die Lautäußerungen sind auch für unser Gehör eigentlich zu schnell. Tatsächlich. Also Fledermäuse haben eine viel bessere zeitliche Auflösung im Gehör als wir. Das heißt, wir müssen die zeitverlangsamt abspielen, und wir wissen einfach nicht, wie man Sachen verlangsamen muss, damit es so klingt, wie das für eine Fledermaus gut oder relevant klingen würde“, erzählt sie.

Wie sehr ein Mensch mit seinen Annahmen zu den Lautäußerungen danebenliegen kann, hat Mirjam Knörnschild bei einem anschaulichen Beispiel gemerkt.

„Weil die relativ tieffrequente Lautäußerungen haben, die sehr weit in unseren Bereich hineingehen, bin ich immer davon ausgegangen, dass die menschliche Sprache natürlich gut hören können müssen. Das heißt, ich habe einer ganzen Generation von Studenten gesagt, sie müssen leise sein in der Nähe dieser Tiere“, erzählt sie. „Es hat sich herausgestellt, sie hören uns wirklich also, glaube ich, gar nicht. Wenn man jetzt so im normalen Tonfall redet und jetzt nicht furchtbar brüllt oder so, dann bewegen wir, glaube ich, für die nur die Lippen.“

Die faszinierenden Gesänge der Buckelwale

1970 wurden Buckelwale Musikstars. Der Wissenschaftler Roger und Katy Payne hatten erkannt, wie schön die Stimmen der riesigen Meeressäuger waren. Damals wurden die Tiere fast bis zur Ausrottung bejagt. Die Schallplatte „Songs of the Humpback Whale“ machte auf die Bedrohung und die Faszination aufmerksam.

„Dieses Album wurde eine Platin-Schallplatte. Es ist noch immer das meistverkaufte Naturalbum aller Zeiten“, erzählt Karen Bakker. Es führte mit dazu, dass die Vereinten Nationen 1972 ein zehnjähriges Walfangmoratorium erließen. Die Paynes erkannten aber auch, dass diese Gesänge Muster enthielten, eine innere Struktur.

Buckelwalmutter mit Nachwuchs im Meer vor Japan: "Die Opernsänger der Ozeane", sagt Karen Bakker.© picture alliance/ AP/ Yasunari Itayama

Karen Bakker von der University of British Columbia im kanadischen Vancouver ist Bioakustikerin wie Roger Payne. Sie erzählt diese Geschichte in ihrem Buch „The Sounds of Life“, das 2022 erschienen ist und zeigt, wie Digitaltechnologie uns die Welt der Tiere und Pflanzen näherbringt.

Die unterschiedlichen Walarten erzeugen viele komplexe Laute. Buckelwale sind die Opernsänger der Ozeane, andere sind Jazzsänger, Pottwal-Kommunikation erinnert an Morse. Wale haben so ein vielfältiges und individuelles Repertoire an Gesang, aber auch aus anderen Lauten.

Karen Bakker, Bioakustikerin

Zwei Projekte in den USA beschäftigen sich jetzt intensiv mit Pottwal-Lauten. Das ist alles andere als trivial.

Neue Erkenntnisse dank moderner Technologien

„Um herauszufinden, ob diese Laute bedeutsame Informationen über den Lebensraum der Tiere transportieren, muss man die Wale beobachten. Tief unter der Wasseroberfläche ist das natürlich schwierig, aber es hat ein paar wirklich coole Fortschritte in der Digitaltechnologie gegeben, die uns die Blackbox Walkommunikation öffnen“, sagt Karen Bakker.

Forscher kleben Walen mit Saugnäpfen sogenannte DTAGs auf, Geräte kleiner als ein Handy. Sie nehmen nicht nur Ton auf, sondern erfassen gleichzeitig etwa, in welcher Tiefe, in welcher Lage und wie schnell sich der Wal bewegt. Auf diese Weise hat ein Forschungsteam etwas ganz Neues über eine Glattwal-Art im Nordatlantik herausgefunden.

„Nordkapermütter flüstern mit ihren Jungen. Diese Wale gebären in Gewässern voller Haifische. Die Alten haben nichts zu befürchten, aber die Babys. Darum nutzen die Mütter ihnen gegenüber eine vollkommen andere Form der Kommunikation, die wir nie entdeckt hätten ohne diese neuen Technologien“, erläutert Karen Bakker.

Das Earth Species Project will sogar noch weiter gehen. Dieses Team möchte eine Übersetzungssoftware erschaffen, die irgendwann sämtliche Tierkommunikation entschlüsseln können soll.

Die Daten zu sammeln und Muster zu finden, ist das eine. Eine Bedeutung herauszulesen, ist eine noch viel komplexere Aufgabe, sagt Karen Bakker.

„Denn wir wissen nicht, ob Wale Silben haben oder Phoneme. Wir wissen nicht einmal, ob die Laute überhaupt einen Inhalt transportieren. Vor ein paar Jahrzehnten ist eine sehr interessante Studie erschienen, die vorgeschlagen hat, Wale kommunizieren in dreidimensionalen Hologrammen. Wale sehen ja in 3-D, weil sie sich unter Wasser über Echo-Ortung orientieren. Sie verwenden also Laute statt Sicht. Es ergäbe Sinn, wenn sie eine Sprache entwickelt hätten, die Konzepte in dreidimensionalen Bildern darstellt statt in einem Alphabet“, so die Bioakustikerin.

Es stellen sich aber auch ethische Probleme.

Warnung vor Missbrauch der Forschung

„Stellen Sie sich jetzt mal vor, irgendeine KI würde den Pottwal-Code knacken, und man wüsste jetzt zum Beispiel, was man den Tieren vorspielen müsste, damit sie auftauchen. Ja, kann man sich natürlich vorstellen, dass das andere Leute nutzen würden. Seien das jetzt Leute, die Whale Watching anbieten, oder seien das Leute, die Tiere kommerziell irgendwo jagen, in Gegenden, wo das noch erlaubt ist“, sagt Mirjam Knörnschild.

Das eröffnet Missbrauchsmöglichkeiten. Und Mirjam Knörnschild ist überzeugt, dass es Menschen geben wird, die sie nutzen.

„Ich kann mich einfach an kein einziges Beispiel erinnern, wo man, sage ich mal, sich eine indigene Sprache zu eigen gemacht hat, und das hat nicht dazu geführt, dass man die Leute irgendwie ausgenutzt hat. Letztendlich. Und es würde mich wahnsinnig wundern, wenn es bei Tieren anders wäre“, sagt die Biologin.

Es zeigt sich aber noch ein ganz grundsätzliches Problem: Wale bewegen sich tief unter der Wasseroberfläche in einer Umgebung, die für Menschen tödlich ist. Fledermäuse „sehen“ mit den Ohren. Dass wir diese Analogie benutzen, zeigt schon, wie schwer es uns Menschen fällt, über Dinge, Situationen und Wahrnehmungen zu sprechen, die uns vollkommen fremd sind.

Andere Forscher bezweifeln, dass wir jemals mit Tieren werden sprechen können. „Es ist eine unlösbare Aufgabe, irgendwie eine andere Art vollständig zu verstehen“, sagt Mirjam Knörnschild.

Mehr Gesang als Sprache

Auch Tecumseh Fitch ist da sehr skeptisch: „Alle Anzeichen weisen dahin, dass Vogelgesang und Walgesang mehr wie Musik sind. Darum nennen wir sie schließlich 'Gesang' und nicht 'Sprache'.“ Der Kognitionsbiologe von der Universität Wien bestreitet gar nicht, dass viele Tiere Laute haben, die in bestimmten Situationen eine eindeutige Bedeutung haben, eine Botschaft.

„Die berühmten Alarmrufe von Meerkatzen zum Beispiel, überhaupt Alarmrufe. Die meisten Vogelarten haben mindestens zwei Alarmrufe für verschiedene Fressfeinde. Die zu entschlüsseln, wäre eine sinnvolle Anwendung für künstliche Intelligenz“, erklärt er. „Aber bei den meisten Vogellauten fehlt so ein klarer Bezug. Darum lassen sie sich nicht ins Englische oder ins Deutsche übersetzen.“

Meistens singen die Vögel also vermutlich auch über Sex, Wohnlage, Nahrungsangebot.

„Ich glaube, es ist vernünftiger, diese komplexen erlernten Laute wie Vogelgesang oder Walgesang mit Musik zu vergleichen. Dieses Modell passt viel besser zu dem, was wir über Tierkommunikation wissen. Und was würden Sie auf die Frage antworten: Was sagt John Coltrane in diesem Saxofonsolo?“ ZITAT Tecumseh Fitch, Kognitionsbiologe

Wie komplex ist Tierkommunikation?

Mirjam Knörnschild vom Naturkundemuseum Berlin sieht es ähnlich. „Wenn man Sprache so definiert, wie wir Menschen das haben, also als ein Kommunikationssystem, mit dem man sozusagen alles, was jemals denkbar wäre, ausdrücken kann, dann definitiv nicht. Ich wüsste kein einziges Tier, dass diese Form von Komplexität in der Kommunikation besitzt. Und es ist durchaus möglich, dass wir Tierkommunikation unterschätzen in ihrer Komplexität. Ich denke aber nicht, dass wir sie in diesem Maße unterschätzen.“

Karen Bakker, die Buchautorin und Bioakustikern von der University of British Columbia, lädt hingegen zu einem Gedankenexperiment ein.

„Vielleicht werden Sie und ich nie wie eine Biene summen oder wie eine Fledermaus oder ein Delfin echo-orten können. Aber wenn wir so einen Algorithmus als Vermittler haben, vielleicht integriert in einen Roboter: Dann könnte der Algorithmus Fledermäusisch lernen. Und weil er ein Algorithmus ist, könnte er auch die menschliche Sprache lernen. Das Programm könnte übersetzen, auch wenn wir selbst nicht dazu in der Lage wären“, sagt sie.

Und schließlich: „Der Punkt ist, dieses Gedankenexperiment ist interessant. Wir haben ausreichend Beweise dafür, dass Algorithmen in der Lage sind, menschliche Sprachen auch ohne Wörterbuch über sehr unterschiedliche Kulturen hinweg zu entschlüsseln. Daher, den Versuch ist es wert, und das ist es, was Wissenschaftlerinnen und Wissenschaftler gerade machen.“

Autor: Joachim Budde

Es sprechen: Anika Mauer, Tilmar Kuhn, Christiane Jensen und Anne Rathsfeld

Ton: Alexander Brennecke

Regie: Stefanie Lazai

Redaktion: Michael Böddeker