Wie Roboter den Menschen verstehen lernen

Computer können schon heute mit bis zu 80prozentiger Richtigkeit die Emotionen eines Menschen bestimmen. Das kann in Zukunft zum Beispiel für die Therapie Kranker eingesetzt werden. Doch auch Missbrauch ist möglich.

Seit vielen Jahren versuchen Wissenschaftler Computern beizubringen, was Gefühle sind. Bei Wettbewerben lassen sie ihre Algorithmen gegeneinander antreten. Björn Schuller von der Universität Passau organisiert solche Wettbewerbe.

"Dort, kann man sagen, vergleicht sich die Weltelite sozusagen, was Sie schaffen kann. Teilweise 65 Teams, die dort teilnehmen und erreichen vielleicht um die 80 Prozent Zuverlässigkeit bis teilweise leicht darüber, unter realen Bedingungen."

Das heißt, die Programme versuchen, die Emotionen eines Fremden zu beurteilen, während eine menschliche Jury dasselbe tut. Sie geben beispielsweise an, wie positiv oder wie erregt jemand ihnen erscheint. Die Einschätzungen von Mensch und Maschine stimmen laut Björn Schuller zu 80 Prozent überein. Dazu müssen die Algorithmen noch nicht einmal besonders komplexe Daten auswerten. Die Forschungsgruppe von Björn Schuller legt ihren Schwerpunkt auf reine Audiodaten, also die Erkennung von Emotionen aus der Stimme. Das hat viele denkbare Anwendungen etwa in der Gesundheitsinformatik.

"Bei der Stimmanalyse haben wir gewisse Verfahren geschaffen, die es uns ermöglichen die Emotion zu erkennen, haben uns von dort hin zur Depressionserkennung, die ja auch gefühlt noch sehr naheliegt, weiterentwickelt. Wenn wir zum Beispiel Rett-Syndrom oder Autismus oder irgendsoetwas früh diagnostizieren, dann liegt das immer noch sehr fühlbar nahe denn wir merken wir hier dann sozusagen mit den technischen Systemen atypisches emotionales Verhalten zu erkennen."

Die Algorithmen lernen selbst

Die Verfahren, die die Forscher für Emotionserkennung entwickelt haben, basieren auf Deep Learning. Dabei lernen Algorithmen selbst, Unterschiede zu identifizieren. Die Forscher geben ihnen lediglich eine große Menge an Beispieldaten - also etwa Stimmproben oder Videobilder von depressiven und nicht-depressiven Menschen.

"Wir müssen immer weniger dem Computer überhaupt sagen: Hör auf die Frequenz, hör auf das Tempo, schau auf die Nase. Sondern das ist immer mehr so, dass wir anhand großer vorhandener Datenmengen, dem oft genannten Big Data, tatsächlich mit rohem Material in den Computer hineingehen können. Das heißt wir präsentieren dem Computer einfach nur das Audio-Signal und der Computer findet seine eigenen Repräsentationsformen, die dann nachher oft denen, die man als Experte vorgegeben hätte, ähnlich sind, aber dann doch in mancher Weise abweichen und vielleicht so günstiger und sogar noch optimaler sind als die, die wir vorher vorgegeben hätten."

Das heißt, die Algorithmen merken selbst, woran sie etwa eine Depression erkennen können. Emotionserkennung funktioniert nicht nur mit Stimmaufnahmen, sondern ist auch mit Messwerten wie Herzfrequenz oder Hautleitwert denkbar, vielleicht sogar mit Hirnstrom-Signalen.

"Und da es bei diesen Signalen für uns oft noch abstrakter ist, was man auswerten sollte, ist es hier besonders vorteilhaft, dass der Computer eben mittlerweile mit tiefem Lernen von Ende zu Ende, das heißt direkt von dem rohen Signal, bis auf den Depressionsgrad lernen kann und seine eigenen Repräsentationen findet."

Die Analyse der Gefühlslage eines Menschen scheinen Algorithmen also schon gut zu beherrschen, manchmal vielleicht sogar besser als Menschen es können. Der nächste Schritt wäre, den Algorithmen selbst Gefühle einzuprogrammieren. Können Maschinen Gefühle haben? Und: Wozu wäre das gut? Fragen an Joanna Bryson, die an den Universitäten Bath und Princeton forscht. Sie wird grundsätzlich:

"Emotionen sorgen unter anderem dafür, dass sich ein Organismus selbst organisiert. Das ist ein System, das noch älter ist als das Nervensystem. Die Stoffe, die wir Neurotransmitter nennen, die Informationen an Neuronen übermitteln, die waren zum Teil schon vor den Neuronen da. Es gibt Tiere, die kein Nervensystem haben. Sie bestehen aus ein paar Zellen, die von den Stoffen koordiniert werden, die sogar bei uns Menschen Erregung oder Depression verursachen. Also, selbst wenn man nur zwölf oder 15 Zellen hat, muss man grundsätzlich entscheiden: "Leute, gehen wir jetzt los und machen was oder bleiben wir sitzen und kurieren uns aus oder verdauen Nahrung oder so."

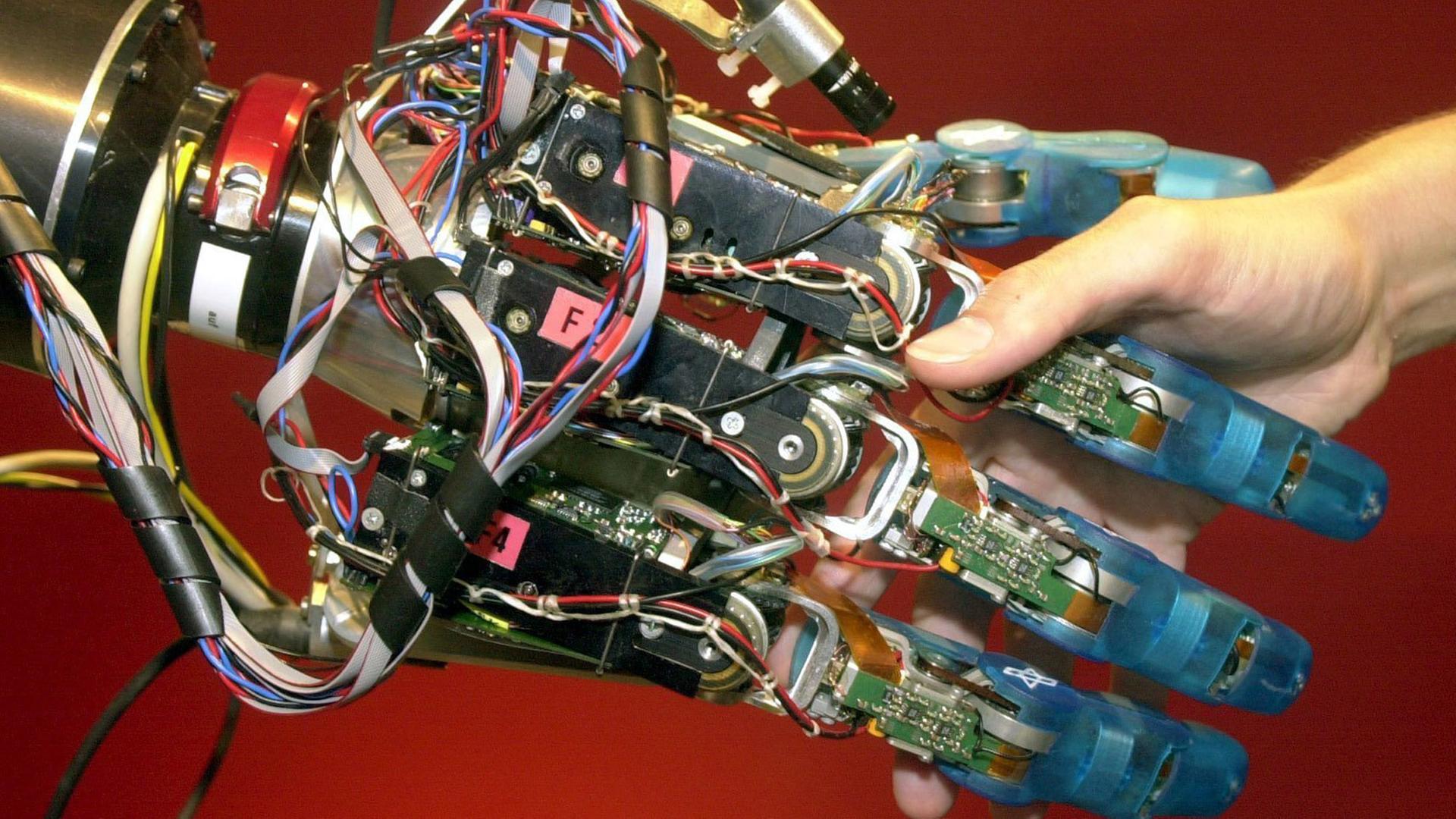

Joanna Bryson sagt, ein solches System könne auch in Robotern sinnvoll sein, um Entscheidungen zu fällen. Etwa, wenn ein Kampfroboter sich entscheiden muss zwischen weiter Kämpfen oder in die Werkstatt fahren zur Reparatur. Weil Menschen immer enger mit Robotern zusammenarbeiten, könnte es ebenfalls sinnvoll sein, die Maschinen mit einer Gefühlsebene auszustatten. Das ist für uns einfach der natürlichste Weg der Kommunikation.

Die empfindende Maschine wirft viele Fragen auf

Aber die Gefühle, die Maschinen empfinden, werden sich wohl nie mit denen von Menschen vergleichen lassen. Ein Kampfroboter muss nicht den Tod fürchten. Ein Pflegeroboter wird nicht trauern, wenn ein Mensch nach jahrelanger Pflege stirbt. Für Menschen ist es jedoch ein entscheidender Faktor, dass ihr Leben endlich ist. Das in einer Maschine zu reproduzieren, dürfte unmöglich sein. Und Joanna Bryson findet es auch nicht richtig, das zu versuchen. Denn eine Maschine, die fühlt wie wir, wirft moralische Fragen auf. Darf man ihr Angst machen? Darf man sie verletzen? Joanna Bryson sagt, wir seien verpflichtet, Maschinen zu erschaffen, denen wir uns nicht verpflichtet fühlen müssen.

"Wir machen uns viele Gedanken um Transparenz, also dass die Menschen verstehen, was die Künstliche Intelligenz macht. Und vor allem, dass die Menschen erkennen, dass es eine Maschine ist und kein Tier. Dass man sich nicht darum kümmern muss, dass man sie ausschalten kann, und dass es ihr nichts ausmacht, sie jahrelang im Schrank einzusperren."

Schließlich würden wir ja schon emotionale Bindungen zu Stofftieren aufbauen, sagt sie. Was ihr ebenfalls Sorgen macht, ist der Datenhunger der Künstlichen Intelligenzen. Assistenzsysteme wie Siri, Cortana und Alexa könnten uns und unsere Gefühlswelt schon bald besser kennen als wir selbst. Gleichzeitig ist Künstliche Intelligenz gut darin, Vorhersagen zu treffen. So wie Facebook angeblich schon heute weiß, wann sich ein Paar trennen wird. Wenn wir so selbst zu vorhersagbaren Maschinen werden, dann könnte das einen gravierenden Einfluss auf die Gesellschaft haben.

Gedanken über die ethische Dimension seiner Arbeit macht sich auch Björn Schuller an der Universität Passau. Ein System, das Depressive an ihrer Stimme erkennt - das kann leicht missbraucht werden.

Gedanken über die ethische Dimension seiner Arbeit macht sich auch Björn Schuller an der Universität Passau. Ein System, das Depressive an ihrer Stimme erkennt - das kann leicht missbraucht werden.

"Stellen Sie sich zum Beispiel ein Job-Interview der Zukunft vor, wo sie am Telefon erst mit einem Computersystemen sprechen und dieses mitverfolgen würde, derjenige ist zu aggressiv oder zu - was auch immer - zu negativ."

Die Technik müsse auch immer vermitteln, wie verlässlich eine Aussage ist, sagt Schuller. Dennoch habe sein Team von manchen Dingen, die Computer an der Stimme ablesen könnten, ganz die Finger gelassen. Welche das sind, will er nicht sagen. Das Missbrauchspotenzial wäre zu groß.