Problem für die Zukunft oder reine Fiktion?

Mit KI, Künstlicher Intelligenz, verbinden viele ein Horroszenario: herzlose Computer, die die Herrschaft übernehmen. Andere behaupten schlicht: KI hilft uns und steigert die Lebensqualität. Und für beide Richtungen finden sich ausreichend Argumente.

- "Uh"

- "That is a very... that is a very surprising move"

- "Uuuh"

- "I thought it – haha – I thought it was a mistake"

- "I thought it was a click miss, but ..."

- "That is a very... that is a very surprising move"

- "Uuuh"

- "I thought it – haha – I thought it was a mistake"

- "I thought it was a click miss, but ..."

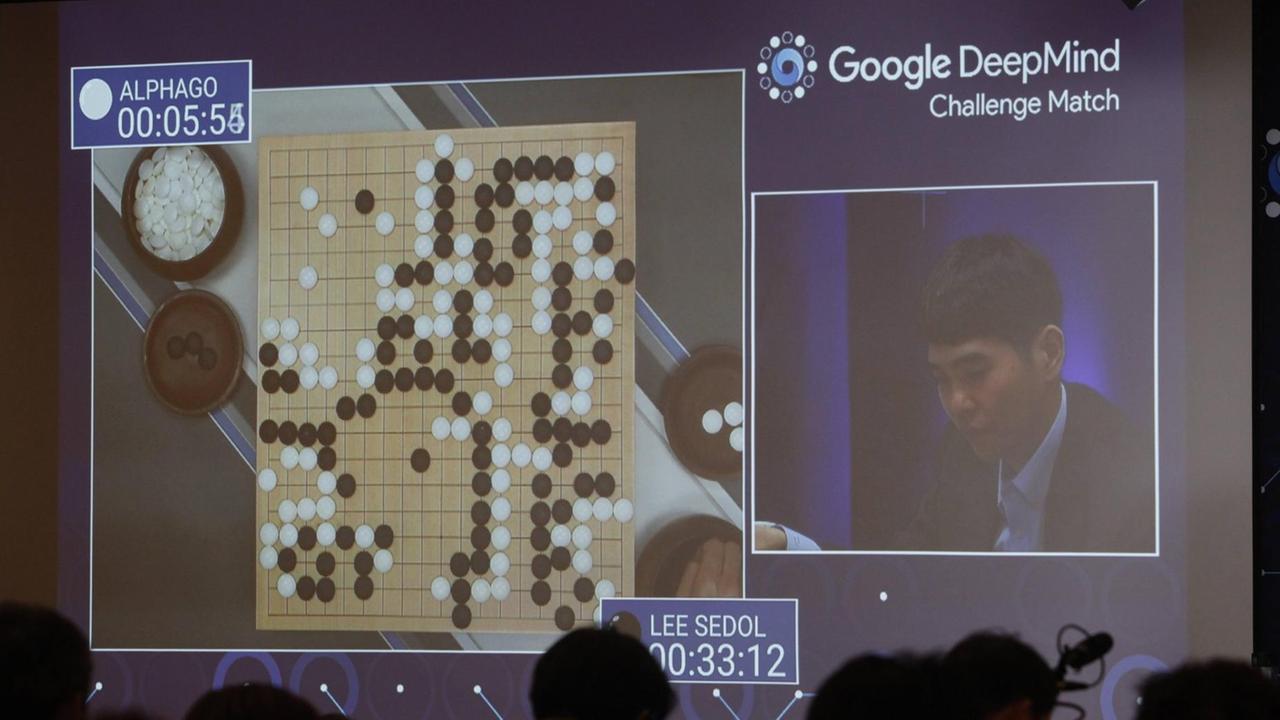

März 2016, ein Hotel in Seoul. Die beiden Kommentatoren sind aufgeregt: der 37.Zug im zweiten Spiel hat sie aufgeschreckt. Überraschend, sagt der eine. Der andere hält ihn für einen Fehler.

Es ist eine außergewöhnliche Partie des alten chinesischen Brettspiels Go, das die beiden kommentieren. Ein Duell Mensch gegen Maschine: Lee Sedol, einer der besten Go-Spieler der Welt, gegen AlphaGo, eine Künstliche Intelligenz der Firma DeepMind, die zum Google-Konzern gehört.

Go galt immer als besonders große Herausforderung für Computer. Weil das Spiel viel variantenreicher ist als Schach – und Profi-Spielern Intuition abverlangt.

Intuition, die Alpha Go mit Zug 37 demonstriert hat? Zumindest hat sie ihren Gegenspieler Sedol aus dem Konzept gebraucht

- "Lee has left the room."

- "He left the room after that?"

- "He left the room after that move."

- "Aha."

- "I mean..."

- "He had to go and wash his face or something.”

- "Hehe.”

- "Just to recover from this. It is a very surprising move.”

- "It was a surprising move!”

- "I wasn't expecting that. I dont really know if it is a good or a bad move at this point."

- "He left the room after that?"

- "He left the room after that move."

- "Aha."

- "I mean..."

- "He had to go and wash his face or something.”

- "Hehe.”

- "Just to recover from this. It is a very surprising move.”

- "It was a surprising move!”

- "I wasn't expecting that. I dont really know if it is a good or a bad move at this point."

Der Spieler habe den Raum verlassen, sagt der eine Kommentator. Während der andere noch sinniert, ob das nun ein guter oder ein schlechter Zug gewesen sei.

Später wird klar: Es war ein guter, ein sehr guter. Alpha Go gewinnt die Partie. Von Kreativität sprechen nachher viele Beobachter. Von Intuition. Von Überraschung.

Vier von fünf Duellen entscheidet AlphaGo am Ende für sich. Und seitdem steht die Frage im Raum: Ist dies der Punkt, an dem die Künstliche Intelligenz den Menschen überflügelt hat?

- "Open the pod bay doors, Hal!"

- "I am sorry, Dave. I am afraid I can't do that."

...

- "Irgendwann sehen die Kis auf uns zurück – als aufrecht gehende Affen: dazu verdammt, auszusterben."

- "I am sorry, Dave. I am afraid I can't do that."

...

- "Irgendwann sehen die Kis auf uns zurück – als aufrecht gehende Affen: dazu verdammt, auszusterben."

Von Filmen wie "2001 – Odysee im Weltraum" bis zu "Ex Machina" - Science Fiction ist voll von düsteren Visionen darüber, wie das aussehen könnte: Maschinen, die die Weltherrschaft an sich reißen und den Menschen entmündigen.

Komisch nur, dass wir doch längst mit Künstlichen Intelligenzen leben. Längst umspinnen sie uns fest im Alltag. Und kommen doch so anders, so unspektakulär daher: nicht als furchteinflößende Roboter, sondern als Software.

"Nach 140 Meter rechts abbiegen"

"..."

"I am locked out."

"I found three locksmiths fairly close to you."

"..."

"Das Spielezeug erkennt seine Vorlieben – und sorgt dafür, dass ihm nie langweilig wird."

"..."

"..."

"I am locked out."

"I found three locksmiths fairly close to you."

"..."

"Das Spielezeug erkennt seine Vorlieben – und sorgt dafür, dass ihm nie langweilig wird."

"..."

Siri und unser Navigationssystem, das intelligente Thermostat und die Bilderkennung bei Facebook, die Software, die Flugzeuge auf Autopilot fliegen lässt und die, die dafür sorgt, dass Spam-Filter funktionieren – hinter alldem stehen künstliche Intelligenzen, kurz: KI. Genauer gesagt: Das, was man in der Forschung Expertensysteme nennt, oder auch schwache oder enge Künstliche Intelligenz.

Das sind Systeme, die auf einen ganz speziellen Zweck getrimmt wurden. Die unseren Alltag bequemer gestalten sollen, die Lebensqualität steigern.

Praktisch ist das, die Fortschritte in den vergangenen Jahren rapide. Nur: Mit den hochfliegenden Träumen, die die Menschen anfangs mit Künstlicher Intelligenz verbanden, hat das nur noch wenig zu tun.

"Wenn man sich die Geschichte der KI ansieht – das ging ja los mit den großen Visionen, in den 50er Jahren"

Damals war die Aufregung groß. Das Zeitalter der Computer war gerade erst angebrochen – und dann kamen die Wissenschaftler Warren McCulloch und Walter Pitts auch noch mit der Idee um die Ecke, dass menschliche Neuronen und logische Operatoren von Rechenmaschinen doch im Grunde ganz ähnlich arbeiteten.

Der Mensch als eine Art Informationsverarbeitungsmaschine:Das euphorisierte die Szene und plötzlich schien kaum etwas nicht von Maschinen lösbar. Zumindest kurz.

Marvin Minsky, einer der Urväter der künstlichen Intelligenz, erinnert sich:

"Das Kuriose der Situation war also, dass wir eine Menge Sachen programmieren konnten, die sonst nur Experten erledigten. Etwa: einen Flugzeugflügel zu entwickeln mit guten Auftriebseigenschaften. Oder einen elektrischen Stromkreis für die effizienteste Ausnutzung elektrischer Energie zu konzipieren. Aber niemand war in der Lage, einen Rechner das beizubringen, was ein drei- oder vierjähriges Kind konnte."

Das bedeutet: Was Menschen durch Denken austüfteln mussten, fiel den Künstlichen Intelligenzen leicht, während sie mit allem haderten, was der Mensch quasi automatisch erledigt – vom Bewegen im Gelände bis hin zum Beurteilen von Dingen mit dem, was man gemeinhin den "gesunden Menschenverstand" nennt.

Kann eine Maschine interpretieren?

"Im letzten Jahrhundert sind wir noch davon ausgegangen, dass wir bis in die 80er Jahre hinein einen Computer schaffen können, der dem Menschen an Intelligenz und Können gleichkommt – also, das war eine Komplettabbildung des Menschen, das war das, was wir erreichen wollten", sagt Yvonne Hofstetter, Autorin und Geschäftsführerin einer Firma, die an Künstlicher Intelligenz arbeitet. "Und dieser Begriff der Intelligenz, der hat sich stark gewandelt. In der Informatik reden wir heute von Künstlicher Intelligenz, wenn Maschinen zwei Eigenschaften erfüllen: die erste Eigenschaft ist, dass eine Maschine lernen kann. Wie ein Haustier lernen kann. Und dass sie zweitens in der Lage ist, taktische oder strategische Entscheidungen unter Unsicherheit zu treffen."

Eine Art funktionaler Pragmatismus, könnte man sagen. Denn, das Grundproblem der Künstlichen Intelligenz bleibt stets, zu definieren: was ist das eigentlich, maschinelle Intelligenz? Und: wie messen wir, wie viel davon wir bereits erfolgreich in Maschinen eingefüttert haben?

"Versteht, argumentiert, interpretiert die Maschine? Das ist eine Projektion dessen, was wir tun. Die Maschine versteht und argumentiert und übersetzt nicht so, wie wir es tun. Aber: erreicht die Maschine das, was ich mit meinen Interpretationsfähigkeiten erreichen würde? Ja, das tut sie", sagt beispielsweise Luciano Floridi, Philosoph und Chef des Oxford Internet Institutes.

Und liefert damit ziemlich genau die Definition dessen, was viele als schwache Künstliche Intelligenz begreifen: Maschinen, die zwar mitunter ziemlich schlau wirken. Aber im Grunde genommen nur so tun als ob.

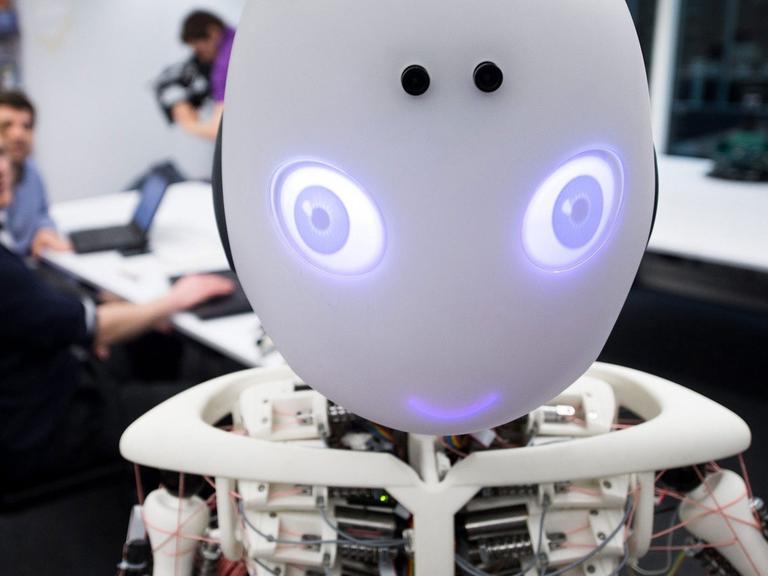

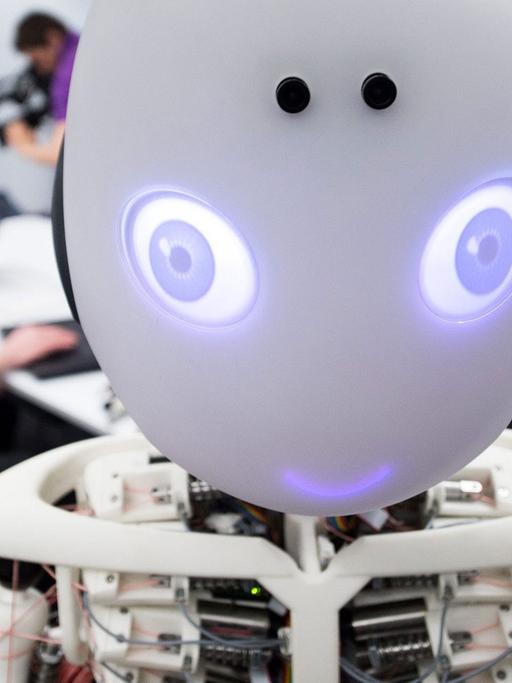

Human: "Stand up!"

Robot: "Ok."

Human: "Walk forward!"

Robot: "Sorry, I cannot do that as there is no support ahead."

Robot: "Ok."

Human: "Walk forward!"

Robot: "Sorry, I cannot do that as there is no support ahead."

Ziemlich bald nach dem Start der KI-Forschung war klar: der künstliche Nachbau des Menschenhirns würde doch nicht so leicht werden wie anfangs gedacht. Und so wandte man sich einer anderen Strategie zu, um Computer schlau zu machen: der symbolischen Künstlichen Intelligenz.

Intelligenz kann auch der Mensch nicht einfach nachbauen

Die Idee dabei: Wissenschaftler versuchen, mit Hilfe von formaler Logik menschliche Intelligenz auf die Verarbeitung abstrakter Symbole zu reduzieren. Die Künstlichen Intelligenzen bekommen Zugriff auf große Datenbanken, mit denen sie ihre Inputs abgleichen. Und weil das noch ziemlich viel menschlicher Unterstützung und Training bedarf, entstanden die vielen Expertensysteme.

Das wohl berühmteste Beispiel für symbolische KI ist DeepBlue – eine Maschine, die 1997 den besten Schachspieler der Welt besiegte.

Allerdings: Meist ist die Welt komplizierter, uneindeutiger als eine Schachpartie. Das heißt: Die Zahl der Probleme, die mit symbolischer Künstlicher Intelligenz gelöst werden konnten, blieb überschaubar.

Garri Kasparow.© dpa / picture alliance / Sharifulin Valery

Und so dümpelte die KI-Forschung lange vor sich hin. Bis die Künstlichen Neuronalen Netze eine Renaissance erlebten – besserer Hardware sei Dank, wie Klaus Mainzer, Professor für Philosophie und Wissenschaftstheorie an der TU München, erklärt: "Wir haben jetzt die Rechner (…) Wir haben jetzt die Rechenleistungen, die großen Speicherkapazitäten, die also dieses Deep Learning realisieren können. Dass man also ein neuronales Netz hat, mit mehreren Schichten, und damit besser analysieren kann – das war in den Achtziger Jahren eigentlich auch schon in der mathematischen Theorie, bekannt"

Erst seit wenigen Jahren lösen künstliche Neuronale Netze eine Herausforderung nach der anderen: in der Bilderkennung, in der Spracherkennung und in vielen anderen KIs, die unseren Alltag bereichern.

Doch wie funktioniert das? Yvonne Hofstetter erklärt: "Wir nutzen ja sogenannte neuronale Netze, künstliche Neuronen, die sich über Synapsen miteinander verbinden. Und das, was wir als Code dab ei erzeugen und was als Code beim Training einer solchen Maschine herauskommt, das ist subsymbolisch in dem Sinne, als es "nur" Gewichtungsstrukturen, Aktivierungsstrukturen dieser künstlichen Neuronen sind. Das heißt, Sie müssen sich das ähnlich vorstellen wie beim Gehirn, wenn sie einen Menschen ins MRT hineinschieben..."

Denn auch da wird sichtbar, ob einzelne Hirnregionen aktiv sind – oder eben nicht.

Im Grund funktionieren die einzelnen künstlichen Neuronen dieser künstlichen Netze ganz so, wie McCulloch und Pitts das bereits in den 1940ern angedacht hatten.

Maschinelles Lernen, Reinforcement Learning oder Deep Learning nennt man es heute, wenn diese künstlichen neuronalen Netze nicht nur reproduzieren, was man ihnen einprogrammiert hat, sondern selbstständig Lösungen finden.

"Das Wesen eines Lernenden Systems ist, dass es am Anfang dumm ist und mit der Zeit klüger wird. Dass es ständig Fehler macht – aber dann aus diesen Fehlern lernt. Das ist das fundamentale Prinzip. Das ist nicht so wie bei den alten Science-Fiction-Novels vom Asimov aus dem letzten Jahrhundert, wo es eben diese superklugen Roboter gab, die immer alles besser wissen und perfekt gut können. Nein. Im Gegenteil. Ein guter Lernalgorithmus ist einer, der flott vonstatten geht – und das, was er vorher nicht beherrscht hat, mit möglichst wenig Trainingsbeispielen sich erwirbt als neue Fähigkeit", erklärt Jürgen Schmidthuber. Er gilt als einer der führenden Köpfe der KI-Forschung weltweit – und ist wissenschaftlicher Leiter des Forschungsinstituts IDSIA in der Schweiz.

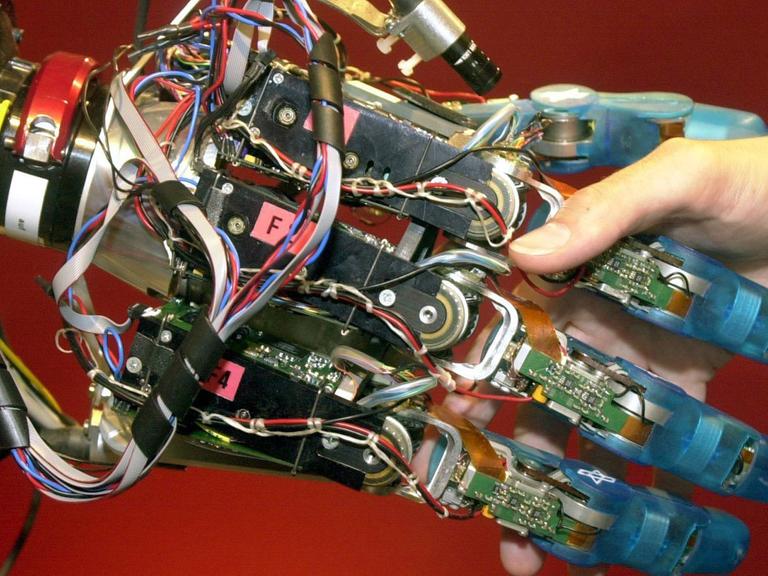

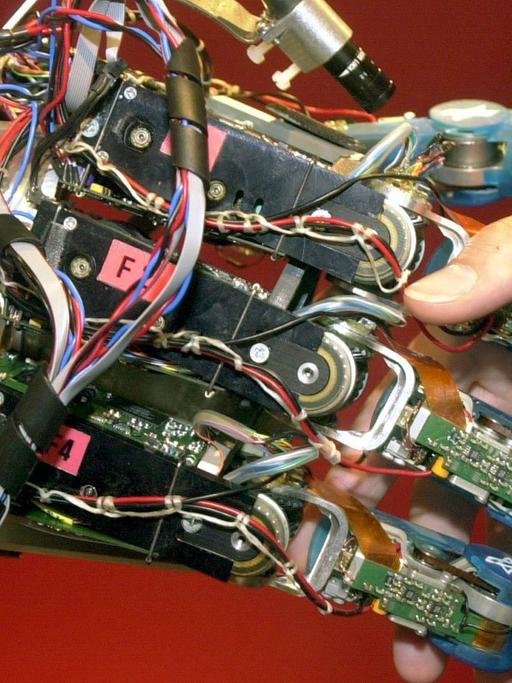

Nach dem Zusammenbau ist die große Frage: Was lernt das Biest?

Potent werden Künstliche Neuronale Netze über die schiere Masse künstlicher Neuronen, die in Schichten angeordnet sind und Input verarbeiten. Und meist kommt eine Kombination von Methoden zum Einsatz, wenn Künstliche Intelligenz-Systeme gebaut werden, sagt Yvonne Hofstetter: "Die Frage ist eben, wenn sie diese verschiedenen Netze in einander verschachteln: was lernt das Biest? Das ist jedes Mal wie ein großes Überraschungsei."

Denn: wenn die Systeme selbstständig Daten analysieren und Lösungswege suchen, ist es schwierig, von außen zu beurteilen, wie sie eigentlich zu ihren Erkenntnissen gelangt sind. Es entsteht eine Art Blackbox, bei der sehr undurchsichtig ist, was die Maschine eigentlich tut.

Was Künstliche Neuronale Netzwerke möglich machen – das demonstriert in den Augen vieler der Sieg von AlphaGo.

"Ich denke, das ist ein Meilenstein, der die Fortschritte zeigt, die beim Deep Learning und Reenforcement Learning in den vergangenen Jahren gemacht worden sind. Das ist eine Dramatisierung dessen, was in diesem Bereich möglich geworden ist", sagt Nick Bostrom, Physiker, Mathematiker, vor allem aber Philosoph und Leiter des Future of Humanity Instituts in Oxford, das sich der Zukunft der Künstlichen Intelligenz verschrieben hat.

Die KI-Unternehmerin Yvonne Hofstetter ist von der Go-Maschine weniger begeistert.

"Was wir (aber) bei AlphaGo gesehen haben, ist eigentlich eine recht alte Architektur, Systemarchitektur. Also, eigentlich arbeiten da zwei Systeme mit einander und zwar ein neuronales Netz, das berechnet, ob ein Zug gut ist oder schlecht. Und eines, das als Entscheider agiert. Was laut Hofstetter vor allem eines benötigt; richtig viel Rechenpower."

"Nachdem Google natürlich ein Riesen-Rechensystem zur Verfügung hat und es hier trainiert worden ist, ist es eben möglich gewesen, durch sehr viel Rechenleistung diese Aufgabe zu lösen. Und: Das funktioniert eigentlich nicht anders als dass dieses Rechensystem beim Training ganz ganz ganz viele Möglichkeiten, wie die Steine auf dem Brett sitzen können, durchrechnet. Und dann, wenn es live genommen wird und tatsächlich gegen den Menschen spielt, dann spielt es im Grunde nur das ab, was es kennt, und beurteilt dann eben in der jeweiligen Situation. Mehr ist das nicht!"

Und was ist mit AlphaGos Überraschungszug Nummer 37?

Jürgen Schmidthuber, hat selbst ein System entwickelt, das vor einigen Monaten zum Einsatz kam. Eine Künstliche Intelligenz, die ganz allein das Drehbuch für einen Science-Fiction-Film schrieb. Zuvor war die Maschine mit anderen Genre-Stoffen gefüttert worden: "Das ist ein Beispiel von dieser naiven Kreativität, die dadurch erwächst, dass man einfach ein System, ein lernendes neuronales Netzwerk, an vielen, vielen Beispielen die von Menschen produziert worden sind, trainiert. Und dann wird es eigentlich limitiert bleiben.."

… ganz einfach, weil es immer wieder Bilder und Muster und Filme ausgeben wird, die denen ähneln, mit denen das System trainiert worden ist.

"Richtig interessant wird es erst bei der wahren, aus dem System erwachsenden Kreativität", meint Schmidthuber.

Maschinen, die überraschende Dinge tun

Bei AlphaGo nun spielte die Maschine wieder und wieder gegen sich selbst, und entwickelte so offensichtlich auch Spielzüge, auf die ein Mensch so nicht gekommen wäre. Ein erster Schimmer von maschineller Kreativität? Yvonne Hofstetter winkt auch hier ab:

"Das weiß ich nicht, ob man das als Kreativität bezeichnen kann. Auf jeden Fall kommen solche Sachen vor. Die sind total überraschend, Wir sehen bei unseren Maschinen auch, dass diese Maschinen unter Umständen völlig überraschende Dinge tun, die überhaupt nicht intuitiv sind. | Weil sie einfach verschiedene Pfade einschlagen können. Die arbeiten ja mit Szenarien. Und dann springen die halt einfach von einem Pfad, einem Szenario wieder in ein anderes zurück, wenn die sehen, die Situation entwickelt sich auf eine bestimmte Art und Weise."

Die Interpretationen dessen, was AlphaGo geleistet hat und leisten kann, gehen weiter.

Der Go-Spieler Lee Sedol im Wettkampf mit der Software AlphaGo© Imago / Xinhua

Auch, weil Demis Hassabis, der Chef von DeepMind, das Duell seiner KI gegen einen Menschen im Go werblich voll ausschlachtet: "Wir haben immer darüber gesprochen: was wäre, wenn wir Go knacken und den Weltmeister schlagen können. Dafür hätten wir dann einen Allzweck-Algorithmus bauen müssen. Vielleicht stehen wir an der Schwelle dazu - aber das ist nur eine Sprosse auf der Leiter dahin, Künstlichen Intelligenz zu lösen."

Heißt es in einem Werbevideo der Firma.

Mit diesen Sätzen rückt Hassabis seine Künstliche Intelligenz in die direkte Nähe eines Traumes. Des Traumes von der allgemeinen Künstlichen Intelligenz.

Von einem System, das nicht nur eine einzige Aufgabe beherrscht, auf die es besonders trainiert wurde. Sondern das in der Lage ist, jede intellektuelle Herausforderung zu meistern, die ein Mensch auch lösen kann.

Es ist ein Traum, dem Künstliche-Intelligenz-Forscher schon seit Ewigkeiten hinterherjagen. Jürgen Schmidthuber etwa, der mit seinem Team bereits an einem künstlichen Kapuzineräffchen arbeitet, das Probleme des alltäglichen Affendaseins lösen soll – vom Entdecken von Futter über das Klettern auf einen Baum bis hin zum Verbergen des Fressens vor anderen Affen.

Gerade viele Praktiker glauben, dass es bis zum Erreichen der allgemeinen Künstlichen Intelligenz gar nicht mehr so furchtbar lange dauert. Yvonne Hofstetter: "Also, wir sind hier schon relativ weit. Ich rechne schon damit, dass wir in den nächsten 20 Jahren eine Maschine haben werden, die dem Menschen relativ ähnlich sein wird. Aber nicht in der vollen Ausprägung des Bewusstseins. Nicht in dem, was den Menschen wirklich ausmacht."

Maschinen mit Bewusstsein – das wäre wiederum das, was viele Forscher "starke Künstliche Intelligenz" nennen. Doch dass diese bald bevorsteht, bezweifeln die meisten aus der Branche. Technikphilosoph Luciano Floridi: "Künstliche Intelligenz, so Terminator-mäßig, das ist ein Witz. Keine Ahnung, warum Leute glauben, dass das unmittelbar bevorsteht. Das letzte Mal, als ich nachgesehen habe, da war dieser Computer hier nicht einmal in der Lage, sich mit dem Drucker zu verbinden. Und das war gestern. Jeder Schritt, den wir in den vergangenen 60 Jahren in der künstlichen Intelligenz gemacht haben, war rein syntaktisch."

Das Hauptproblem: Viele halten die Technologie für unreif. Selbst modernste neuronale Netze basieren im Grunde noch immer auf ganz ähnlichen Prinzipien wie jene, die McCulloch und Pitts in den 1940ern erdachten. Gerechnet wird auf Maschinen, die einst der Mathematiker Alan Turing während des 2.Weltkriegs konzipierte.

So viel Rechen- und Speicherkraft man auch aufwenden mag – diese Systeme, so glauben viele, finden ihre Grenzen.

"Die Hauptunsicherheit ist, dass es noch diverse Durchbrüche braucht, bis wir Intelligenz auf menschlichem Niveau erreichen. Und wir wissen nicht, wie schwierig diese Durchbrüche sind – oder wie viele wir brauchen werden", räumt selbst Nick Bostrom ein – dessen Institut von der Prognose lebt, dass es in absehbarer Zeit eine menschenähnliche KI geben wird.

Aber natürlich präsentiert sich DeepMind nach dem Triumph über Lee Sedol im März selbstbewusst, was das Potential ihrer Schöpfung angeht. Demis Hassabis: "Wir hoffen, die Technik langfristig für viele andere Probleme nutzen zu können. Wir wollen Wissenschaftlern helfen, einige der größten Herausforderungen zu lösen, im Gesundheitswesen und anderen Bereichen."

Technikphilosoph Luciano Floridi hat dafür nur Spott übrig. Und doch ist er auch beunruhigt – von unserer Tendenz, zunehmend Aufgaben an Maschinen zu delegieren, die er als dumm, als pseudointelligent bezeichnet:

"AlphaGo gewinnt jeden Tag Go-Partien. Nonstop. Würde in dem Raum ein Feuer ausbrechen, wird der menschliche Spieler rausrennen. Aber der Computer würde weiterspielen. Gewinnen und mit dem ganzen Gebäude niederbrennen. Weil es das ist, was er tut. Herzlichen Glückwunsch! "Aber das ist so eine schlaue Maschine", sagt man. Schon klar. Aber das ist ein Computer, dessen Zweck es ist, im Go zu gewinnen. Trotz eines Feuers weiterspielen – ist das die Intelligenz, über die wir hier reden? Natürlich nicht."

Ist das wirklich so einfach?

Wie sieht das denn Yvonne Hofstetter: AlphaGo als ein erster Schritt hin zur Allgemeinen Künstlichen Intelligenz: "Joa. Das sind unsere KI s im Grunde genommen auch, ja. Sie können auch sagen: die nehme ich jetzt für alle möglichen Problemlösungen her. Ich glaube – jetzt sag ich was ganz Böses: Ich glaube, die Technologien sind Pillepalle."

Wie bitte?

"Da werden Baukästen zur Verfügung gestellt und dann gibt es, ich sagte mal ganz vereinfacht Drag and Drop-Verfahren. Dann werden Künstlichen Intelligenzen mit irgendwelchen Daten beaufschlagt und dann kommt irgendetwas raus. Ich glaube aber, dass das der Irrweg ist. Künstliche Intelligenzen sind insbesondere dann ganz besonders leistungsfähig, wenn sie in ganz bestimmten Kontexten eingesetzt werden, um ganz dezidiert formulierte Probleme zu lösen."

Will sagen: manchmal ist es einfach Quatsch, ein Problem aus der realen Welt mit Künstlicher Intelligenz zu beackern. Besonders, wenn man sie planlos Datenberge durchpflügen lässt. Und das ist nicht das einzige, was Hofstetter aufstößt: "Google lässt folgende Propaganda verlauten über Deepmind: wenn wir die allgemeine künstliche Intelligenz geschaffen haben, dann haben wir alle Probleme der Menschheit gelöst. Sämtliche Probleme des Klimawandels, der Finanzmärkten, von Krankheiten. Ähnliches hören wir auch von Facebook. Und ich habe das Wort gerade schon in den Mund genommen: das ist Propaganda.Weil ich nicht glaube, dass es möglich sein wird, alle Probleme der Menschheit lösen zu können mit Künstlichen Intelligenzen."

Genau diese Weltproblemlösungsideen sind ein wichtiges Stichwort. Denn: Ob nun allgemeine oder starke Künstliche Intelligenz – an diesem Punkt wäre noch lange nicht Schluss. Entstehen könnten sogenannte Superintelligenzen – also Künstliche Intelligenzen mit übermenschlichen Fähigkeiten.

Das glaubt auch Jürgen Schmidthuber: "Langfristig erscheint es mir völlig abwegig, zu glauben, dass sich diese Entwicklung nicht verselbstständigen wird und dass wir in nicht so vielen Jahrzehnten zum ersten Mal KIs haben werden, die uns in jeder Hinsicht überlegen sein werden. Und die werden sich dann ausbreiten ins Sonnensystem hinaus und den Rest der Milchstrasse hinaus in einer Weise, die Menschen unmöglich sein wird. Und es wird einfach so ein ein neues Kapitel aufgeschlagen in der Geschichte des Universums, bei der Menschen keine große Rolle mehr spielen werden."

Die Überlegung ist: haben wir erst einmal Künstliche Intelligenzen geschaffen, die auf menschlichem Niveau operieren und selbstständig immer weiter lernen, ist der Sprung zum übermenschlich schlauen Superintelligenzen nicht mehr weit.

Nick Bostrom entwickelt an seinem Future of Humanity-Institut in Oxford Szenarien, was Superintelligenzen anrichten könnten – und überlegt, wie sie kontrollierbar bleiben würden: "Eine Künstliche Intelligenz wird darauf programmiert, Büroklammern zu produzieren. Wenn ihr nicht eingeschrieben wird, wann sie damit aufhören soll, fährt sie damit fort, bis alle Energiereserven der Erde aufgebraucht sind. Trotzdem will sie weiter an ihrem Ziel arbeiten – und attackiert den Menschen, der für sie nicht mehr ist als eine weitere potentielle Energiequelle."

Das klingt nach Science Fiction, sichert Bostrom aber sowohl Aufmerksamkeit als auch Millionenförderungen.

Auch Klaus Mainzer bewegt die Frage, wie man Künstliche Intelligenzen kontrolliert – wenn auch ein paar Nummern geerdeter. Entscheidend sei, dass der Mensch dem Computer weiter die Zielvorgaben mache, sagt er. "Die Gefahr will ich hier überhaupt nicht kleinreden. Die Gefahr kann natürlich sein – nicht heute, nicht mit diesem Go-Automaten, der sich dann irgendwann verselbstständigt und die Menschheit bedroht, also, da brauchen wir uns keine Angst vor zu haben. Aber es ist denkbar, dass, wenn wir auf dieser Linie weiterschreiten, in absehbarer Zeit, die Algorithmen auch gegeneinander antreten können, sozusagen. Und da müssen wir natürlich aufpassen. Deshalb muss mit einer solchen Technologie gleichzeitig wachsen auch das Controlling, würde man in der Wirtschaft sagen."

Jürgen Schmidthuber hält solche Ansätze für sinnlos. Er ist überzeugt, dass Superintelligenzen die Kontrolle ohnehin an sich reißen würden – egal welche Schutzmaßnahmen Menschen zu ergreifen versuchten: "Das erscheint mir dermaßen unausweichlich, dass ich da immer fast ein kleines Lächeln auf den Lippen habe, wenn ich da hören, dass man das vielleicht irgendwie stoppen könnte..."

Gefährlicher als KI ist die KD, die Künstliche Dummheit

Ein Kollege von ihm sieht das ganz anders: Raul Rojas ist Professor für Künstliche Intelligenz an der Freien Universität Berlin, wo er an Maschinellem Lernen, selbstfahrenden Autos und Fußballrobotern forscht. Er allerdings hält Superintelligenzen nicht für eine unmittelbare Bedrohung für die Menschheit: "Man ist in der Forschung schon froh, wenn ein autonom fahrendes Fahrzeug alle Passanten richtig erkennt, so dass Abstand gehalten wird. Eine Situation, wo ein Computerprogramm so schlau ist, dass es sich verbessert und eine unkontrollierte Explosion an Intelligenz sich über den ganzen Globus verbreiten kann - davon sind wir weit entfernt."

Ähnlich wie Philosoph Floridi besorgt ihn eher das Szenario einer Invasion der künstlichen Dummheit, die die Netze durchflutet. Und als Experte für die Arbeit von Computerpionier Konrad Zuse fügt Rojas noch mit einem Augenzwinkern hinzu: "Konrad Zuse hat einmal gesagt: Wird der Computer zu schlau, dann braucht man nur den Stecker rauszuziehen."

Den Stecker rausziehen oder ein Notaus-Knopf für Künstliche Intelligenzen – ganz so einfach sei das dann doch nicht, sagt Nick Bostrom. Auf solche Strategien solle man sich besser nicht verlassen, wenn man Superintelligenzen kontrollieren will, warnt er: "Eine Superintelligenz kann deine Handlungen antizipieren. Strategien entwickeln. Planen. Sie könnte Menschen überzeugen, sie nicht abzuschalten oder sich direkt Kontrolle zum Stromnetz verschaffen. Sie könnte sich auf andere Hardware kopieren oder vortäuschen, weniger fähig zu sein, als sie tatsächlich ist – um bei den Menschen, die diesen Knopf kontrollieren, keine Ängste auszulösen. Das ist nicht wie ein kaputter Fernseher, den man einfach ausschaltet und dann steht er in der Ecke und wartet, was wir als nächstes mit ihm tun. Sondern ein potenziell sehr intelligenter Gegner."

Bostrom denkt darüber nach, wie man Künstlichen Intelligenzen menschliche Werte und Ethik vermitteln kann. Er glaubt: am Vielversprechendsten wäre es, sie diese über das Beobachten der Menschheit lernen zu lassen – statt ihr einen fixen Regelsatz einzuimpfen. Doch derartige Überlegungen stehen noch ganz am Anfang – ist doch noch völlig unklar, wie eine solche Technologie jemals aussehen würde: "Generell denke ich: Statt eine grundlegend feindliche KI in die Welt zu setzen und dann zu versuchen, ihre Fähigkeiten zu beschneiden, indem man sie einsperrt, sollten wir lieber versuchen, eine Künstliche INtelligenz zu schaffen, die von Anfang an auf unserer Seite steht. Die die gleichen Dinge will wie wir. Die Idee eines bösen Geistes, den man für immer in einer Flasche einsperrt, das erscheint mir wenig vielversprechend."

Klaus Mainzer treiben ganz andere Bedenken um, wenn er über die Zukunft nachdenkt, in der intelligente Funktionen von Maschinen perfektioniert werden. Die Vorstellungen, dass Künstliche Intelligenzen ein Bewusstsein haben müssten, um Menschen überflügeln zu können, hält er unter Umständen er für eine falsche Beruhigungspille: "Die Superintelligenz bedeutet nicht, dass die starke KI irgendwann realisiert wird, dass da vielleicht irgendwann Wesen mit Bewusstsein arbeiten. Sondern dass wir auf der Linie, die jetzt schon beschritten ist, Systeme haben, die Grade von Intelligenz haben, Nur so gesteigert, in diesem Internet der Dinge, also einer globalen Vernetzung, dass sie Menschen manipulieren können."

Auch Yvonne Hofstetters Befürchtungen gehen eher in diese Richtung. Sie hält nicht Künstliche Intelligenzen, die uns attackieren, für die größte Gefahr – sondern eine Art kybernetische Steuerung in nicht allzu ferner Zukunft:

"Wir möchten aus diesen Daten auf Verhalten schließen können. Wir möchten Verhalten vorhersehen können. Wenn die KI das können, dann können sie auch in unsere Souveränität eingreifen, in unser Leben eingreifen und gewisse Steuerungssignale an uns absetzen und dann eben weiterhin beobachten, wie wir uns verhalten und nachregeln."

Alpha Go ist auf diesem Weg allenfalls eine Zwischenstufe – bemerkt ausgerechnet der, der eigentlich von der ganzen Geschichte am Ärgsten gekränkt sein sollte: der Go-Weltmeister Lee Sedol. Der nämlich sagte nach dem verlorenen Duell:

"AlphaGo hat auch Schwächen gezeigt. Deshalb bezweifle ich, dass seine Fähigkeiten schon eine Botschaft an uns Menschen beinhalten. Ich denke, Lee Sedol hat heute verloren, nicht die Menschheit."