Wer ist verantwortlich, wenn künstliche Intelligenz versagt?

Selbststeuernde Autos nehmen am Straßenverkehr teil, Pflegeroboter werden für den Einsatz in Pflegestationen getestet und das Militär forscht mit Hochdruck an Kampfrobotern. Künstliche Intelligenz wird unser Leben verändern. Doch was ist, wenn sie versagt?

"Erstes Robotergesetz: Ein Roboter darf einen Menschen nicht verletzen oder zulassen, dass ein Mensch geschädigt wird."

Eric Hilgendorf: "Ja das sind die Asimovschen Gesetze, die allerdings aus juristischer Sicht ziemlich naiv sind."

"Ein Roboter muss Anweisungen von Menschen folgen, es sei denn, sie stehen in Konflikt mit dem Ersten Gesetz."

Oliver Bendel: "Die Maschinen, die wir jetzt konstruieren sind freigelassen. Sie bewegen sich selbstständig, sie bewegen sich durch künstliche und natürliche Welten."

"Ein Roboter muss sich selbst schützen, solange er dadurch nicht mit dem Ersten oder Zweiten Gesetz in Konflikt kommt."

Miklos Kiss: "Es muss ein Mensch entscheiden, nur: Bisher ist es der Mensch in der Notsituation, der entscheidet, das muss nicht die beste aller Entscheidungen sein und jetzt ist es ein Mensch der weit weg von allem ist, der das aber pauschal für alle entscheiden wird. Und irgendjemand wird den Algorithmus machen."

"HellomynameisCare-O-Bot.IamamobileServiceRobotfromFraunhoferIPA. I am at your command."

Der Care-O-Bot begrüßt mich im Fraunhofer-Institut für Produktionstechnik und Automatisierung in Stuttgart. Er wohnt hier, im dritten Stock. Ein eleganter Typ in weiß. Brusthoch eher eine geschwungene Säule als ein kantiger Terminator. Drei Kugelrollen an der Basis, die Kopfsektion ist abgeflacht. Das Gesicht - eine dunkle Scheibe. Darauf zwei Augensymbole. Wenn er etwas nicht weiß oder versteht, schaut er traurig. Er fährt durch eine Wohnküche - damit er lernen kann, wie man sich unter Menschen bewegt. Projektleiter Ulrich Reiser hat viel mit ihm vor.

"Wir sind seit 1995 dabei, bei uns die Care-O-Bot-Reihe zu entwickeln. Das sind eben Serviceroboter, die uns irgendwann zu Hause unterstützen sollen und uns ermöglichen sollen, länger zu Hause zu leben, bevor wir dann ins Pflegeheim müssen und da geht es wirklich darum, alles von physikalischen Assistenzfunktionen, bis zu mentaler Assistenz zu bieten, dass man sich zum Beispiel nicht alleine fühlt."

Das Vorgängermodell hat Reiser in einem Pflegeheim erprobt, da hat es die Patienten zum Beispiel daran erinnert, dass sie auch mal wieder was trinken sollen, der Roboter hat niemanden vergessen. Die Leute dort haben ihn gemocht, meint Reiser. Studien zeigen, dass selbst Ältere die Roboter akzeptieren, wenn sie dadurch weniger abhängig von menschlichen Pflegern werden. Aber höflich und zurückhaltend müssen die Automaten schon sein. Darauf ist der Care-O-Bot ausgelegt. Voller Sensoren, damit er alles im Blick hat und nie aneckt. Der Neue wird Gefühle erkennen und entsprechend einfühlsam reagieren können. Seine Servomotoren im Bauch erlauben ihm einen steifen Diener.

"Eine Anwendung ist zum Beispiel, die Assistenz in einem Markt, also dass er Kunden zu verschiedenen Produkten, Artikeln führt. Hier können wir die Stärken von Care-O-Bot 4 super ausspielen. Dieses sympathische Äußere und die Fähigkeit, sich in größeren Umgebungen zurechtzufinden und hier haben wir jetzt ein Pilotprojekt mit einem Kunden wo der Roboter sechs Monate den verschiedenen Kunden assistieren soll."

Der Care-O-Bot fährt eine enge Schleife um ein Tischchen. Bald wird er zwischen CD-Ständern und Regalen mit Kaffeeautomaten herumkurven, mich oder Sie ansprechen und genau wissen, was wo in den Regalen steht, - wenn nötig, auch in allen anderen Regalen der Kette. Vielleicht erkennt er in seinen Datenbanken auch mein Gesicht und weiß sowieso schon, was ich will. Auf jeden Fall nicht der Typ Fachverkäufer, der gestresst ist und meinem Blick ausweicht. Ein Laden ist perfekt für den Roboter. Alles ist stark genormt und vorhersehbar. Für den Einsatz zu Hause muss er noch lernen.

"Eines der kompliziertesten Szenarien ist ein Kinderzimmer. Sie stellen sich vor, ein Spielzeug unterschiedlicher Größe, die sind auch vielleicht noch verhakt ineinander und da jetzt einmal herauszufinden, wo man anfängt, wo das Ganze hingehört, das ist definitiv eine Herausforderung. Das machen ja auch die Kinder nicht gerne."

"Emergency Stop Button Pressed."

Roboter befreien sich aus der Isolation

"Ich glaube, dass die Fortschritte der Computertechnologie die Robotik entscheidend vorantreiben. Wir machen jetzt Sachen, die wir vor fünf Jahren nicht in Ansätzen geschafft haben. Wir machen jetzt viel komplexere Sache. Es fällt noch schwer, das alles in Echtzeit umzusetzen, aber da kommen die Rechner in der Cloud ins Spiel. Die Roboter nutzen das, und müssen nicht mehr die ganze Rechenkapazität an Bord haben."

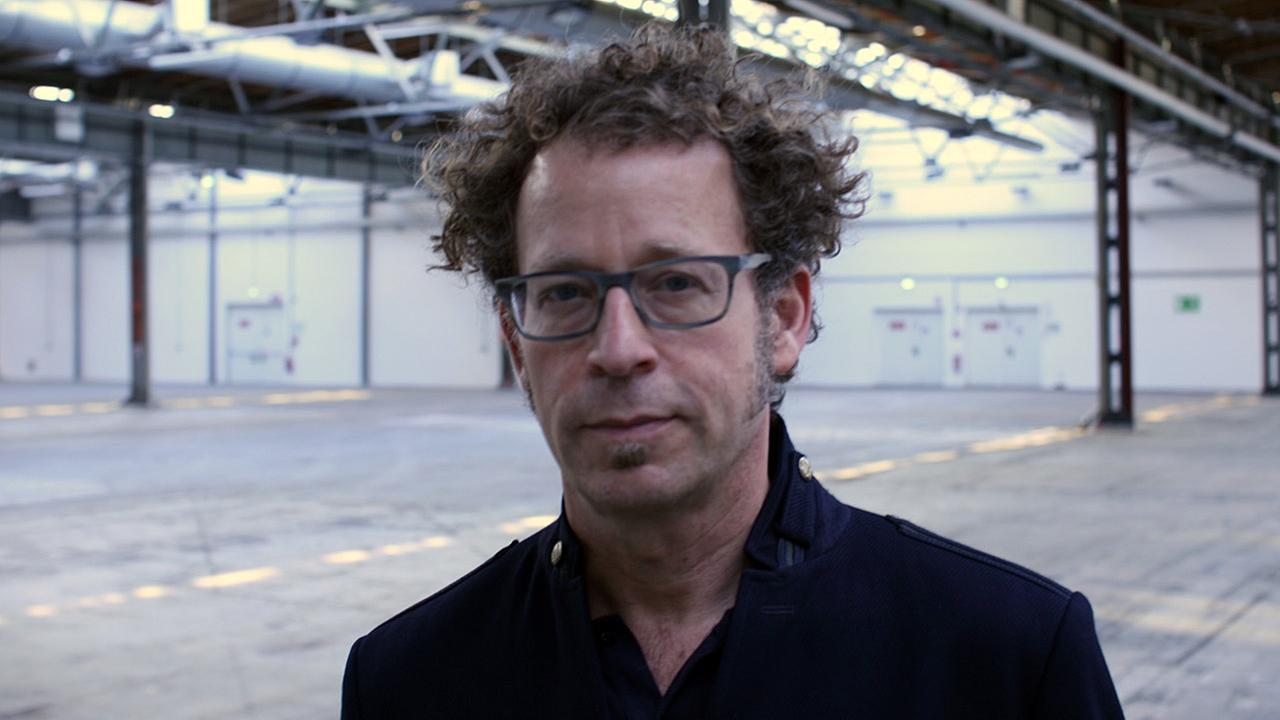

Ken Goldberg von der University of California in Berkley Kalifornien ist einer der renommiertesten Robotik-Wissenschaftler weltweit. Er spricht von der Revolution, die auf seinem Arbeitsgebiet gegenwärtig stattfindet. Die Vernetzung von fast allem mit allem - Web 4.0 befreit auch die Roboter aus ihrer Isolation. Sie können nun direkt voneinander und von den Menschen lernen und auf unerhörte Rechnerkapazitäten zugreifen. Cloud Robotics nennt Goldberg das Konzept.

"Ich gehe davon aus, dass Roboter fähiger werden und wir sie in einer ganzen Reihe von Aufgaben wiederfinden, wie hoffentlich beim Reinigen, da sind sie bitter nötig und auch in Krankenhäusern und bei Älteren. Das wird immer problematischer, weil die Bevölkerung immer älter wird."

Kenneth Goldberg, Professor für Robotik an der University of Berkley.© Deutschlandradio / Heiner Kiesel

Die Roboter erleben ihren Höhenflug in einer Zeit, in der wir Menschen oft gar nicht mehr so richtig mitkommen. Unser globalisiertes vernetztes Leben ist voller Möglichkeiten und ziemlich komplex. Den Überblick behält die Maschine, sie sichtet, sortiert und schlägt uns Auswahlmöglichkeiten vor. Die Maschine lenkt, was der Mensch denkt. Dabei kennt sie uns - mit jeder Interaktion - ein bisschen besser. Und wir müssen uns eingestehen, dass die Maschine vieles besser kann als wir.

"Das ist ziemlich aufregend. Wir sind jetzt an einem Punkt, wo wir zunehmend abgelenkt sind von diversen Gerätschaften und da steht uns das System bei - zum Beispiel auf der Autobahn - und gibt uns Bescheid, wenn wir in Gefahr sind, und führt uns dann."

"Die Maschinen, die wir jetzt konstruieren sind freigelassen. Sie bewegen sich selbstständig, sie bewegen sich durch künstliche und natürliche Welten. Sie beobachten dann auch und dann kommen wir schon zu den selbstlernenden Maschinen, ziehen Schlüsse und konstruieren eigene Fälle. Selbst wenn man sehr kritisch ist und sagt, Maschinen können keine Subjekte der Moral sein, müssten wir auf jeden Fall bemerken, dass Maschinen auf jeden Fall Subjekte sind. Und wir teilen uns die Welt mit diesen Subjekten. Permanent!"

Oliver Bendel, ist Philosoph und Professor für Wirtschaftsinformatik an der Fachhochschule der Nordwestschweiz. Bei ihm spürt man die Neugier darauf, was da zwischen Menschen und Maschinen entsteht. Es ist schon mehr ein Miteinander. Am Arbeitsplatz müssen die Roboter aufpassen und ausweichen, um niemanden anzufahren oder mit den Greifern zu verletzen. Und wir Menschen tun gut daran, die Umgebung übersichtlich zu strukturieren, damit sich die Maschinen zurechtfinden.

Der Science-Fiction-Autor Isaac Asimov hatte für das Zusammenleben von Mensch und Maschine die Robotergesetze aufgestellt. Das Wohlergehen des Menschen und der Menschheit sollte für die Maschinen in den Geschichten die oberste Priorität sein. Der Clou an Asimovs Stories: Es geht fast immer schief.

"Sie brauchen übrigens auch Energie, das ist ein weiterer wichtiger Punkt. Das heißt, es spitzt sich in der modernen Gesellschaft immer alles mehr auf die Energiefrage zu. Dieser Streit um Ressourcen, [der sowieso schon seit Jahrzehnten tobt - und deswegen führen manche Staaten Kriege,] der wird sich zuspitzen, weil auch die Roboter viel Energie brauchen werden."

Wie lange das Miteinander von Menschen und Maschinen wohl noch gut geht? Werden wir bald von den Robotern bedroht? Hört sich krass an. Aber so weit sind die ja noch nicht entwickelt. Obwohl - der Physiker Stephen Hawking, auch Microsoft-Gründer Bill Gates warnen inzwischen vehement vor den Gefahren der künstlichen Intelligenz. Oder Tesla-Gründer Elon Musk:

"Mit der künstlichen Intelligenz beschwören wir den Teufel. Sie kennen die Geschichten, mit dem Pentagramm und so, wo man glaubt den Teufel unter Kontrolle zu haben. Aber das funktioniert dann eben nicht."

Maschinen entscheiden sich so, wie es ihnen einprogrammiert worden ist. Aber, durch die enge Vernetzung verschiedener Einheiten, können dabei viele verschiedene Algorithmen aufeinander einwirken. Das Resultat ist dann - nach menschlichem Ermessen - ziemlich rätselhaft. Algotrader heißen die Computer, die wiederholt Aktienkurse gecrasht haben. Niemand weiß genau wie. Lust auf etwas Grusel? Die Rüstungsindustrie feiert autonome Kampfmaschinen gerade als die dritte Revolution der Kriegsführung. So hat es beim Terminator ja auch angefangen!

"Ich glaube fast, es ist eine Urangst. Und wenn wir in die Antike zurückgehen und Ovid und Homer lesen, dann treffen wir auf ganz viele roboterartige Geschöpfe. Das ist total verrückt! Und es sind in der Regel. Ich glaube es ist eine Urangst und vermutlich hängt sie damit zusammen, - was ist wenn der Mensch ähnliche Dinge macht, die man Göttern zugestanden hat? Dann kann nur großes Übel entstehen."

"Nicht immer auf Gefahren konzentrieren"

"In Deutschland wird ja immer eher die Gefahr gesehen in allen Bereichen und da werbe ich eigentlich immer dafür, dass wir uns nicht immer auf die Gefahren konzentrieren, sondern dass wir uns vor allem auf die Chancen und die Erleichterungen konzentrieren, die damit verbunden sind für die Menschen. Und ich glaube Wirtschaft, Industrie, Internet 4.0, wird die Zukunft der Menschen in der ganzen Welt und damit auch in Deutschland grundlegend weiterentwickeln und verändern."

Joachim Pfeiffer ist wirtschaftspolitischer Sprecher der CDU/CSU-Bundestagsfraktion. In der Politik steckt die Diskussion über die Folgen der Automatisierung erst in den Anfängen. Es ist nicht leicht, mit der technischen Entwicklung Schritt zu halten. Datensicherheit, unberechtigte Zugriffe auf die Maschinen, Haftungsfragen - so vieles ist ungeklärt. Dabei geht es rasch voran. Jedes Jahr werden 170.000 neue Roboter in der Industrie aufgestellt, fast fünf Millionen neue kleine Helferlein in Privathaushalten - vom automatischen Staubsauger bis zum vollvernetzten Spielgefährten für die ganze Familie. In gut ausgestatteten Operationssälen schneiden und nähen Roboter präziser als jeder Mensch. Aber: Jede eilige Regulierung könnte die Entwicklung bremsen und dann machen andere die intelligenten Systeme. Der Unionspolitiker blickt lieber nach vorne:

"In der Tendenz, und nach allen Zahlen die mir Vorliegen, führt das im Straßenverkehr als auch im industriellen Bereich zu deutlichen Verbesserungen der Sicherheit gegenüber dem Status Quo, weil der Risikofaktor Mensch, ob uns das gefällt oder nicht in allen diesen Bereichen der größte und unberechenbarste Faktor ist. Und wenn es gelingen könnte, hier sukzessive dieses Risiko kleiner zu machen, einzuschränken oder gar ganz auszuschalten durch entsprechende automatisierte Systeme, dann ist es glaube ich eine gute Sache."

Markus Hofmann: "Ja genau, ich komme jetzt mal zu Ihnen rüber, ich bin nämlich ihr Sicherheitsfahrer. Als nächstes aktivieren wir das System indem wir einen Schalter umlegen. Das Fahrzeug schaltet sich automatisch aus und schaltet sich auch wieder automatisch ein. Und führt anschließend einen Selbsttest durch. Das ist die Vorbereitung für die pilotierte Fahrt. Dann müssen wir auch einmal bestätigen, dass das Fahrzeug auch wirklich im pilotierten Modus ist. Und das einzige was ich während der Fahrt mache ist, dass ich diesen Taster drücke. Gut, Sie sind bereit, dann los!"

Autor: "Ohh, die erste Kurve und die Hände sind nicht am Lenkrad. Wow! Jetzt geht es den Berg hoch, es geht direkt auf eine Felswand zu, aber es biegt noch ab und die Hände, die Füße sind auch nicht an den Pedalen dran. Das ist wirklich so schnell wie ich noch nie in meinem Leben gefahren bin. Auf die Landschaft möchte ich mich gar nicht konzentrieren. Das kommt alles so schnell auf einen zu. Direkt bis in den Seitenstreifen hinein wird die Piste ausgenutzt. Ich sehe hier in der Kurve, und die ist wirklich total steil, dass der Tacho so auf 120 ist, das beschleunigt dann wieder auf 140,160,180, 200. 100 Meter bis zur Kurve, die geht total steil rum und, ufff, und er ist wieder auf 50 herunten. Es beschleunigt, zwischen zwei Zäunen hindurch, dahinten ist eine Sandpiste und ich kann mir gar nicht vorstellen, dass man eben nicht darauf fährt bei dieser Geschwindigkeit. Ich weiß, es sind Riesenbremsscheiben da unten in diesem Fahrzeug drin. Ich habe gehört, dass diese Autos bei zig-Dutzend Testfahrten noch nie einen Fehler gemacht haben - aber da war ich nicht drin gesessen. Das härteste was ich gehört habe, ist, dass dieses Auto die Strecke auch im dichten Neben gefahren ist und da auch in genau der selben Geschwindigkeit und das bedeutet auch, dass dieses Auto in gewissen Maßen auch mehr kann als ein Mensch. Und da fahren wir auch wieder an der Box vorbei und das ist die zweite Runde."

Markus Hofmann: "4,5 Kilometer."

Autor: "4,5 Kilometer."

Thorsten Pachur, Wissenschaftler am Max-Planck-Institut für Bildungsforschung.© Deutschlandradio / Heiner Kiesel

"Bei einigen Entscheidungsprozessen ist es ja so, dass es darum geht, große Informationsmengen zu integrieren und da ist der menschliche Entscheider nicht unbedingt besonders gut darin und hier ist man gut beraten, solche Entscheidungsprozesse dem Computer und der Maschine zu überlassen."

Thorsten Pachur arbeitet am Max-Planck-Institut für Bildungsforschung in Berlin. Er beschäftigt sich damit, wann und wie gute Entscheidungen getroffen werden. Eigentlich sollte er, so die Hoffnung bei der Gesprächsanfrage, für die Ehrenrettung des menschlichen Entscheiders sorgen. Aber Pachurs Forschungen deuten in eine andere Richtung.

"Also in Stresssituation ist es so, dass Menschen zunächst versuchen, alle mentalen Prozesse, die bei der Entscheidung beteiligt sind erstmal schneller und effizienter abzurufen und durchzuführen. Wenn allerdings ein gewisses Stresslevel überstiegen ist, dann ist es so, dass wir versuchen auf qualitative andere Prozesse zurückzugreifen und dann verändert sich der Entscheidungsprozess auch wirklich. Dann ist es so, dass wir auf relativ einfache Entscheidungsregeln zurückgreifen, oder eben auf Routinen. Es gibt aber auch viele Routinen, die nicht besonders gut geeignet sind für die Situation und wo Stresssituationen dann zu schlechten Entscheidungen führen."

Zu hart auf die Bremse steigen, weil man vom Radioprogramm abgelenkt ist. Oder, auch so eine Stress-Routine: Wohnung aufräumen, statt an den Schreibtisch zu gehen. Wenn es um die konsequente Erledigung eines Auftrags geht, ist die Maschine einfach zäher. Und wenn man glaubt, ein kniffliges Problem lässt sich auch gut aus dem Bauch heraus lösen, dann: doppelt aufpassen! Soll man Menschen überhaupt noch trauen?

"Ne gute Intuition fällt nicht vom Himmel, sondern sie ist immer das Ergebnis eines langen Lernprozesses. Und aufgrund dieser Erfahrung, die der Mensch verinnerlicht hat, können diese intuitiven Prozesse aufsteigen und sich automatisieren und auf die können wir dann in gewissen Situationen zurückgreifen und gute Entscheidungen aus dem Bauch heraus treffen."

"Ich habe die letzten vier Jahre die Unfallforschung bei Audi geleitet und weiß deswegen sehr gut, dass es philosophisch dem Fahrer sehr wohl zugetraut wird, dass er diese Entscheidung bewusst treffen kann, dass er die in der Notfallsituation aber gar nicht treffen kann. Das heißt der Fahrer hat in sehr kurzer Zeit die Chance eine Entscheidung zu treffen, die er dann in der Regel auch nicht mehr korrigieren kann. Und da ist das System sicher im Vorteil. In erster Linie wird das System immer versuchen, möglichst viel Energie aus dem System herauszunehmen. Das heißt es wird versuchen auf der Straße zu bleiben und so hart zu bremsen, wie es kann. Und damit wird erstmal das Beste rauskommen."

Miklos Kiss ist Entwickler in der Fahrzeugindustrie. Ein Sektor in dem die Entwicklung von Assistenzsystemen und Robotik derzeit mit enormen Ressourcen vorangetrieben wird. Das Auto wird zu einer rollenden Datenerfassungs- und Rechnerplattform. Das funktioniert schon ganz gut. Über eine Million Kilometer sind die Fahrzeuge der Firma Google schon autonom gefahren, ohne nennenswerte Unfälle. Die aufmerksamen Vehikel halten, wenn ein Krankenwagen kommt, sind vorsichtig bei Radfahrern. Die nächsten Schritte: die Vernetzung mit einer intelligenten Infrastruktur, Erkennen der Absichten der anderen Verkehrsteilnehmer. Eine neue Zeit bricht an auf den Straßen. Ob es 2020 oder 2030 soweit ist - darüber gehen die Experten-Meinungen auseinander. Aber fast alle sind sich einig: Der Mensch wird zu seinem Besten das Steuer abgeben. Das Schöne:. Schon jetzt können die Programmierer in aller Ruhe überlegen, was die Maschine einer kritischen Situation entscheidet.

"Wir bewegen uns heute in einer Welt der deterministischen Systeme. Das heißt jede Entscheidung, die das System trifft ist heute durch einen Entwickler festgelegt und abgesegnet. An der Schwelle zu einem tief selbstlernenden System wird das wieder ganz anders ausschauen. Diese Frage ist für uns auch noch ganz wichtige für die Diskussion, wie gehen wir mit den lernenden Systemen um, wer gibt das frei, was solche Systeme irgendwann tun und: können wir Menschen noch komplett verstehen, was so ein System tut?"

"Aber es wird so etwas geben wie eine Verantwortungslücke. Die Fahrer fallen heraus aus der Verantwortung, die Fahrzeuge selber kann man nicht zur Verantwortung ziehen. Wir werden also im Strafrecht und im Ordnungswidrigkeitenrecht weniger Fälle haben, in denen wir die Verursacher der Schäden tatsächlich zur Verantwortung ziehen können."

Eric Hilgendorf lehrt Rechtstheorie und Internetrecht an der Universität Würzburg. Er leitet dort auch die interdisziplinäre Forschungsstelle für RobotRecht. In der Welt der Roboter sollte eigentlich alles reibungslos nach Plan ablaufen.

"Aber was ist, wenn auf der Straße ein Unfall stattgefunden hat, da liegen einige Personen auf der Straße, der Wagen kann nach rechts ausweichen, auf der rechten Straßenseite spaziert ein Fußgänger und das Ausweichen ist nur dann möglich, wenn der Fußgänger angefahren, oder sogar umgefahren wird. Das sind dann schwierige ethische Abwägungsfragen, die in der Tat noch nicht gelöst sind."

In einem Sekundenbruchteil muss das Auto das Richtige tun. Und wenn es keine gute Lösung gibt? Die Autos ohne Fahrer konfrontieren den Juristen mit Problemen, die die Philosophie seit 2.000 Jahren umtreiben.

"Die ursprüngliche Fallgestaltung ist ein Fall, den ein berühmter antiker Skeptiker, Karneades, entwickelt hat. Da treiben zwei Schiffbrüchige auf einer Planke, nach einem Schiffsunfall im Mittelmeer und die Planke zieht Wasser, es stellt sich heraus, das die Planke nur noch eine Person tragen kann. Und die Frage ist nun, darf A den B von der Planke stoßen um sein eigenes Leben zu retten - immer unter der Prämisse, dass, wenn beide auf der Planke bleiben, beide versterben."

Es geht um das Abwägen von Menschenleben, die Würde des Menschen. Ist sie vielleicht doch antastbar, wenn das Opfern eines Unschuldigen viele rettet. Bisher ist die Rechtsprechung da eindeutig. Leben dürfen nicht gegeneinander aufgerechnet werden. Egal wie schlimm es kommt: A darf B nicht von der Planke stoßen. Aber ist das noch zeitgemäß angesichts vorprogrammierter Unfälle?

Eric Hilgendorf, Professor für Internetrecht und Fachmann für Roboterrecht.© Deutschlandradio / Heiner Kiesel

"Wenn man jetzt sagt fünf Leben sind gleich ein Leben und ein Leben ist gleich fünf Leben, dann heißt das, alle diese Leben sind völlig gleich. Wenn alle diese Leben völlig gleich sind, dann wäre es denkbar, dass ein süddeutscher Autobauer auf die Idee kommt, südlich des Mains immer die geringste Zahl ums Leben kommen zu lassen und nördlich des Mains die höchstmögliche Anzahl töten zu lassen, das ist zumindest für Nichtbayern hochgradig kontraintuitiv. Deswegen glaube ich, dass man von dieser alten Grundregel abgehen muss und hier im Zusammenhang mit den autonomen Fahrzeugen doch zu so einer Art von Quantifizierung kommen muss, es ist eben moralisch besser, wenn nur einer stirbt, als dass fünf sterben. Meine Lösung wäre aber auch, zusätzlich zu sagen, die Tötung auch dieses einen bleibt rechtswidrig."

"Unwahrscheinlich schwierige Fragen"

"Ich möchte nicht als Politiker entscheiden, ich möchte festlegen, das Auto fährt nach rechts, weil da der Porsche steht, oder es fährt nach links, weil da der Kleinwagen steht und was ist mehr wert und was ist weniger wert und geht es darum wie viele Insassen drin sind oder geht es darum wie teuer der PKW ist, in den ich reinfahre, oder wonach geht’s? Geht's nach dem Lebensalter er Insassen, auch sowas wird irgendwann erkannt werden. Das sind unwahrscheinlich schwierige Fragen, vor denen ich auch ein bisschen Angst habe."

Der Bundestagsabgeordnete Lars Klingbeil ist in der SPD-Fraktion für Netzpolitik zuständig. Klingbeil hat wie viele seiner Kollegen mehr Fragen als Antworten, wenn es um unsere Zukunft mit den Robotern geht. Entscheidungen über Tod oder Leben möchte er ihnen auf keinen Fall überlassen. Eine von vielen Grundfragen.

"Aber natürlich greift der Roboter da auch zunehmend in die Lebensführung ein und das wird glaube ich auch zu einem großen Problem, dass wir über Algorithmen gesteuert sind, dass wir in einer Gesellschaft leben, wo wir zunehmend hingewiesen werden auf Sachen. Die Welt wird immer stärker verengt im Digitalen."

Sein Parlamentskollege Kai Gehring macht sich ebenfalls Sorgen über eine Gesellschaft im Korsett der Algorithmen. Der Grünen-Abgeordnete gehört dem Bundestagsausschuss für Technikfolgenabschätzung an.

"Also gerade wenn wir sehen, was Maschinen künftig vielleicht können, zusätzlich, dann stellt sich im Kern die Frage, wie wollen wir eigentlich künftig leben? Und wie wäre das Alltagsleben künftig eigentlich organisiert, wenn Maschinen dort einen immer größeren Raum einnehmen, oder Roboter uns eben entscheidende Dinge abnehmen und wir auch entscheidende Dinge an sie delegieren?"

Er fragt sich , welcher Platz dem Menschen in einer automatisierten Welt bleibt.

"Also ich sehe immer mehr das Risiko, wenn wir als Menschen immer mehr Entscheidungen auf Maschinen und Roboter verlagern würden, dass wir damit auch bestimmte Entscheidungskompetenzen verlieren könnten. Oder so etwas wie emotionale Intelligenz auch beim Menschen dann eine geringere Rolle spielen dürfte. Denn viele Entscheidungen haben nicht nur was mit dem klaren Verstand und dem Kopf zu tun, sondern auch mit dem Herzen, der Seele, mit Empathie, letztlich mit der Einzigartigkeit, die den Menschen ausmacht. In all seinen Gefühlslagen, in all seiner Unvollkommenheit und Komplexität."

"Wir können diese Roboter doch trainieren, damit sie gutmütig sind, dass sie machen, was wir von ihnen wollen. Ich meine, die werden doch viele Beispiele haben von Pflegern, die ihren Job richtig machen, die helfen und unterstützen und sie werden daraus lernen."

Robotik-Forscher Ken Goldberg begegnet den europäischen Sorgen mit kalifornischem Optimismus. Über die Schreckensszenarien von der aufsässigen künstlichen Intelligenz macht er Witze. Aber auch er fragt sich, nach welchen Prinzipien die kommenden Generationen von selbstlernenden Robotern konzipiert werden müssen, damit sie wirklich den Menschen, so wie sie eben sind, dienen.

"Ich glaube, Asimov war seiner Zeit weit voraus. Der hat diese Prinzipien ganz gut herausgearbeitet. Zum Beispiel, dass kein Leid durch Tatenlosigkeit verursacht werden darf. Aber dann muss man natürlich fragen, was ist denn eigentlich Leid. Wenn der Roboter findet, dass es ungesund ist, wenn Sie ihr Gemüse nicht essen, und damit nervt, dann werden sie ihn wahrscheinlich rausschmeißen. Es ist viel komplizierter und die Details sind tückisch."

Vielleicht kann ich ihn aber gar nicht rausschmeißen, weil ich alt und schwach im Altenheim sitze. Aber: Selbst Schuld: Auch wenn der Roboter keinen Fehler macht, kann es sein, dass das Ergebnis falsch ist. Dafür kann die Maschine nichts. Ein Mensch hat eine Entscheidung getroffen. Und darin ist er ja nicht besonders gut.

"Es ist ganz natürlich, dass wir uns immer stärker auf diese Maschinen verlassen und vertrauen ihnen genauso wie uns selbst. Das ist eine Gefahr! Wir hören dann auf, Verantwortung zu übernehmen für unser eigenes Handeln. Irgendwie glauben die Leute aber auch, dass sie das wollen. Zum Beispiel, dass ein Roboter sich um sie kümmert. Da mache ich keine Ausnahme. Aber gleichzeitig möchte ich meine Fähigkeit, Entscheidungen zu treffen, oder etwas anzustoßen, nicht verlieren. Das wäre doch noch schlimmer, als wenn die Roboter die Macht übernehmen würden."