Wischen war gestern

Vor zehn Jahren kam das erste iPhone auf den Markt und hat unser Leben gründlich verändert. Doch die großen Technologie-Unternehmen arbeiten schon an einer Zukunft ohne Wischen und Tippen. Gesten sollen reichen − oder ein Lächeln.

Für Google, Apple oder IBM ist die Zeit nach dem Smartphone schon in Sicht. Zumindest vage. Klar scheint bereits: Viele Funktionen, die jetzt noch übers Telefon laufen, werden in andere Alltagsgegenstände ausgelagert. Bei Google kümmert sich darum die Arbeitsgruppe ATAP, in ihrem Projekt "Soli" zum Beispiel. Soli ist ein Radar-Sensor, der die Größe eines Mikrochips hat.

Niels Held: "Den können Sie überall verbauen. In 'nem Lenkrad von 'nem Auto oder auch in einem aktuellen Smartphone. Und dieser Chip kann winzige Veränderungen in seiner Umgebung erkennen. Und kann so ermöglichen zum Beispiel, dass wir per Gesten in der Hand das Radio im Auto leiser stellen. Eine kleine Fingerbewegung machen, einmal übern Daumen streichen und dann machen wir die Lautstärke von unserem Headset lauter, um die Musik aufzudrehen."

… erklärt der Technikjournalist Niels Held von der Zeitschrift "Chip".

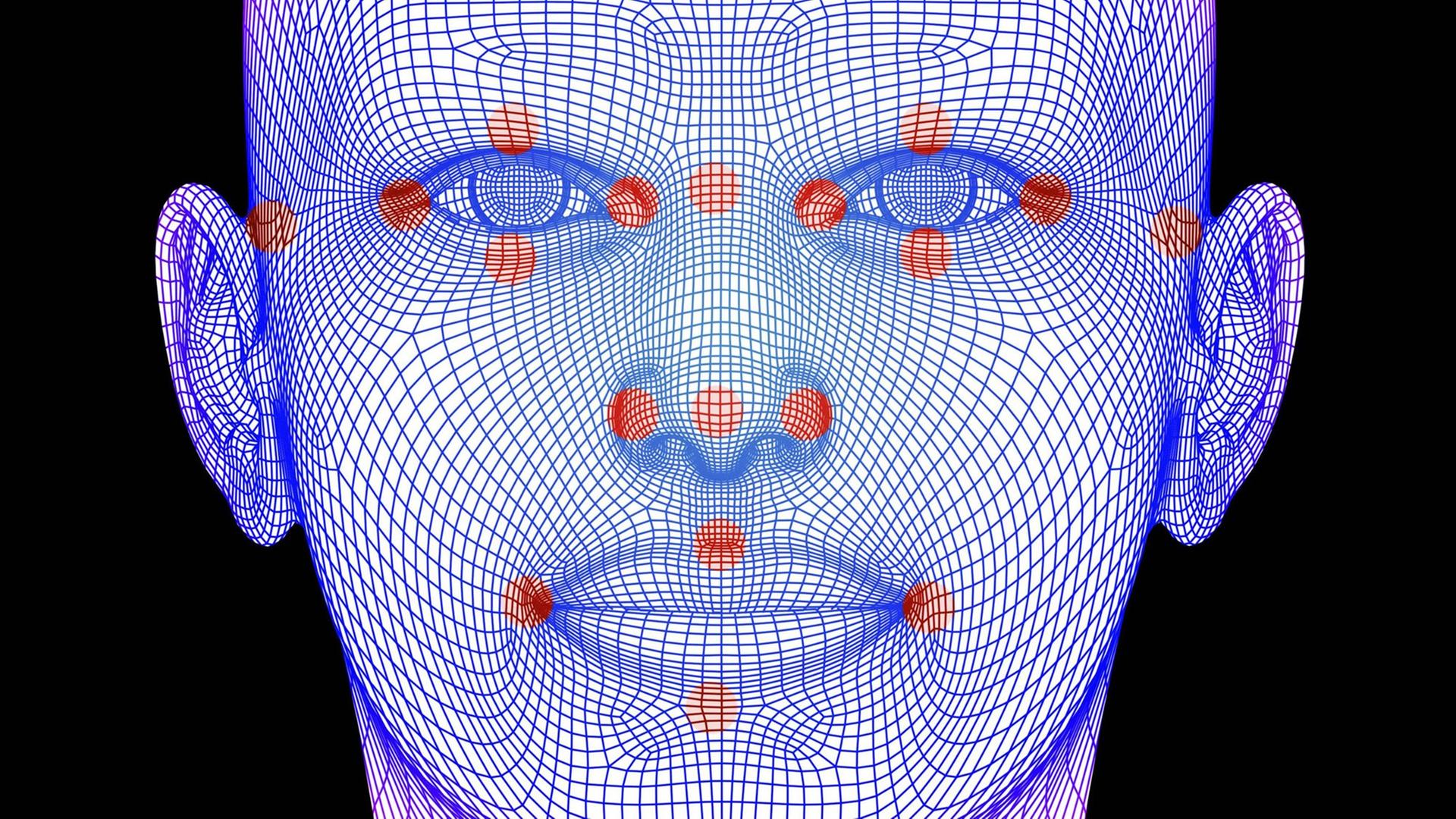

Das Zauberwort heißt: Biometrie. Vorbei die Zeiten, dass man eine Tastatur bedient oder mit dem Finger über den Bildschirm wischt. Bald erkennt die Maschine von selbst, was der Nutzer will – allein über die Signale, die der Körper aussendet. So zumindest die Vision der Techniker.

Beim Gestikulieren werden die Hände lahm

Stefan Ullrich, Sprecher der Fachgruppe "Informatik und Ethik" der Gesellschaft für Informatik hat seine Zweifel, dass der Mensch die Steuerung über Gesten auf Dauer wirklich durchhalten kann.

"Sie werden sich vielleicht noch an diesen Film von 2002 erinnern, 'Minority Report' von Steven Spielberg, wo der Protagonist mit den Händen in der Luft und mit Gesten arbeitet. Und dann haben ein paar Hacker das mal nachgebaut, weil sie das so fantastisch fanden. Und haben gemerkt, dass sie nach anderthalb Minuten richtig lahme Hände hatten. Insofern: Diese Gestensteuerung sieht besser aus, als sie dann tatsächlich praktikabel ist."

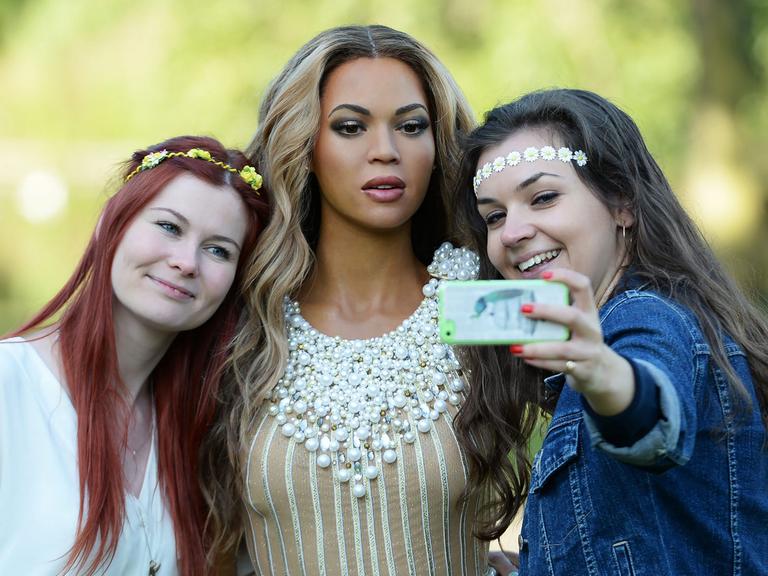

Doch wie Tom Cruise im "Minority Report" mit den Armen durch die Luft rudern und dabei im Internet recherchieren, ist nicht die einzige Idee der Techniker. Die Bezahlfunktion des Handys etwa soll in Zukunft das menschliche Gesicht übernehmen. Das testet Google zumindest derzeit in seinem Projekt "Hands free payments", wie Technikjournalist Niels Held erklärt.

"Da zahle ich mit einem Lächeln. Da erkennt mich ne kleine Kamera über ein hinterlegtes Bild und die wissen dann, das ist der Kunde, der ist kreditfähig, der kriegt jetzt sein Essen. Ich muss gar nichts mehr machen. Kein Portemonnaie mehr aus der Tasche holen, mich auch gar nicht weiter identifizieren. Das läuft einfach alles über die Kamera."

Das Ziel der Forscher: Die Bedienung von Technik soll ergonomischer werden. Die Hände wollen sie frei machen für andere Tätigkeiten.

Gesichtserkennung zu fehlerhaft

Der Informatiker Stefan Ullrich hält diese Ideen für Quatsch. Gerade die Gesichtserkennung sei völlig ungeeignet, um eine Person einwandfrei zu identifizieren. Die Fehlerraten seien einfach zu hoch.

"Selbst wenn angegeben wird, das ist zu 98% genau – rechnen Sie das mal hoch auf die Population. Was ist denn mit den 2%, wo es nicht so genau ist? Und das sind ja nur die Zahlen der Hersteller. Die sind unter idealen Bedingungen entstanden. Die gesamte Biometrie hat eine Fehlentwicklung genommen dahingehend, dass man ihr eine Eindeutigkeit zuschreibt, die sie einfach nicht hat."

Vor allem beim Bezahlen könnten solche technischen Ungenauigkeiten fatale Folgen haben, meint Ullrich.

"In Wirklichkeit ist es eine Zuschreibung. Er sagt ja nicht, Sie sind es und Sie sagen nicht, ich bin es, sondern der Computer oder das System oder der Entwickler, der das programmiert hat, weist Ihnen eine Rolle zu. Ich habe jetzt Sie als die und die Person identifiziert. Das müssen Sie ja unter Umständen gar nicht sein."

Abwandern aus dem Smartphone soll auch der Sprachassistent. Der künstliche Helfer wird in Zukunft noch wichtiger werden, glaubt Niels Held. IBM etwa arbeitet an der Weiterentwicklung seines Assistenten Watson. Der Technikjournalist ist überzeugt, dass auch Apple in diese Richtung forscht. Konzepte von früher deuteten jedenfalls darauf hin, wie ein Video aus den 80ern beweise.

"Da interagiert auch ein Nutzer mit seinem Assistenten, als wäre es ein Mensch aus Fleisch und Blut. Und das kann man sich als eine weit fortgeschrittene Version von SIRI vorstellen. Der weiß auch schon, was er heute für Termine hat und mit wem er sich noch trifft und kann mit ganz normaler Sprache gesteuert werden. Und vermutlich wird es auch darum gehen, diesen Assistenten in Systeme zu integrieren wie das Auto oder Fernseher."

Und werden wir in Zukunft wenigstens noch telefonieren mit dem Smartphone? Selbst damit könnte Schluss sein, wenn wir – wie es heute schon viele junge Leute tun – über Sprachapps kommunizieren, die dann auch ausgelagert sind.

Entwarnung vor schnellem Wandel

Stefan Ullrich von der Gesellschaft für Informatik gibt allerdings Entwarnung. So schnell vollziehe sich der Wandel dann doch nicht, wie die Erfahrung zeige.

"1947 kam der erste Transistor, also ein Bauelement auf den Markt. Und erst durch dieses Bauelement ist überhaupt eine Miniaturisierung möglich. Und Sie sehen, 70 Jahre. Also, nur weil jetzt eine Technologie da ist, heißt es nicht, dass wir sie in 10 Jahren setzen können. Es kann auch sein, dass es 50, 60, 70 Jahre braucht."

Oder dass es vielleicht auch ganz anders kommt.