Was die Stimme über uns verrät

Die Stimmanalyse wird für die Wissenschaft immer wichtiger: Moderne Verfahren können bei Personalentscheidungen helfen und für therapeutische Zwecke dienlich sein. Dabei greift die Forschung auch auf Youtube-Videos als Material zurück.

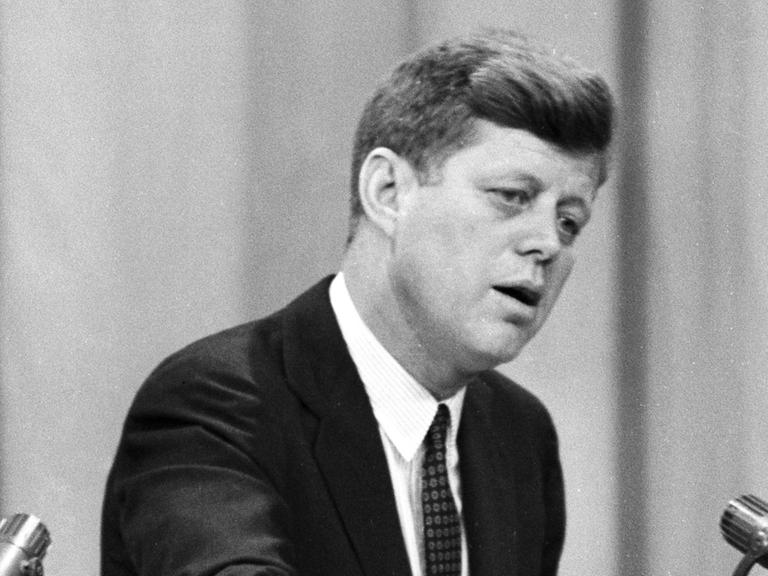

„Sprache ist Ausgangspunkt und Fluchtpunkt all dessen, was wir sind“, sagt der Psychologe Philipp Grochowski. „Das heißt, es drückt aus, wer wir sind, aber es beeinflusst natürlich auch die eigene Empfindung. Sprache ist nichts anderes als die Manifestation der Gedanken. Das ist unsere Persönlichkeit. Also wir sind, wie wir sprechen.“

Grochowski arbeitet bei „Precire“. Das Aachener Start Up hilft inzwischen mehr als 100 Kunden – Unternehmen, Versicherungen, Krankenkassen –, geeignete Mitarbeiter zu finden. Und zwar mithilfe von Stimmanalysen.

„Fachliche Eignung können wir nicht messen. Konkretes Auftreten können wir nicht messen. Wir beziehen uns da wirklich auf das, was in der Stimme und in der Sprache sich wirklich stabil und valide niederschlägt und ableitbar ist.“

Informationen in der Stimme

Philipp Grochowski und seine Kollegen haben eine Software entwickelt, die rund 50 Informationen aus der Stimme ableitet, gut die Hälfte davon spiegeln Kompetenzen und Eigenschaften einer Person wider. Unter anderem: Ist dieser Mensch eine forsche Persönlichkeit oder kann er sich auch zurücknehmen? Ist er neugierig oder eher schüchtern? Die Stimmdaten dafür liefern Telefoninterviews mit Probanden:

„Die Nummer rufen Sie an und unter Eingabe Ihres Pins startet dann unser standardisiertes Interview. Das heißt, dieses Interview ist von einer menschlichen Synchronstimme eingesprochen und stellt banale Fragen, beispielsweise ‚Wie läuft ein typischer Sonntag ab?‘“

Das Ziel: 15 Minuten freie Spontansprache gewinnen, die die Software dann auf bestimmte Kriterien hin untersucht: Viele Pausen etwa sind ein Zeichen von Unsicherheit, Emotionalität und Angespanntheit zeigt sich in einer weniger stabilen Stimme, die häufig auch höher ist. Extrovertierte sprechen zudem meist lauter und schneller, variieren die Satzmelodie stärker und betonen deutlicher als Introvertierte.

Die Stimme kann Traumata verraten

„Ich würde sagen, auf Gesprochenes achtet jeder“, sagt der Psychologe Charles Marmar vom Langone Medical Center der New York University. „Vor allem auch, wenn er sich mit geistiger Gesundheit beschäftigt. Es ist Teil der Befundaufnahme. Wir aber interessieren uns für die biophysikalischen Eigenschaften des Sprechens.“

Marmar interessiert sich für Stimm-Analysen. Seit über 40 Jahren arbeitet er als Psychologe vor allem mit Veteranen zusammen. Psychische Erkrankungen, sagt er, seien nicht sichtbar – ob seine Klienten nach einem Kriegseinsatz etwa an Posttraumatischen Belastungsstörungen litten, könne er selbst nach langjähriger Erfahrung nicht zweifelsfrei diagnostizieren.

„Sie geben vielleicht nicht all ihre Probleme preis. Aber ihr Blut oder auch ihr Kopfscann oder auch die Stimme könnten die wahre Geschichte erzählen. Deshalb wäre es für Ärzte hilfreich, objektive Tests zu haben. Vor allem wenn der Patient seine Beschwerden runtergespielt.“

Charles Marmar hat daher softwarebasierte Methoden zur Stimmanalyse entwickelt, die Diagnosen psychischer Erkrankungen unterstützen sollen. Wer an einer posttraumatischen Belastungsstörung leidet, so legt seine jüngste Studie nahe – dessen Stimme wird flacher und verliert an Schwung und Variation. Die von Marmar mitentwickelte Analyse-Software erkennt solche Merkmale und kann inzwischen mit fast 80-prozentiger Wahrscheinlichkeit das Vorliegen einer solchen Störung nachweisen.

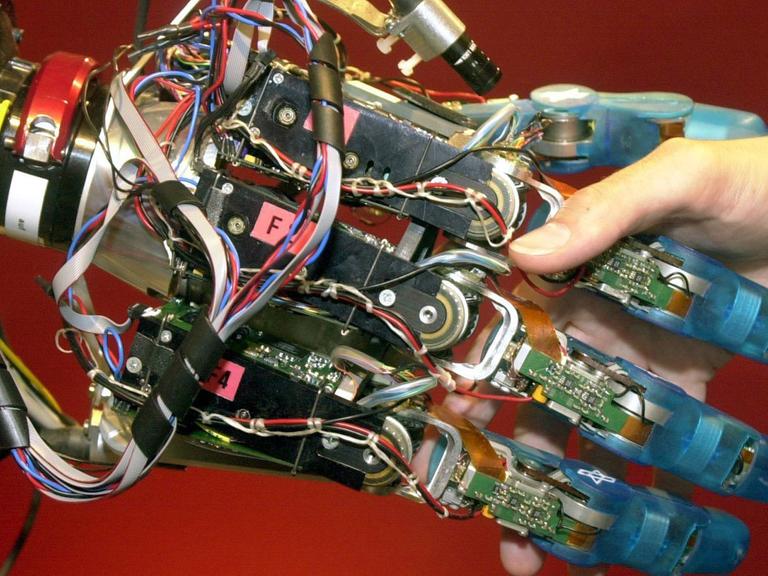

Wie künstliche Intelligenzen Emotionen erkennen

„Der Vorteil vom Computer ist natürlich, dass der viel länger und viel aufmerksamer zuhören kann, als ein Mensch das normalerweise tut und gleichzeitig die Daten von viel mehr Fällen hören kann, als es ein Mensch normalerweise kann“, sagt Björn Schuller. „Wenn wir den auf 500 Fälle trainieren, dann hat er vielleicht schon 400 mehr gehört, als der durchschnittliche Arzt.“

Schuller forscht und lehrt an den Universitäten Augsburg und Passau zum Thema „Affective Computing“ – eine relativ junge Disziplin, die untersucht, wie Maschinen und künstliche Intelligenzen menschliche Emotionen erkennen, abbilden und widergeben können. Er organisiert den Wettbewerb „Interspeech“, in dessen Rahmen Forscher untersuchen, wie Anzeichen für Kehlkopfkrebs oder Herzerkrankungen per Sprachanalyse zu ermitteln sind. Und: er hat selbst eine App entwickelt, die hilft, die Emotionen autistischer Kinder zu erkennen. Am interessantesten, sagt er, sei seine Arbeit jedoch für die Marktforschung.

„Alexa und Siri und wie sie noch alle heißen, die werden in Zukunft solche Informationen auswerten, mitnutzen, um die Kommunikation menschlicher zu gestalten. Das fängt natürlich damit an, dass sie Lachen, Schmunzeln, Zögern und solche Sachen mithört und auch miteinfügt, um einem das Gefühl zu vermitteln, dass sie mithört oder um Empathie zu zeigen. Aber auch, um die Interpretation besser machen zu können.“

Um zu verstehen, was ein Mensch fühlt und denkt, ist nicht mehr nur wichtig zu hören, was er sagt. Sondern auch, wie er es sagt. Auch die Analyse von Stimmdaten aus dem Internet wird daher zunehmend nachgefragt:

„Die großen Marken müssen, wenn sie das Meinungsbild gegenüber ihrer Marke verfolgen wollen, mehr und mehr auch auf die Stimmanalyse zurückgreifen, da mittlerweile eben auch sehr viel an Meinung in Videoschnipseln oder Audioschnipseln zum Beispiel verbreitet wird.“

Emotionen lassen sich stimmlich schwer verstellen

Dabei hat etwa die Auswertung von Youtube-Videos zwar den Vorteil, dass neben der Stimme auch Mimik und Gestik in die Analyse einbezogen werden können. Ein Lächeln allerdings kann man vortäuschen und Algorithmen tun sich noch immer schwer, das zu erkennen. Die Stimme glaubwürdig in Richtung einer bestimmten Emotion zu verstellen, ist weitaus schwieriger, die Stimmanalyse damit zuverlässiger – und das schon nach bereits einer Sekunde Aufnahme.

Zwar warnt Björn Schuller davor, die Aussagekraft von Stimmanalysen zu überschätzen: Auch wenn Computer bis zu 50 Interviews gleichzeitig analysieren könnten, sei die Bewertung der Ergebnisse von Menschen abhängig. Denn zur Einschätzung von Emotionen und Meinungen gehöre Kontextwissen über deren Entstehung und das haben Computer meist nicht. Dennoch könnten auf diese Weise schon jetzt Meinungsbildung verfolgt – und Minderheiten überwacht werden.

„..natürlich gibt es jetzt so Studie, die zum Beispiel in jüngerer Zeit Homosexualität automatisch erkennen wollten. Gewisse Regimes könnten sich das vielleicht, wo auch immer Homosexualität verboten ist, zunutze machen wollen. Da ist es eben wichtig, die Grenzen dessen, was überhaupt verlässlich möglich ist, mit aufzuzeigen.“