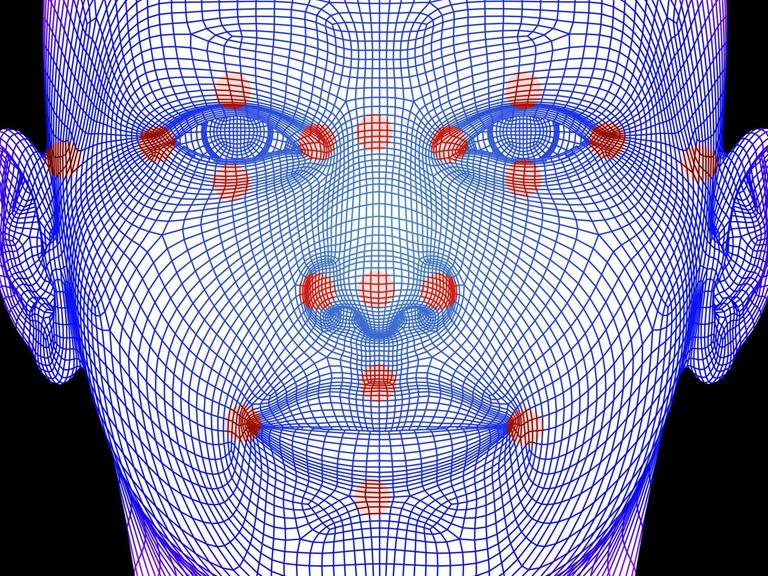

Wenn Maschinen die Gefühle lesen

Auch Maschinen sind inzwischen auf dem Weg, Emotionen erkennen zu können. Die Nachfrage nach so einer Technologie ist groß, sagt der Passauer Wissenschaftler Björn Schuller. Aber es stellen sich auch ethische Fragen.

Beim Einsatz von Maschinen zur Emotionserfassung gibt es erhebliche Fortschritte, sagt der Wissenschaftler Björn Schuller im Deutschlandfunk Kultur. Er arbeitet am Lehrstuhl für Complex and Intelligent Systems an der Universität Passau und betreibt eine eigene Firma hat, die Produkte anbietet, die schon mit den Anfängen von Emotionserkennung arbeiten. "Wir sind natürlich selber immer besorgt, dass wir den bestmöglichen Einsatz von solcher Technologie befördern", sagt Schuller. Aber die Technologie werde eben auch sinnvoll eingesetzt, zum Beispiel zur Unterstützung von autistischen oder depressiven Personen. "Da ist natürlich klar der Nutzen im Vordergrund."

Nachteile der neuen Technik

Bei anderen Anwendungen gebe es aber auch Gefahren. Schuller nannte die Möglichkeit, dass eine Maschine einen Gemütszustand immer besser erkenne und dieses ausgenutzt werden könne. Als Beispiel nannte er das Platzieren von Werbung, bei dem eine Maschine noch geschickter geeignete Momente ausnutzen könnte, um zum Kauf einer Ware zu animieren.

Das Interview im Wortlaut:

Liane von Billerbeck: Wir designen längst mehr als Stühle und Kleider, wir designen uns selbst und die Kommunikation und die ganze Welt. Designer – wir alle sind also letztlich Weltgestalter, so hieß es gestern zum Auftakt unserer Sommerreihe über neues Design, und heute soll es darum gehen, wie das Miteinander von Mensch und Maschine sich verändert und die Frage, was das eigentlich bedeutet, wenn auch Maschinen immer gefühliger werden, nicht nur beobachtend, sondern auch eingreifend in unser menschliches Leben und wie das unsere, die menschliche, Gesellschaft verändert.

Antworten erhoffe ich mir von Professor Björn Schuller vom Lehrstuhl für Complex and Intelligent Systems an der Universität Passau, der zudem auch eine eigene Firma hat, die Produkte anbietet, die schon mit den Anfängen von Emotionserkennung arbeiten. Schönen guten Morgen!

Björn Schuller: Schönen guten Morgen!

Billerbeck: Das klingt alles, was ich da eben gesagt habe, schon nach einer Menge ethischer Fragen, aber zuerst will ich natürlich wissen, wie bitte schön bringt man einer Maschine bei zu erkennen, was ein Mensch gerade fühlt?

Schuller: Wir machen es vor allem aus dem Audiosignal. Also wir hören uns ja gerade auch per Sprache und haben uns noch nicht gesehen. Ähnlich würde die Maschine dann das Sprachsignal analysieren und jede Menge Parameter daraus berechnen, um dann eine Entscheidung über die Emotion oder das Gefühl zu wählen. Das geht natürlich auch aus dem Videobild. Das kennt man vielleicht schon aus der Kamera, die das Lächeln automatisch erkennt, und das geht auch aus anderen Biosignalen. Man hat ja heutzutage an Smartwatches oder ähnlichem immer mehr auch Herzfrequenzmessung oder Hautleitfähigkeitsmessung. Aus all diesen Signalen werden also dann entsprechend Merkmale oder Parameter berechnet und dann die Gefühlslage erkannt.

Über die Stimme oder das Gesicht

Billerbeck: Das heißt, Sie brauchen immer mehrere Parameter. Sie könnten jetzt nicht, wenn Sie nur meine Stimme hören, die Maschine, genauer gesagt, könnte dann nicht erkennen, in welcher Stimmung ich bin.

Schuller: Das könnte sie schon, und das könnte sie so gut wie der Mensch das auch kann in etwa, und es geht aus der Stimme zum Beispiel besonders gut bezüglich des Erregungsgrades, nicht so gut bezüglich der Positivität, also wenn eine Emotion eher negativ oder positiv ist, aber eben sehr wohl, ob ich gerade erregt oder weniger erregt bin. Wenn man dann andere Modalitäten, wie wir das nennen, dazu nimmt, also zum Beispiel, was gesprochen wird, nicht nur wie es gesprochen wird, oder eben das Bild vom Gesicht, dann kann man das ergänzen.

Im Gesicht erkennt man eben gerade sehr gut diese Positivität, dafür ein bisschen weniger gut diesen Erregungszustand. Mit dem Hautleitwert oder der Herzfrequenz verhält es sich ähnlich. Da erkennt man die Erregung gut oder die Dominanz. Das heißt, das ergänzt sich alles ganz gut zum Gesamtbild, aber man kann auch aus einzelnen von diesen Größen schon recht viel herauslesen.

Billerbeck: Sie forschen ja einerseits an der Uni Passau an Anwendungen, die Menschen mit Krankheiten oder Einschränkungen helfen könnten, zum Beispiel Autisten, die mithilfe solcher Programme die Gefühle anderer Menschen besser einordnen könnten oder Menschen mit Depressionen, bei denen eine solche Software vielleicht warnen könnte, wenn der Gemütszustand gefährlich dunkel wird. Wie gut klappt sowas schon?

Schuller: Wir haben hier Tests durchgeführt, bei denen nicht nur wir die Tests gemacht haben, sondern auch die Wissenschaftsgemeinde einladen regelmäßig, eigentlich jährlich, und man kann sagen, auf einer Skala von etwa 64 Punkten haben wir eine Abweichung von fünf Punkten mit der automatischen Messung. Natürlich muss man das immer ein bisschen mit Vorsicht genießen, wie gut das dann verallgemeinert, aber das sind normalerweise Ergebnisse mit unbekannten Personen in halbwegs realen Bedingungen. Das heißt, wir sind optimistisch, dass man das schon tatsächlich allmählich auch einsetzen kann.

Die Kunden sind vielfältig

Billerbeck: Ich habe es erwähnt: Sie haben auch ein eigenes Unternehmen, das Programme, die Emotionen erkennen können, für Kunden aus der Wirtschaft anbietet. Da fragt man sich natürlich, was fragen Ihre Kunden denn da nach? Was möchten die haben?

Schuller: Die Kundenbreite ist da recht groß. Ein Hauptkunde ist der GFK-Verein, da geht es natürlich um Konsumforschung und die Automatisierung davon. Heutzutage füllt man vielleicht weniger gerne Fragebögen aus, sondern spricht vielleicht einfach über seine Erfahrung mit dem Produkt, dann kann man die gleich automatisch auswerten.

Andere Kunden kommen zum Beispiel aus der Automobilbranche. Da kann man sich vorstellen, dass vielleicht das Fahrzeug in der Zukunft reagiert entsprechend, wenn der Fahrer verschiedene Emotionszustände hat oder Gemütslagen, einerseits für die Sicherheit, andererseits vielleicht einfach für die Freude sozusagen an der Interaktion und die menschlichere Interaktion.

Dann gibt es auch Kunden im Bereich, die man vielleicht weniger erwartet: Zunächst haben wir da das Callcenter und den Automatisierungsgrad im Callcenter, der immer weiter steigt, und dort das Monitoring, ob die Anrufe gut laufen und die Kunden zufrieden sind, im Callcenter automatisch überwacht. Man hat dann auch andere Anwendungen eher im spielerischen Bereich, vielleicht dem tatsächlichen Videospielebereich oder gerade auch in der Unterhaltung. Stellen Sie sich vor zum Beispiel, Sie haben eine Kamera, die den ganzen Tag filmt, was Sie so machen, aber Sie wollen den ganzen Film -

Billerbeck: Schrecklich!

Schuller: – wieder anschauen, und automatisch werden schon die emotionalen Highlights gefunden und zusammengeschnitten. Dann hätten Sie nur noch vielleicht zehn Minuten von Ihrem Tag, aber eben die spannenden Momente.

Frage nach bestmöglichen Einsatz

Billerbeck: Sie merken, ich bin jetzt kurz stumm, weil da ploppen natürlich ganz viele ethische Fragen auf. Man stellt sich natürlich so vor, was wird das für eine Welt, die Sie da gerade ein Stückchen mit entworfen haben, bei dem, was es schon gibt. Das ist ja noch gar nicht das, was noch kommt.

Schuller: Ja, das ist richtig. Das ist auch eine Fragestellung, die uns sehr stark beschäftigt. Wir sind natürlich selber immer besorgt sozusagen, dass wir den bestmöglichen Einsatz von solcher Technologie befördern. Auf der einen Seite hatten Sie ja schon erwähnt, zum Beispiel im Bereich der Unterstützung von autistischen Individuen oder auch der potenziell depressiven Personen. Da ist natürlich klar der Nutzen im Vordergrund.

Bei anderen Anwendungen sehen wir natürlich auch gewisse Gefahren. Das wäre zum Beispiel im Bereich dessen, dass eine Maschine jetzt immer besser Ihren Gemütszustand kennt und den ja dann potenziell auch ausnutzen könnte, wenn man sich zum Beispiel das Platzieren von Werbung vorstellt, könnte man sich natürlich vorstellen, dass eine Maschine noch geschickter geeignete Momente ausnutzt, um Sie zu einem Kauf zu animieren, nachdem sie eben gerade mitbekommt, wie Ihre Emotion ist.

Billerbeck: Wie halten Sie es denn bei Ihrer eigenen Arbeit? Das ist ja immer die Frage an den Wissenschaftler, und nun sind Sie ja beides, Wissenschaftler und Entwickler. Gibt es Dinge, die Kunden von Ihnen wollen, wo Sie sagen, nee, mach ich nicht?

Schuller: Es gibt Dinge, wo wir auch nein sagen, und es gibt auch Sachen, die –

Billerbeck: Zum Beispiel?

Schuller: – wir vielleicht machen könnten, auch wenn Kunden danach nicht fragen würden, aber zum Beispiel kann man sich vorstellen, dass man in der Stimme gewisse Persönlichkeitsmerkmale finden könnte, die wir einfach so lieber nicht herauslesen möchten, weil wir finden, dass sie zu privat sind.

Der technologische Fortschritt

Billerbeck: Das heißt ja aber immer, am Ende ist es die Frage, wenn ich es nicht mache, macht es jemand anders. Sind wir überhaupt in der Lage, da noch Dinge nicht zu tun oder werden die alle passieren, und wir stehen dem hilflos gegenüber, was da alles an Informationen aus unserer Stimme, aus unseren Bildern, aus unseren Hautoberflächenspannung, aus unserem Herzschlag Maschinen erkennen können?

Schuller: Das ist natürlich immer eine spannende Frage in der Wissenschaft. Wenn wir es nicht tun, tun es dann andere, und für uns ist dann die Frage immer die, wollen wir dann nicht wenigstens lieber wissen, wie es geht, bevor wir zurückfallen und einfach zuschauen müssen, dass andere Technologien erwerben. Für uns ist das eine Frage, das ist natürlich genauso eine Frage für Genmanipulation oder andere Forschungsbereiche, die immer spannend bleibt.

Billerbeck: Antworten waren das von Professor Björn Schuller von der Universität Passau in unserer Sommerreihe über neues Design. Ich danke Ihnen!

Äußerungen unserer Gesprächspartner geben deren eigene Auffassungen wieder. Deutschlandfunk Kultur macht sich Äußerungen seiner Gesprächspartner in Interviews und Diskussionen nicht zu eigen.