"Ich verstehe Liebeskummer nicht"

08:23 Minuten

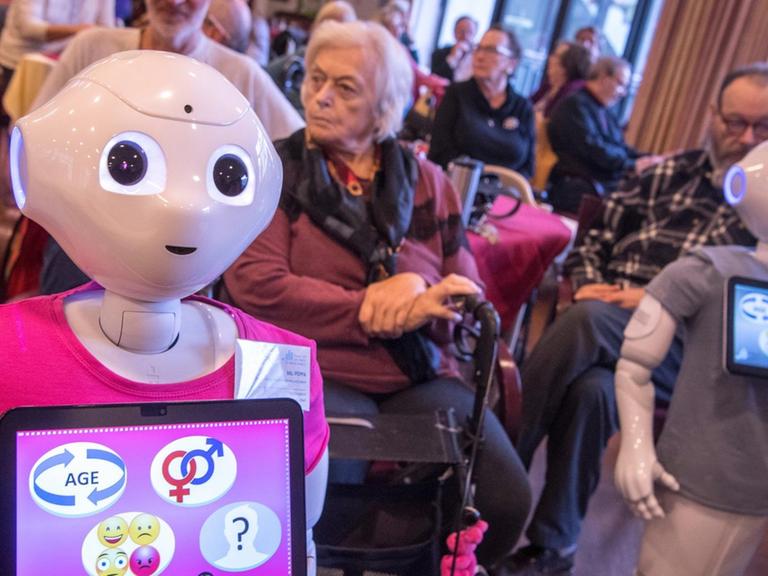

Je mehr smarte Sprachassistenten uns zuhören, umso besser erkennen sie sprachliche Muster und desto intelligenter wirken sie - mit teils verblüffenden Resultaten. Doch Ironie, Sarkasmus und emotionale Abstufungen bereiten ihnen nach wie vor Probleme.

"Samson, Tiffy, Harry, Hermine, Hera und Zeus: Wählen Sie bitte einen Namen aus. Tiffy, gute Wahl. Ihr Job ist einfach und Sie können damit Ihren Social Score aufbessern."

Als Tiffy kann ich jetzt selbst entscheiden, ob ich mich vom einem KI-Juristen belehren lassen möchte und ob ich Audioschnipsel, die mir vorgespielt werden, interessant oder langweilig finde.

"Was da entstanden ist, ist ein interaktives Hörspiel, basierend auf dem Sprachassistenzsystem Alexa. Da kann man selber eine Geschichte erleben und mitwirken und Entscheidungen treffen in einem Hörspiel, was einen also in eine leicht dystopische Welt der KIs also der Sprach-KIs bringt."

Florian Conrad von der Hochschule für Technik und Wirtschaft in Berlin hat das Hörspiel "Synthese" als sogenannten zusätzlichen Skill für den Sprachassistenten Alexa programmiert.

Die Maschine lernt ständig neu dazu

Sobald ihr Name fällt, leuchtet der zylinderförmige Lautsprecher auf und wartet auf eine Anweisung. Licht aus, Licht an, spiele Musik ab. Fast ein Drittel der erwachsenen Deutschen benutzen laut einer Studie der Postbank Sprachassistenten. Den Markt dominieren die vier großen Hersteller. Allen voran Amazon mit Alexa, danach folgen Apple, Google und Microsoft.

Je mehr die Nutzer dem Gerät sagen, desto besser wird deren Verständnis. Jeder aufgeschnappte Wortschnipsel wird in die Cloud hochgeladen und dort weiterverarbeitet. Für die Assistenten selbst ist all das Trainingsmaterial, die Datenbasis für das Machine Learning.

Unter den Begriff Machine Learning fallen verschiedene Verfahren, die es möglich machen, dass Maschinen aus Erfahrung lernen. Eine Unterform – das, was heute allgemein mit KI assoziiert wird – ist das sogenannte Deep Learning. Mit komplexen statistischen Methoden werden dabei gigantische Datenmengen ausgewertet - zum Beispiel Texte.

Die Maschine erkennt Muster: Welche Wörter und Sätze stehen in einem Zusammenhang oder wie ist eine Argumentation aufgebaut? Durch ständiges Training und wachsende Datenmengen wird sie dabei immer und immer besser.

"Die Überlegung oder der Grundansatz ist, glaube ich, zur Auseinandersetzung damit anzuregen, was KIs überhaupt so machen können, was die vielleicht auch untereinander machen können und wohin das führen kann.", sagt Florian Conrad über das Hörspiel.

Der Unterschied zwischen Text und Sinn

Wohin das führen kann, ist nicht nur eine Frage, die Datenschützer umtreibt. Science-Fiction-Visionen von Maschinen, die ein Bewusstsein oder eigenen Willen entwickeln, anfangen die Menschen zu kontrollieren, scheinen jetzt, da überall von künstlicher Intelligenz die Rede ist, gar nicht mehr so abwegig.

Im Praxistest glänzen Sprachassistenten wie Siri von Apple allerdings immer noch ziemlich häufig mit Begriffsstutzigkeit:

- "Siri, ich habe Liebeskummer."

- "Ich verstehe Liebeskummer nicht. Wenn du willst kann ich im Internet danach suchen."

- "Ich verstehe Liebeskummer nicht. Wenn du willst kann ich im Internet danach suchen."

Smart Speaker bilden grammatikalisch korrekte Sätze. Ihre Stimme klingt mehr oder weniger authentisch, sie erkennen menschliche Sprache und übersetzen sie in Text. Die größte Herausforderung besteht aber darin, aus diesem Text einen Sinn herauszulesen. Und das ist alles andere als trivial.

Selbst ohne Beteiligung von Maschinen zerbrechen sich Sprachwissenschaftler seit jeher den Kopf darüber, wie aus einer Aneinanderreihung von Wörtern ein Sinn entsteht, der je nach Kontext, nach gemeinsamem Erfahrungshorizont oder momentaner Stimmung ganz unterschiedlich sein kann.

Künstliche Intelligenz - "ein allgemeines Schlagwort"

Manfred Stede ist Professor für Computerlinguistik an der Universität Potsdam. Er meint, zwar würden sich kurze Unterhaltungen mit Sprachassistenten oft beeindruckend und menschenähnlich anfühlen, aber:

"Da muss man sich aber nicht drunter vorstellen, dass ich eine allumfassende Sprachintelligenz oder Wissensintelligenz habe, mit der ich über beliebige Sachen reden kann, sondern unter der Oberfläche liegen letzten Endes eine große Zahl von einzelnen Anwendungen, die spezialisiert sind, bestimmte Aufgaben zu erfüllen."

Heißt: Im Grunde ist da ein riesiger Werkzeugkoffer, in dem jedes einzelne Werkzeug aber nur genau den Zweck erfüllen kann, für den es gebaut wurde. Das Gerede von der künstlichen Intelligenz hält Stede für fehl am Platze:

"Wo fängt Intelligenz an - das wird heute leider gar nicht so richtig problematisiert und hinterfragt. Stattdessen ist es so ein allgemeines Schlagwort geworden. Mit dem man dann auch relativ schnell Menschenähnlichkeit assoziieren kann und das ist, glaube ich, nicht besonders hilfreich."

Beim Themenwechsel kapituliert die digitale Wetter-Talk-Expertin

Ein Schlagwort, das vor allem Aufmerksamkeit und Fördergelder generiert.

Was bisher als intelligent verstanden wird, ist, dass die Werkzeuge immerzu lernen. Eine Wetteranwendung zum Beispiel, die täglich mit neuen Beispielen gefüttert wird, wie Menschen nach dem Wetter fragen, leitet daraus Muster ab. Sie lernt, dass "Schüttet es morgen?" Oder "Brauche ich einen Regenschirm?" die selbe Antwort zum Ziel haben und wird so zur absoluten Wetter-Talk-Expertin.

Wechselt der Nutzer das Thema, muss der Sprachassistent eine andere Anwendung in die Spur schicken oder kapitulieren.

Telefonplausch mit Googles KI

Google hat im vergangenen Sommer auf seiner Entwicklerkonferenz den Assistenten Duplex vorgestellt. Der soll selbstständig mit echten Menschen telefonieren können, zum Beispiel, um einen Friseurtermin zu buchen. Einmal marktreif wäre das durchaus ein Schritt zu immer komplexeren Gesprächen.

Stolz ist Google auch darauf, dass man die Stimme des Assistenten am Telefon mit einem Menschen verwechseln kann. Die Technik dahinter ist eine immer ausgefeiltere Sprachsynthese.

Florian Conrad erklärt: "Das heißt, da werden aus ganz kleinen Bausteinen menschlicher Sprache, aus einzelnen Lauten Worte und Sätze gebildet. Und diese Laute werden so moduliert und zusammengesetzt, dass sie sich möglichst natürlich anhören."

Das habe auch bei Alexa und dem Hörspiel-Text bis auf einige Ausnahmen ziemlich gut funktioniert.

"Es gab tatsächlich Stellen, wo wir bei der Aussprache ein bisschen helfen mussten. Manchmal auch bei relativ gängigen Worten, die sich komisch angehört haben. Und dann kann man das natürlich immer korrigieren, indem man die Eingabe, die dahintersteht entweder sehr lautmalerisch schreibt oder in gewissem Maß kann man darauf auch Einfluss nehmen durch Zusatzvermerke, die man in diesen Text einbaut, die sagen, lass hier doch mal 'ne Pause oder betone das doch mal besonders."

Zwischen den Zeilen lesen - eine Herausforderung

Siri, Alexa und Co sind also ziemlich gut darin, Text vorzulesen und Sprache in Text umzuwandeln.

Was sie bisher nicht können, ist, zwischen den Zeilen zu lesen. Das weite Feld der Sprache jenseits von Wörtern verstehen sie nicht. Überraschung, Ärger, Irritation, Langeweile. Das alles lässt sich in menschlichen Gesprächen aus der Stimme herauslesen.

Start-Ups und große Player wie Huawei und Amazon arbeiten auf Hochtouren daran, Tonfälle und damit Emotionen auch für die Geräte erkennbar zu machen. Einige Anwendungen, die zum Beispiel Callcentern versprechen, wütende Kunden zu identifizieren, gibt es bereits. Aber Gefühlsausdrücke sind sehr indivuell und auch komplex. Nicht umsonst gelingt es auch manchen Menschen nicht, einen Witz oder Ironie als solche zu erkennen.

Bis dahin beschränken sich die Geräte darauf, selbst auswendig gelernte Witze zu erzählen:

"Wie nennt sich ein helles Mammut? Hellmut."