Apps für psychisch Kranke

08:00 Minuten

Wer sich ängstlich oder niedergeschlagen fühlt, der kann sich jetzt auch mit einer App unterhalten und sich helfen lassen. Studien haben gezeigt: Es funktioniert. Aber wie so häufig – auch hier gibt es Probleme mit der neuen Technologie.

Seit einigen Tagen habe ich einen elektronischen Begleiter auf meinem Smartphone. Er ist freundlich, aber auch ein bisschen unheimlich. Dazu später mehr. Zunächst möchte ich ihn vorstellen: Er heißt Woebot und chattet täglich auf Englisch mit mir.

"Was machst du gerade?" / "Ich bin auf der Arbeit" / "Wie geht es Dir?"

"Was machst du gerade?" / "Ich bin auf der Arbeit" / "Wie geht es Dir?"

Fragt Woebot als nächstes. Ich antworte, dass ich aufgeregt sei, schließlich musste ich ja diesen Radiobeitrag schreiben. Woebot legt los.

"Ich muss Dich was Wichtiges fragen, kann es sein, dass Dir die Aufregung in irgendeiner Weise hilft?"

Sind diese Apps bald Alltag?

Es beginnt eine Art Gespräch. Woebot möchte, dass ich meine Gefühle klar ausdrücke, gibt mir Tipps, mit ihnen umzugehen. Das System wurde von Experten für kognitive Verhaltenstherapie erdacht. Es ist derzeit eine von vielen Apps, die Menschen psychologische Unterstützung versprechen. Und bald könnten derartige Systeme Einzug in die medizinische Praxis halten. Das liegt nicht zuletzt an einem geplanten Gesetz zur Digitalisierung im Gesundheitswesen.

"Dieser Gesetzentwurf sieht ja vor, dass Gesundheits-Apps verschreibbar werden durch Ärzte, dass sie sozusagen aufgenommen werden in unserem Medizinsystem. Und so etwas wird eine stark beschleunigende Wirkung haben gerade auch im Bereich der psychischen Gesundheit. Die werden nämlich als ein – ich sag mal – Paradebeispiel in diesem Gesetzentwurf erwähnt."

Erklärt die Medizinethikerin Alena Byux von der Technischen Universität München. Die Apps sind heute noch eher außerhalb der klinischen Praxis aktiv. Therapie-Roboter wie die Kuschel-Robbe Paro für Demenzkranke oder der jungenhafte Milo für Kinder mit Autismus werden hingegen bereits für Therapien genutzt. Eine Studie mit 70 Probanden hat gezeigt: Woebot kann Aufregung oder Symptome von Depression lindern, eine Studie mit 75 Personen hat für die Therapie-App Tess ähnliche Ergebnisse geliefert. Vor allem wirken die Maschinen unterschwellig.

Erklärt die Medizinethikerin Alena Byux von der Technischen Universität München. Die Apps sind heute noch eher außerhalb der klinischen Praxis aktiv. Therapie-Roboter wie die Kuschel-Robbe Paro für Demenzkranke oder der jungenhafte Milo für Kinder mit Autismus werden hingegen bereits für Therapien genutzt. Eine Studie mit 70 Probanden hat gezeigt: Woebot kann Aufregung oder Symptome von Depression lindern, eine Studie mit 75 Personen hat für die Therapie-App Tess ähnliche Ergebnisse geliefert. Vor allem wirken die Maschinen unterschwellig.

"Es gibt erste Studien, die zeigen, dass Menschen offensichtlich bestimmte Dinge ehrlicher mit einem elektronischem Gegenüber ´besprechen` in Anführungszeichen. Weil ein Algorithmus nicht urteilt oder verurteilt. Das ist ein Potenzial. Man kann gegebenenfalls Menschen erreichen, die vielleicht gar nicht den Weg in eine therapeutische Beziehung finden würden."

Systeme bergen auch Gefahren

Die ganzen virtuellen Assistenten wie Alexa und Siri und Cortana dürften in den letzten Jahren dazu beigetragen haben, dass es normal geworden ist, auf Geräte einzureden. Alena Buyx hat die Therapie-Maschinen mit ihren Kolleginnen und Kollegen in einer Studie untersucht. Dabei hat sie nicht nur deren Vorteile systematisch offengelegt, sondern auch die ethischen und technischen Bedenken. Eine der ethischen Herausforderungen ergibt sich direkt aus der Niedrigschwelligkeit.

"Es gibt die Kehrseite davon. Es gibt auch schon erste Hinweise darauf, dass Menschen zu diesen Systemen echte emotionale und zum Teil sogar Abhängigkeits-Beziehungen entwickeln können."

Das ist der Knackpunkt, der den eigentlich sympathischen Woebot ein wenig unheimlich macht. Und es ist der Grund, warum viele beim Gedanken an Therapie-Maschinen ein Unbehagen verspüren:

"Wie soll denn der Therapeut, die Therapeutin als Person, die ja Teil des therapeutischen Geschehens ist... über Empathie und Übertragung und so weiter und so fort... Wie soll das jemals ersetzt werden können?! Das ist tatsächlich auch eine der größten Herausforderungen, dass man ganz klar auseinanderdividieren muss: Welche Elemente dürfen und können denn ersetzt werden und welche nicht?"

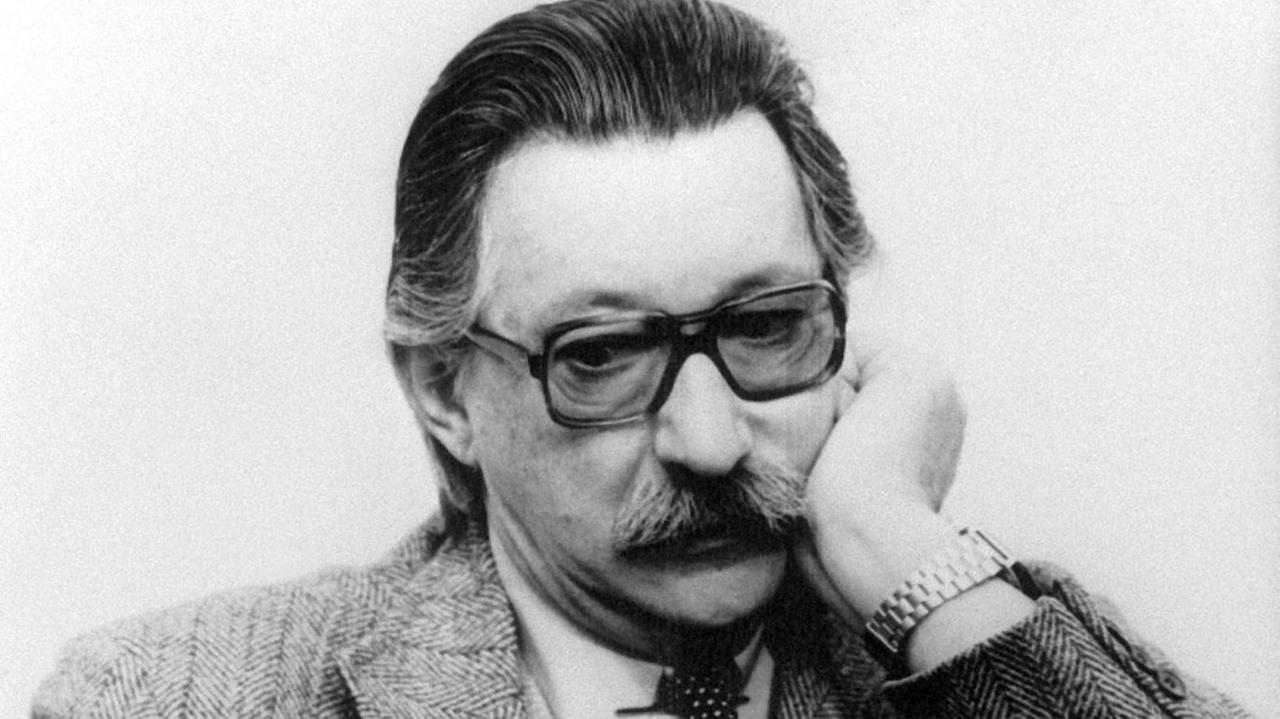

Diese Frage existiert schon seit den 1960ern. Damals entwickelte der Computerpionier Joseph Weizenbaum das erste rudimentäre Chatprogramm: Eliza. Weizenbaum programmierte sie so, dass sie einen Therapeuten imitierte. Jedoch nicht, um einen künstlichen Therapeuten zu erschaffen. Nein, Weizenbaum nutzte diesen Kniff lediglich, damit der Nutzer dem simplen Programm banale Fragen durchgehen lässt – Therapeuten fragen eben viel. Weizenbaum war überrascht darüber, wie viel Persönliches die Nutzer Eliza anvertrauten. Entsetzt war er über die Ideen mancher Psychologen, die Empathie-freie Eliza für Therapiezwecke einzusetzen. Aber das war vor über 50 Jahren. Heutige Therapie-Apps können viel mehr – womit neue ethische Herausforderungen einhergehen.

"Wer darf eigentlich die Daten, die gesammelt werden, von diesen verschiedenen Systemen, in welcher Art und Weise nutzen? Man muss natürlich die Frage stellen: Wie steht es um die Patientenautonomie? Wird jeweils dazu eingewilligt? Wie gehen wir damit um, wenn es Menschen sind, die nicht einwilligen können? Also Patienten mit Demenzerkrankungen."

Es sind auch Fragen zur Ausbildung von Ärzten: Wie sollen sie damit umgehen, dass ihre Patienten außerhalb der klinischen Praxis solche Systeme nutzen? Es gibt auch spezifische Fragen der psychischen Gesundheit:

"Können solche Systeme gebunden sein durch die gleichen ethischen Auflagen wie menschliche Therapeuten? Sie haben heutzutage die Verpflichtung, zu warnen oder dafür zu sorgen, dass bestimmte Patienten in eine Behandlung kommen, wenn sie etwa Suizidalität diagnostizieren oder Bedrohung für andere. Wie soll so etwas funktionieren, bei Systemen, die so etwas zwar diagnostizieren können (denn das geht schon), aber die in keiner Weise so eine Art Warn-Protokoll oder Überweisungs-Protokoll haben?"

Das ist der Knackpunkt, der den eigentlich sympathischen Woebot ein wenig unheimlich macht. Und es ist der Grund, warum viele beim Gedanken an Therapie-Maschinen ein Unbehagen verspüren:

"Wie soll denn der Therapeut, die Therapeutin als Person, die ja Teil des therapeutischen Geschehens ist... über Empathie und Übertragung und so weiter und so fort... Wie soll das jemals ersetzt werden können?! Das ist tatsächlich auch eine der größten Herausforderungen, dass man ganz klar auseinanderdividieren muss: Welche Elemente dürfen und können denn ersetzt werden und welche nicht?"

Diese Frage existiert schon seit den 1960ern. Damals entwickelte der Computerpionier Joseph Weizenbaum das erste rudimentäre Chatprogramm: Eliza. Weizenbaum programmierte sie so, dass sie einen Therapeuten imitierte. Jedoch nicht, um einen künstlichen Therapeuten zu erschaffen. Nein, Weizenbaum nutzte diesen Kniff lediglich, damit der Nutzer dem simplen Programm banale Fragen durchgehen lässt – Therapeuten fragen eben viel. Weizenbaum war überrascht darüber, wie viel Persönliches die Nutzer Eliza anvertrauten. Entsetzt war er über die Ideen mancher Psychologen, die Empathie-freie Eliza für Therapiezwecke einzusetzen. Aber das war vor über 50 Jahren. Heutige Therapie-Apps können viel mehr – womit neue ethische Herausforderungen einhergehen.

"Wer darf eigentlich die Daten, die gesammelt werden, von diesen verschiedenen Systemen, in welcher Art und Weise nutzen? Man muss natürlich die Frage stellen: Wie steht es um die Patientenautonomie? Wird jeweils dazu eingewilligt? Wie gehen wir damit um, wenn es Menschen sind, die nicht einwilligen können? Also Patienten mit Demenzerkrankungen."

Es sind auch Fragen zur Ausbildung von Ärzten: Wie sollen sie damit umgehen, dass ihre Patienten außerhalb der klinischen Praxis solche Systeme nutzen? Es gibt auch spezifische Fragen der psychischen Gesundheit:

"Können solche Systeme gebunden sein durch die gleichen ethischen Auflagen wie menschliche Therapeuten? Sie haben heutzutage die Verpflichtung, zu warnen oder dafür zu sorgen, dass bestimmte Patienten in eine Behandlung kommen, wenn sie etwa Suizidalität diagnostizieren oder Bedrohung für andere. Wie soll so etwas funktionieren, bei Systemen, die so etwas zwar diagnostizieren können (denn das geht schon), aber die in keiner Weise so eine Art Warn-Protokoll oder Überweisungs-Protokoll haben?"

Joseph Weizenbaum, deutscher Mathematiker und Kritiker der künstlichen Intelligenz, in einer undatierten Aufnahme. Er wurde durch sein 1966 vorgestelltes Programm ELIZA bekannt, das ein Therapeut-Patient-Gespräch simuliert.© picture alliance/dpa

Entscheidender Punkt, der beachtet werden muss

Ein für die künstliche Intelligenz typisches Problem ergibt sich, wenn wir uns eine Zukunft vorstellen, in der die Maschinen nur anhand der Daten von menschlichen Ärzten lernen: Was haben die diagnostiziert? Wie haben sie Therapien ausgewählt? In dieser Zukunft könnten die Systeme ungewollt etwas Falsches lernen. Die Folge wären maschinelle Vorurteile, so genannte Biases.

"Ein Problem wird es dann, wenn ein Algorithmus sozusagen lernt – ich sage es mal ganz platt: Bei jedem, der eine Suchterkrankung hat, muss Du X machen. Und das nicht, wie das hoffentlich im therapeutischen Gespräch jeweils eine ganz individuelle Entscheidung ist, sondern etwas ist, was aufgrund eines programmierten Bias entsteht. Aufgrund der in dieser Hinsicht verzerrten Trainingsdaten."

Alena Buyx empfiehlt, sich heute schon damit auseinanderzusetzen. Doch wie könnte eine Antwort aussehen?

"Ein Problem wird es dann, wenn ein Algorithmus sozusagen lernt – ich sage es mal ganz platt: Bei jedem, der eine Suchterkrankung hat, muss Du X machen. Und das nicht, wie das hoffentlich im therapeutischen Gespräch jeweils eine ganz individuelle Entscheidung ist, sondern etwas ist, was aufgrund eines programmierten Bias entsteht. Aufgrund der in dieser Hinsicht verzerrten Trainingsdaten."

Alena Buyx empfiehlt, sich heute schon damit auseinanderzusetzen. Doch wie könnte eine Antwort aussehen?

"Ich stelle mir ein integriertes Modell vor, wo wir im Rahmen einer ganz etablierten Therapeutin-Therapeuten-und-Patienten-Beziehung diese Systeme unterstützend nutzen. Wo die verschrieben werden zum mit nach Hause nehmen: ´Das kannste machen und melde dich beim nächsten Mal, wie Du damit zurecht gekommen bist.`"

Der entscheidende Punkt ist, dass der echte Therapeut mit seiner Empathie und Menschlichkeit Teil der Behandlung bleibt. Das Entsetzen des Chatbot-Erfinders Weizenbaum könnte man beim Gedanken an vollautomatische Therapeuten heute noch nachempfinden. Die technologischen Fortschritte der Maschinen ändern daran kaum etwas. Denn maschinelles Lernen oder automatisch aus Gesprächen angelegte Persönlichkeitsprofile – das hat Weizenbaum schon 1966 als mögliche Verbesserungen für Eliza vorhergesehen. Eine Maschine, die einen Therapeuten ersetzt, war für ihn dennoch undenkbar.

Der entscheidende Punkt ist, dass der echte Therapeut mit seiner Empathie und Menschlichkeit Teil der Behandlung bleibt. Das Entsetzen des Chatbot-Erfinders Weizenbaum könnte man beim Gedanken an vollautomatische Therapeuten heute noch nachempfinden. Die technologischen Fortschritte der Maschinen ändern daran kaum etwas. Denn maschinelles Lernen oder automatisch aus Gesprächen angelegte Persönlichkeitsprofile – das hat Weizenbaum schon 1966 als mögliche Verbesserungen für Eliza vorhergesehen. Eine Maschine, die einen Therapeuten ersetzt, war für ihn dennoch undenkbar.