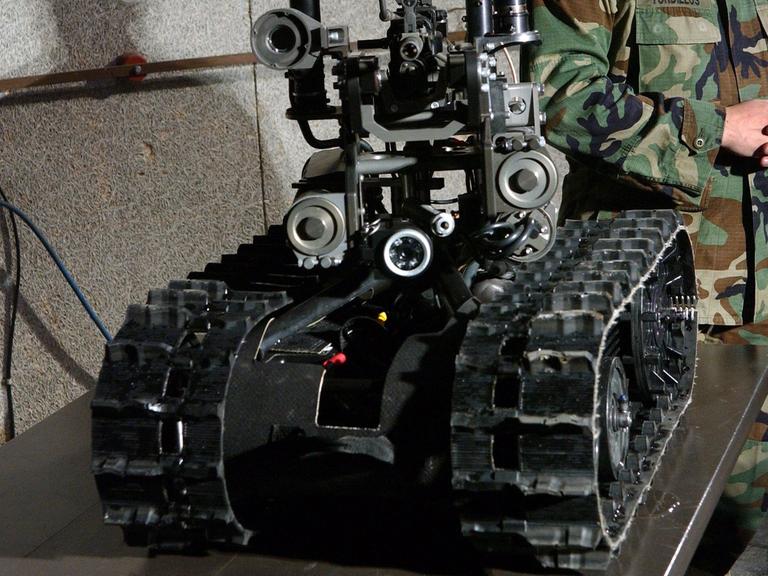

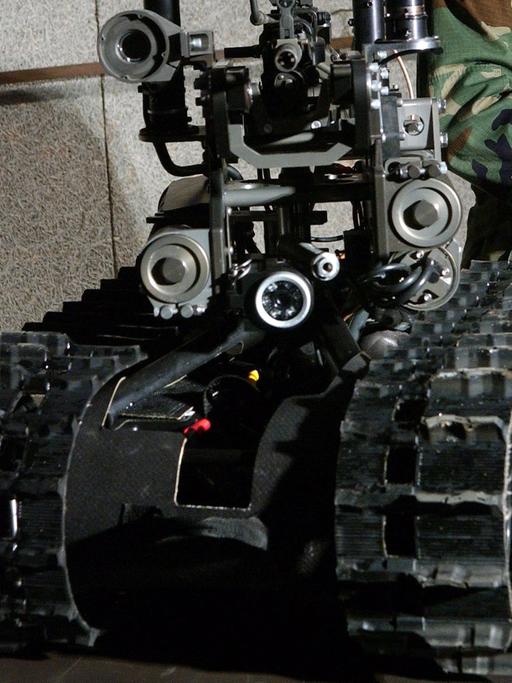

Kampfroboter kennen keine Empathie

Künstliche Intelligenz wird auch für militärische Zwecke benutzt. Gibt es in Zukunft bewaffnete Roboter, die selbst entscheiden, auf wen oder was sie zielen? Kritiker fordern ein Verbot solcher "tödlichen autonomen Waffensysteme" seitens der UN.

Seit 2014 stehen "tödliche autonome Waffensysteme" regelmäßig auf der Tagesordnung bei den Vereinten Nationen in Genf. Mehrfach haben sich Experten getroffen, dieses Jahr kommen Vertreter von Staaten hinzu. Doch immer noch ist nicht klar, was "tödliche autonome Waffensysteme" eigentlich genau sind.

"Man kann nichts verbieten, was man nicht definiert hat. Und darin liegt eigentlich der Schlüssel und das ist auch die sehr schwierige Diskussion, die wir vor uns haben."

Wolfgang Richter, Oberst a.D. und Experte für internationale Sicherheit bei der Stiftung Wissenschaft und Politik. Er weist darauf hin, dass Waffen schon heute eine gewisse Selbstständigkeit haben.

"Es ist ja nicht so, dass ein Pilot, der eine Waffe abfeuert, also sozusagen die die Waffe unmittelbar in Betrieb setzt. Das System ist mittlerweile so optimiert, dass man die Avionik, die Sensoren und die Waffen-Auslösung, auch die Position des Flugzeugs optimiert, und das machen mittlerweile autonome Rechner innerhalb der Maschine. Also wenn der Pilot auf den Knopf drückt, heißt das nicht, dass sofort diese Waffe ausgelöst wird, sondern das Gesamtsystem sucht sich den optimalen Zeitpunkt und die optimale Position."

Unklar, was überhaupt verboten werden soll

Der Schritt zu vollautonomen Waffen, bei denen niemand mehr einen Knopf drücken muss, scheint klein, die Abgrenzung daher schwierig. Was genau verboten werden soll, ist also eine komplizierte Frage. Viel komplizierter als bei dem Verbot von Landminen etwa.

Was eine Landmine ist, ist klar. Was ein tödliches autonomes Waffensystem ist, nicht so sehr. Das liegt auch daran, dass diese Systeme noch nicht existieren. Ein von Deutschland und Frankreich in Genf eingebrachtes Papier sagt deshalb auch, dass es zu früh sei, diese Systeme zu regulieren.

Ähnlich sieht das Brad Allenby von der Arizona State University. Nur seine Begründung ist eine andere.

"Diese Technik zu regulieren, bevor man überhaupt weiß, was die Technik genau ist, kann ein Fehler sein. Denn es könnte ja sein, dass wir Technik entwickeln können, die in stressigen Kampfsituationen besser als Menschen darin ist, das Kriegsvölkerrecht zu beachten."

Einige Wissenschaftler, die auf Allenbys Seite stehen, sagen, wenn der Einsatz von Künstlicher Intelligenz zu weniger zivilen Opfern führt, wenn intelligente Waffen überlegter handeln als Soldaten und dadurch weniger Leid verursachen, dann könnte ein Kommandant sogar dazu verpflichtet sein, sie einzusetzen.

"Manche Gegner von tödlichen autonomen Robotern gehen davon aus, dass ein Roboter nie so gut wie ein Mensch in einer Kampfsituation sein kann, wenn es darum geht, das Völkerrecht zu befolgen. Aber nach allem was wir darüber wissen, wie Menschen sich im Kampf verhalten, ist das sehr spekulativ. Menschen benehmen sich in diesem Umfeld nicht gut."

Ungeklärte Fragen

Dennoch bleibt die Frage ungeklärt, ob Maschinen wirklich eines Tages zuverlässig zwischen Zivilisten und Kombattanten unterscheiden können. Und ob es überhaupt möglich ist, komplizierte Regeln wie das Kriegsvölkerrecht in Computercode zu übersetzen. Aber selbst wenn die technischen Herausforderungen überwunden werden, warum sollte man überhaupt Kontrolle an Maschinen abgeben?

"Ich finde diese Idee von Künstlichen Intelligenzen, die unabhängig handeln, sich vor niemandem verantworten müssen und niemandes Kontrolle unterliegen, ist einfach töricht. Es klingt einfach nach einer schlechten Idee."

Paul Scharre von dem Washingtoner Think Tank Center for a New American Security. Er hat seine Meinung auch in einer Artikelsammlung der UN aufgeschrieben. Darin heißt es:

"Wenn autonome Systeme zu mehr Kontrolle im Krieg führen, wäre das wünschenswert. Maschinen zu erlauben, eine Aufgabe selbstständig zu erledigen, kann menschliche Kontrolle über das Ergebnis verbessern."

Als Beispiel nennt er Heizungsthermostate, die die Raumtemperatur automatisch regeln oder Anti-Kollisionssysteme im Auto, die dem Fahrer kurzzeitig die Kontrolle entziehen, aber dadurch für Stabilität sorgen.

"Autonome Waffen könnten Staatsführern mehr Kontrolle darüber geben, wie sich ihre Truppen in einer Krisensituation verhalten. Ein autonomes System könnte der perfekte Soldat sein, der sich niemals einem Befehl widersetzt."

Robotern fehlt menschliches Einfühlungsvermögen

Andererseits könnte es eine Krise verschärfen, wenn das System sich nicht gut an aktuelle Entwicklungen anpassen kann. Vor allem wird den Robotern wohl menschliches Einfühlungsvermögen fehlen. Wolfgang Richter:

"Eine Maschine kennt natürlich weder Angst noch Hass noch Verzweiflung. Aber eine Maschine kennt natürlich auch nicht das, was wir als Empathie bezeichnen. Das menschliche Einfühlungsvermögen ist gelegentlich dem humanitären Völkerrecht mehr entsprechend als die Maschine."

Ob Kampfroboter verboten werden oder nicht, das wird diese Woche in Genf noch nicht entschieden werden. Aber auch langfristig stehen die Chancen dafür nicht gut.

Ob Kampfroboter verboten werden oder nicht, das wird diese Woche in Genf noch nicht entschieden werden. Aber auch langfristig stehen die Chancen dafür nicht gut.

Wahrscheinlicher ist ein Kompromiss: Dass die technische Entwicklung genau beobachtet wird, dass man im Austausch darüber bleibt, dass man sich dazu bekennt, dass das Völkerrecht gilt und Menschen, die autonome Systeme einsetzen, für deren Handlungen verantwortlich sind.