Akustische Überwachung im öffentlichen Raum

Das akustische Überwachungssystem ShotSpotter wird in den USA bereits großflächig eingesetzt. Fällt ein Schuss, alarmiert das System die Polizei. Doch aufgezeichnet wird auch alles andere, etwa Gespräche. In Deutschland wird bereits zu der Technik geforscht.

Im März 2015 trat New Yorks Bürgermeister Bill de Blasio vor die Presse, um bekanntzugeben, dass die Stadt eine neue Technologie eingeführt habe um das Verbrechen zu bekämpfen.

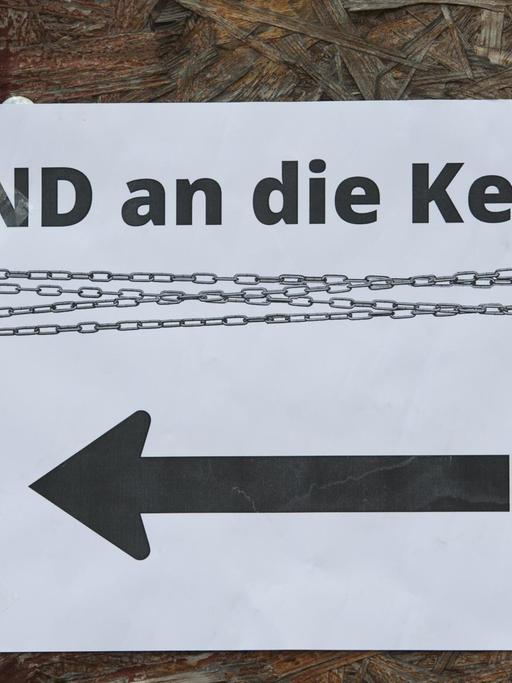

"It's going to send a message out into our communities that if you fire a weapon, the police is going to know instantly, so there is going to be a deterrent effect."

Es ginge darum, eine Botschaft an die Bürger auszusenden, sagte de Blasio: Von nun an wüsste es die Polizei sofort, wenn irgendwo in der Stadt eine Waffe abgefeuert wird —das solle abschreckend wirken.

Zuvor wurde an verschiedenen Stellen in der Stadt ein Netzwerk aus Mikrofonen angebracht. Sobald diese einen Schuss erkennen, übermitteln sie den Standort automatisch an die Polizei. Dieses Netzwerk basiert auf dem Überwachungssystem "ShotSpotter", das von einer Firma aus Kalifornien entwickelt wurde.

In Werbespots preist der Hersteller das Überwachungssystem als eine Art Geheimwaffe: als mögliche Lösung für die von Schießereien geplagten Städte des Landes. Nach wie vor ist die Waffengewalt in den USA beträchtlich höher als in allen anderen entwickelten Industriestaaten.

Doch trotz hoher Kriminalität gibt es in den USA auch Stimmen, die das Überwachungssystem kritisch sehen. Diskutiert wird zum Beispiel, inwieweit die Mikrofone neben Schüssen auch andere Geräusche aufnehmen, Gespräche beispielsweise. Der Verdacht ist nicht aus der Luft gegriffen: 2014 machte ein Fall aus der kalifornischen Stadt Oakland von sich reden.

Vier Jahre zuvor war ein Mann auf offener Straße von einem Schuss getroffen worden. Unmittelbar danach rief das Opfer den Spitznamen des Täters. Das Mikrofon von "ShotSpotter", das durch den Schuss aktiviert worden war, nahm sowohl die Schüsse, als auch die Worte des Sterbenden auf. Vor Gericht wurde die Aufnahme als Beweismittel verwendet um den Mörder des Mannes zu identifizieren.

Insgesamt 300 Audio-Sensoren hat die Stadt New York nun in verschiedenen Problembezirken angebracht. Rund 39 Quadratkilometer der Stadt stehen so nun unter akustischer Überwachung - ungefähr die Fläche von Berlin-Mitte. Höchstwahrscheinlich sollen weitere Flächen folgen.

New York kam mit der Initiative ziemlich spät. Vor knapp zehn Jahren installierte die erste Gemeinde der USA "ShotSpotter. Seitdem haben immer mehr Städte und Kommunen in den USA das System übernommen.

Ralph Clark: "Over 300 Square Miles is currently being monitored."

Über 300 Quadrat-Meilen, rund 780 Quadratkilometer, seien mittlerweile unter Überwachung durch "ShotSpotter, sagt Ralph Clark, Vostand bei SST, der Firma, die "ShotSpotter herstellt. Das ist etwas mehr als die Fläche der Stadt Hamburg.

In Deutschland wird an "Schallwächtern" für Krankenzimmer geforscht

Und die Firma hat vor, auch international zu expandieren. In Brasilien, Panama und im südafrikanischen Capetown sei "ShotSpotter" mittlerweile im Einsatz, sowie im Krüger-Nationalpark, wo durch die Technologie Wilderern das Handwerk gelegt werden soll. Auch eine Expansion nach Europa und Deutschland ist geplant.

Seit den frühen 1990er-Jahren wird an Schusserkennungs-Technologien wie "ShotSpotter gearbeitet. Ihnen zugrunde liegen Systeme zur akustischen Ereigniserkennung. Vor allem in den letzten zehn Jahren hat sich in dem Feld viel getan.

Stefan Götze: "Die Erkenner sind deutlich robuster geworden. Einerseits durch die erhöhte Computerleistung. Das heißt, insbesondere für eingebettete Systeme, für Mini-Computer. Da ist die Rechenleistung sehr hochgegangen. Und zweitens ist im Bereich sehr viel Forschung hereingegangen. Man hat da zum Beispiel neue Merkmale entwickelt: Beschreibungsformen des Signals, mit denen die Erkenner viel bessere Entscheidungen treffen können."

Stefan Götze ist Gruppenleiter beim Fraunhofer-Institut für Digitale Medientechnologie - im norddeutschen Oldenburg, weit weg von New York. Hier forschen seine Kollegen und er vor allem zur Spracherkennung und zur akustischen Ereigniserkennung: Das heißt, wie Maschinen und Systeme Geräusche - wie beispielsweise Schüsse - erkennen können.

"Diese automatische Schusserkennung ist natürlich ein Anwendungsszenario, was einem ziemlich schnell einfällt. Es ist in Deutschland nicht ganz so ein Problem, weil hier ziemlich wenig geschossen wird."

Systeme zur Kriminalitätsverhinderung spielen daher für Götze und seine Kollegen eine eher untergeordnete Rolle. Sie forschen und entwickeln vor allem sogenannte "Schallwächter" zum Beispiel, die in Krankenzimmern von Demenzpatienten angebracht werden.

"Bei den Systemen, die wir entwickeln, wird so etwas erkannt wie ein Ruf nach der Schwester, brechendes Glas. Ein Sturz ist immer etwas, was man sehr gerne erkennen will. Leider stürzen die Menschen ziemlich leise. Wir haben Husten erkannt, um zu unterscheiden, ist das jetzt produktiver Huster oder eher trockener Husten."

Husten ist nicht gleich Husten - das Beispiel erklärt sehr gut, worum es in der akustischen Ereigniserkennung vor allem geht:

"Wenn jemand einmal hustet, ist das überhaupt kein Problem, da braucht deswegen nicht die Schwester kommen. Wenn jemand aber innerhalb von 30 Sekunden - ich übertreibe jetzt mal - 70 mal hustet, dann ist das ein Hustenanfall und dann kann vielleicht eine Schwester kommen."

Der akustischen Überwachung bleibt weniger verborgen als der visuellen

Es geht also nicht nur darum, dass Systeme Ereignisse aufnehmen, sondern dass sie sie erkennen und Entscheidungen treffen.

"Wir nehmen das Signal immer erstmal auf mit dem Mikrofon. Dann wird es analysiert um zu sehen, welche Ereignisse sind da drin, zum Beispiel ein Huster. Und danach kommt immer noch eine Intelligenz, die irgendeine Entscheidung fällt auf vorher gegebenen Regeln. Zum Beispiel: Ein Huster kein Problem — viele Huster, vielleicht ein Problem."

Trotz unbestreitbarem Nutzen: Die Systeme der Ereigniserkennung bleiben Instrumente der Überwachung. Sie funktionieren, weil Mikrofone im Raum installiert sind, die durchgehend aufnehmen, was geschieht - auch wenn viele Daten nur kurz und verschlüsselt gespeichert werden. Was bedeutet das für die Privatsphäre?

"Wir haben Studien gemacht und oft wird eine akustische Überwachung sehr viel besser akzeptiert als eine Video-Überwachung. Man muss dazu sagen, dass das ganze immer auch von dem Leidensdruck abhängt. Also wenn jemand zum Beispiel gestürzt ist und sich einmal die Hüfte gebrochen hat, dann hat er zum Beispiel auch keine Problem mehr, dass eine Kamera im Bad filmt. Aber wenn man Leute mit weniger Leidensdruck befragt, dann ist das so, dass man möglichst wenig überwacht werden will. Deshalb achten wir bei unseren System sehr darauf, was man so Privacy by Design nennt. Also das Audio-Signal verbleibt immer nur im Gerät. Und wird niemals nach draußen abhörbar gemacht. Und wirklich nur das Notfallerereignis wird signalisiert. Also es wird nur nach außen geschickt, hier war ein Notfall. Und auf keinen Fall sensitive Daten."

Und in Zukunft? Die Systeme, die momentan im Einsatz sind, können - grob gesprochen - in der Regel bis zu 25 verschiedene Ereignisse erkennen. Das klingt erstmal viel. Doch viele Szenarios, vor allem im Freien, sind deutlich komplexer.

"Stellen Sie sich vor, Sie sind draußen, da fährt ein Zug vorbei, da rauscht der Wind durch die Blätter, da hupt ein Auto und alles passiert gleichzeitig. Sie müssen also viel, viel mehr als 25 Events auseinanderhalten können. Das sind dann Hunderte oder Tausende. Das ist natürlich unser Ziel. Da muss man aber sagen, da ist auch noch viel Forschungsarbeit zu tun."

Die akustische Ereigniserkennung scheint erst am Anfang zu stehen, und ihr Potential wirkt riesig. Zumal der akustischen Überwachung viel weniger verborgen bleibt als der visuellen Überwachung. Um eine Ecke sehen kann man nur mit großer Anstrengung - "um die Ecke hören" dagegen kann jeder problemlos.