Auch der Künstler und Netzaktivist Padeluun plädiert für Entwarnung. Er bezweifelt, ob Gesichtserkennungssoftware schon so gut funktioniert, wie einige Hersteller behaupten.

Überwachung am Arbeitsplatz

Verrät unsere Chatsoftware unseren Chefs bald, wie wir uns fühlren? © imago images / Ikon Images

Emotionserkennung im Videochat

09:46 Minuten

Zoom und andere Videocall-Anbieter versprechen, die Emotionen der Teilnehmenden zu erkennen. Das ist nicht nur gefährlich, sondern zeugt von einem Technologie-Fetisch im Silicon Valley, sagt Bürgerrechtsaktivist Daniel Leufer.

Seit Beginn der Pandemie sind sie für viele zum Berufsalltag geworden: Videocalls. Diese Popularität hat die Anbieter von Meetingsoftware einerseits sehr reich gemacht, andererseits aber auch zu großem Konkurrenzdruck in dem Wachstumsmarkt geführt. Dementsprechend versuchen die Hersteller Alleinstellungsmerkmale für ihre Programme zu finden. So auch der Platzhirsch "Zoom", der laut einem Bericht des Magazins “Protocol” plant, in Zukunft die Emotionen der Teilnehmenden zu analysieren.

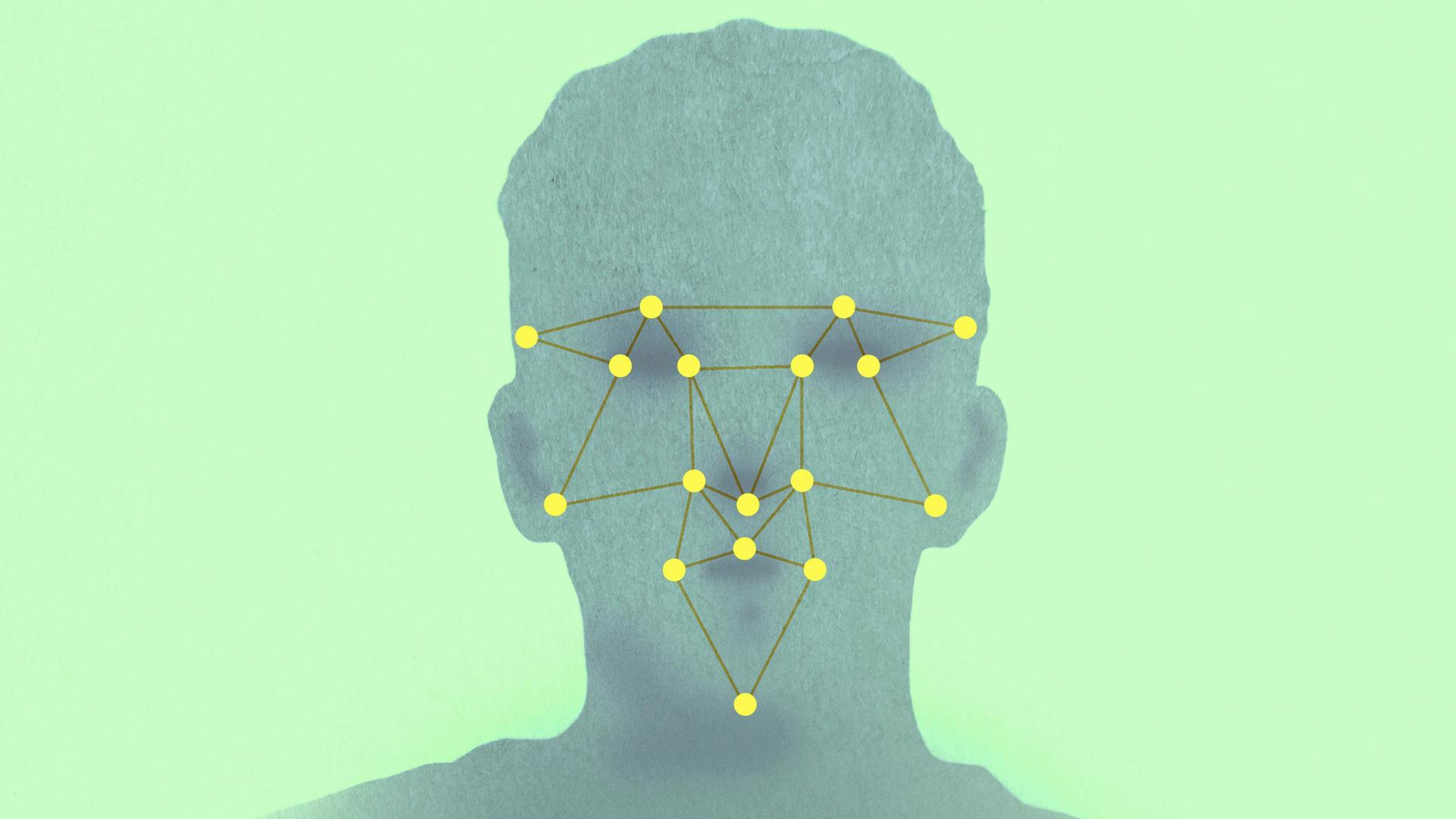

Menschenrechtsorganisationen warnen vor dem Missbrauchspotenzial solcher Technologien. So zum Beispiel Daniel Leufer von “Access Now”. Er hält schon das Versprechen für falsch. Künstliche Intelligenz sei zwar in der Lage Lippen zu lesen, doch es sei bislang unmöglich, Emotionen akkurat zu erkennen.

Die Probleme mit KI beginnen schon beim Training

Die Unternehmen verkauften eine Technologie, die beispielsweise bei Vorstellungsgesprächen einen tiefen Einblick in den Kandidaten verspreche, so Leufer. Diese sei preiswerter, als qualifizierte Menschen mit der Analyse des Interviews zu betrauen. Doch Auswirkungen auf die Jobsuche sind nicht das größte Problem, das Leufer sieht.

So gebe es bereits Unternehmen, die eine solche Überwachungsmöglichkeit für Schülerinnen und Schüler im Fernunterricht anbieten. Damit sollen Lehrkräfte ein Feedback darüber erhalten, wie auf das Lehrmaterial reagiert wurde. Doch diese Daten könnten auch in die Beurteilung des Gegenübers einfließen, so Leufer.

“Wir haben in den letzten Jahren gesehen: Wenn KI-Systeme im Kontext von Unterricht eingeführt wurden, hatten sie sehr negative Auswirkungen", sagt der Digitalexperte. "Sie wurden genutzt, um die Leistung von Lehrern zu beurteilen. Grundsätzlich würde ich sagen: Je komplexer die Aufgabe ist, die die KI erledigen soll, desto unwahrscheinlicher ist es, dass sie das tatsächlich kann.”

Mehr Vorsicht ist geboten

Die bereits am Markt verfügbaren Systeme würden dabei versprechen, zwischen sieben und neun Emotionen erfassen zu können. Doch das Problem beginne schon bei den Daten, mit denen die KI trainiert werden soll. Denn diese stammten oft von Schauspielerinnen und Schauspielern mit überdeutlichen, unnatürlichen Gesichtsausdrücken.

Dazu kämen weitere wissenschaftliche und philosophische Probleme bei der Datensammlung von Emotionen: “Wir waren alle schon in Situationen, in denen wir vorgegeben haben, uns über ein Geburtstagsgeschenk zu freuen, das uns nicht gefiel", so Leufer. "Wir wissen also, dass wir bei Emotionen auch lügen können."

Es gebe eine Beziehung zwischen Gesichtsausdrücken und dem emotionalen Zustand. "Aber es ist nicht so einfach, es ist keine Eins-zu-Eins-Beziehung, und die Theorien, auf denen diese Emotionserkennungssysteme aufbauen, sind extrem einfach.”

Drang nach Innovation um jeden Preis

Leufer sieht in solchen Produkten eine Art Technologiefetisch der Risikokapitalgeber im Silicon Valley. Sie seien immer auf der Suche nach der nächsten Sache, die von Künstlicher Intelligenz erledigt werden könne und versuchten, diese dann in jedem Aspekt unserer Gesellschaft unterzubringen, um angeblich die Produktivität zu steigern. Dieser Drang nach Innovation um jeden Preis führe oft dazu, dass schädliche Technologie entsteet, die nicht existieren würde, wenn wir vorsichtiger wären.

(hte)

(hte)